- Запрет индексации сайта поисковыми системами. Самостоятельно проверяем и меняем файл robots.txt. Зачем закрывать сайт от индексации?

- Зачем закрывать сайт от индексации? Проверяем и меняем файл robots.txt самостоятельно.

- Оглавление

- Процесс индексации

- Зачем закрывать сайт от индексации

- Закрываем сайт от индексации в robots.txt

- Инструкция по изменению файла robots.

- Проверка корректности закрытия сайта от индексации

- Альтернативные способы закрыть сайт от поисковых систем

- Заключение

- Метатег robots | Закрыть страницу от индексации

- Метатег robots

- nofollow (Яндекс & Google)

- rel=»nofollow» – не переходить по ссылке

- content=»nofollow» – не переходить по всем ссылкам на странице

- Действие атрибутов rel=»nofollow» и content=»nofollow»

- noindex – не индексировать текст

- Тег <noindex> – не признанное изобретение Яндекса

- Тег <noindex> – не индексировать кусок текста

- Метатег noindex – не индексировать текст всей страницы

- Разница в действии тега и метатега noindex

- Особенности метатега noindex

- Тег и метатег noindex для Google

- Универсальный метатег (Яндекс & Google)

- Почему метатег robots лучше файла robots.

- Как закрыть контент от индексации — пошаговое руководство

- Как правильно настроить robots.txt — Академия SEO (СЕО)

- Как закрыть сайт от индексации: краткое руководство

- Файл robots.

- Индексация сайта

- Robots.txt — директива user-agent и боты поисковых систем

- Примеры использования директив Disallow и Allow в роботс.тхт

- Директивы Sitemap и Host (для Яндекса) в Robots.txt

- Проверка robots.txt в Яндекс и Гугл вебмастере

- Мета-тег Robots — помогает закрыть дубли контента при индексации сайта

- Как создать правильный роботс.тхт?

- Какие страницы закрывать от индексации и как

- Блокировать страницы или сообщения блога от индексации поисковыми системами

- Руководство для новичков по блокировке URL-адресов в роботах.txt файл | Ignite Visibility

- Все, что вам нужно знать

- Что такое файл Robots.txt?

- Где найти файл Robots.txt

- Как собрать файл Robots.txt

- Robots.txt Синтаксис

- Зачем использовать Robots.txt

- Noindex

- Noindex против Disallow

- Использование регулярных выражений и подстановочных знаков

- Ошибок, которых следует избегать

- Не блокировать хороший контент

- Чрезмерное использование Crawl-Delay

- Чувствительность к регистру

- Использование Robots.txt для предотвращения индексации содержимого

- Использование Robots.txt для защиты личного содержимого

- Использование Robots.txt для скрытия вредоносного дублированного содержимого

- Вот три способа справиться с этим типом контента:

- Момент истины: проверка вашего файла Robots.txt

- Как запретить поисковым системам сканировать ваш веб-сайт — Центр поддержки хостинга InMotion

- Google прекращает поддержку Robots.txt Noindex: что это значит

- Robots.txt: как создать идеальный файл для SEO

- Что такое Robots.txt?

- User-agent и основные директивы

- Почему Robots.txt важен для SEO?

- Robots.txt и Мета-теги роботов

- Как найти Robots.txt?

- Как создать Robots.txt

- Лучшие практики оптимизации Robots.txt для SEO

- Как проверить файл robots.txt

- Распространенные ошибки в файлах Robots.txt

- Как закрыть страницу из индексации в Robots.txt

- Управление файлами Robots.txt и Sitemap

Запрет индексации сайта поисковыми системами. Самостоятельно проверяем и меняем файл robots.txt. Зачем закрывать сайт от индексации?

Зачем закрывать сайт от индексации? Проверяем и меняем файл robots.txt самостоятельно.

Ответ

Для закрытия всего сайта от индексации во всех поисковых системах необходимо в файле robots.txt прописать следующую директиву:

Disallow: /

Далее, подробнее разберемся в вопросе подробнее и ответим на другие вопросы:

- Процесс индексации что это?

- Зачем закрывать сайт от индексации?

- Инструкции по изменению файла robots.txt

- Проверка корректности закрытия сайта от индексации

- Альтернативные способы закрыть сайт от поисковых систем

Оглавление

Процесс индексации

Индексация сайта – это процесс добавления данных вашего ресурса в индексную базу поисковых систем. Ранее мы подробно разбирали вопрос индексации сайта в Яндекс и Google.

Ранее мы подробно разбирали вопрос индексации сайта в Яндекс и Google.

Именно в этой базе и происходит поиск информации в тот момент, когда вы вводите любой запрос в строку поиска:

Именно из индексной базы поисковая система в момент ввода запроса производит поиск информации.Если сайта нет в индексной базе поисковой системе = тогда сайте нет и в поисковой выдаче. Его невозможно будет найти по поисковым запросам.

В каких случаях может потребоваться исключать сайт из баз поисковых систем?

Зачем закрывать сайт от индексации

Причин, по которым необходимо скрыть сайт от поисковых систем может быть множество. Мы не можем знать личных мотивов всех вебмастеров. Давайте выделим самые основные объективные причины, когда закрытие сайта от индексации оправданно.

Сайт еще не готов

Ваш сайт пока не готов для просмотра целевой аудиторией. Вы

находитесь в стадии разработки (или доработки) ресурса. В таком случае его

лучше закрыть от индексации. Тогда сырой и недоработанный ресурс не попадет в

индексную базу и не испортит «карму» вашему сайту. Открывать сайт лучше после его полной

готовности и наполненности контентом.

В таком случае его

лучше закрыть от индексации. Тогда сырой и недоработанный ресурс не попадет в

индексную базу и не испортит «карму» вашему сайту. Открывать сайт лучше после его полной

готовности и наполненности контентом.

Сайт узкого содержания

Ресурс предназначен для личного пользования или для узкого круга посетителей. Он не должен быть проиндексирован поисковыми системами. Конечно, данные такого ресурса можно скрыть под паролем, но это не всегда необходимо. Часто, достаточно закрыть его от индексации и избавить от переходов из поисковых систем случайных пользователей.

Переезд сайта или аффилированный ресурс

Вы решили изменить главное зеркало сайта. Мы закрываем от индексации старый домен и открываем новый. При этом меняем главное зеркало сайта. Возможно у Вас несколько сайтов по одной теме, а продвигаете вы один, главный ресурс.

Стратегия продвижения

Возможно, Ваша стратегия предусматривает продвижение ряда доменов, например, в разных регионах или поисковых системах.

Другие мотивы

Может быть целый ряд других личных причин закрытия сайта от индексации поисковыми системами. Можете написать в комментариях Вашу причину закрытия сайта от индексации.

Закрываем сайт от индексации в robots.txt

Обращение к Вашему сайту поисковой системой начинается с прочтения содержимого файла robots.txt. Это служебный файл со специальными правилами для поисковых роботов.

Подробнее о директивах robots.txt:

Самый простой и быстрый способ это при первом обращении к вашему ресурсу со стороны поисковых систем (к файлу robots.txt) сообщить поисковой системе о том, что этот сайт закрыт от индексации. В зависимости от задач, сайт можно закрыть в одной или нескольких поисковых системах. Вот так:

| Закрыть во всех системах | Закрыть только в Яндекс | Закрыть только в Google |

| User-agent: * Disallow: / | User-agent: Yandex Disallow: / | User-agent: Googlebot Disallow: / |

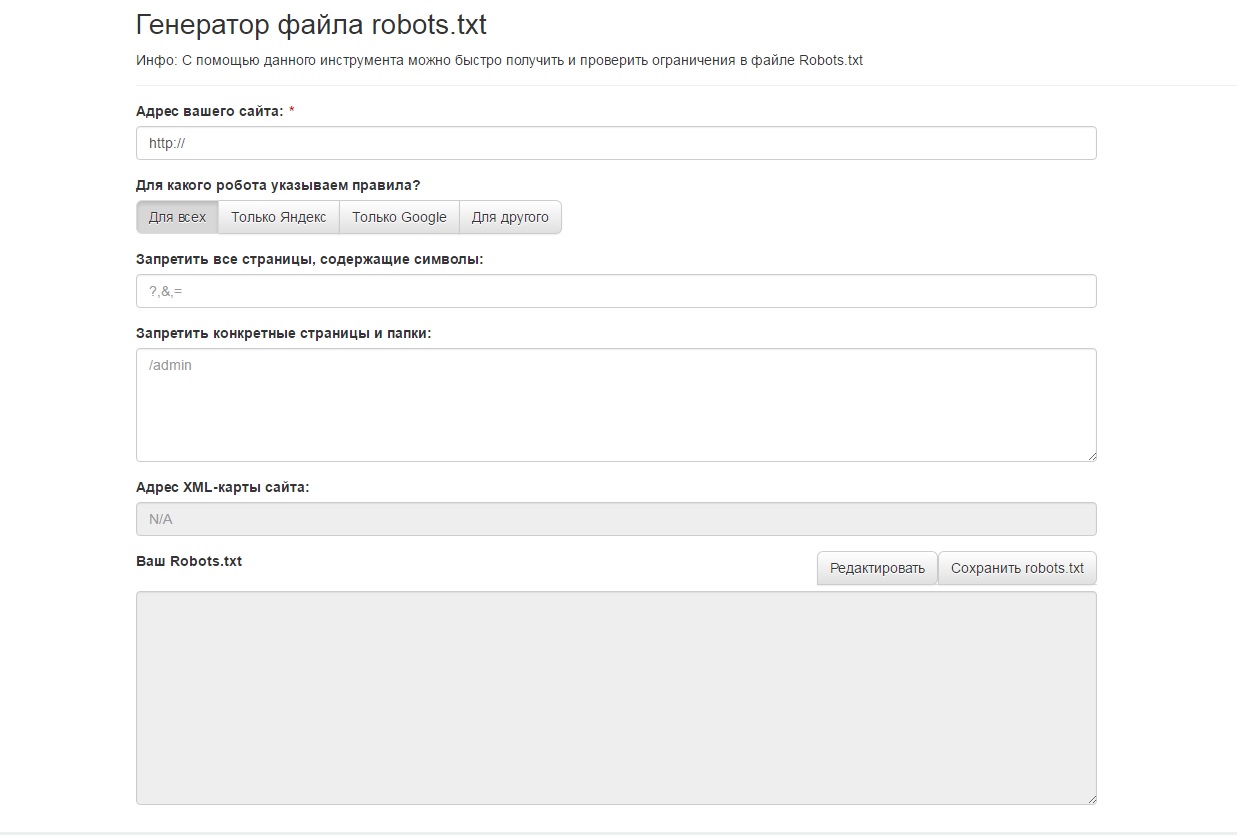

Инструкция по изменению файла robots.

txt

txtМы не ставим целью дать подробную инструкцию по всем способам подключения к хостингу или серверу, укажем самый простой способ на наш взгляд.

Файл robots.txt всегда находится в корне Вашего сайта. Например, robots.txt сайта iqad.ru будет находится по адресу:

Для подключения к сайту, мы должны в административной панели нашего хостинг провайдера получить FTP (специальный протокол передачи файлов по сети) доступ: <ЛОГИН> И <ПАРОЛЬ>.

Авторизуемся в панели управления вашим хостингом и\или сервером, находим раздел FTP и создаем ( получаем ) уникальную пару логин \ пароль.В описании раздела или в разделе помощь, необходимо найти и сохранить необходимую информацию для подключения по FTP к серверу, на котором размещены файлы Вашего сайта. Данные отражают информацию, которую нужно указать в FTP-клиенте:

- Сервер (Hostname) – IP-адрес сервера, на котором размещен Ваш аккаунт

- Логин (Username) – логин от FTP-аккаунта

- Пароль (Password) – пароль от FTP-аккаунта

- Порт (Port) – числовое значение, обычно 21

Далее, нам потребуется любой FTP-клиент, можно

воспользоваться бесплатной программой filezilla (https://filezilla. ru/).

Вводим данные в соответствующие поля и нажимаем подключиться.

ru/).

Вводим данные в соответствующие поля и нажимаем подключиться.

После подключения прописываем необходимые директивы. См.

раздел:

Закрываем сайт от индексации в robots.txt

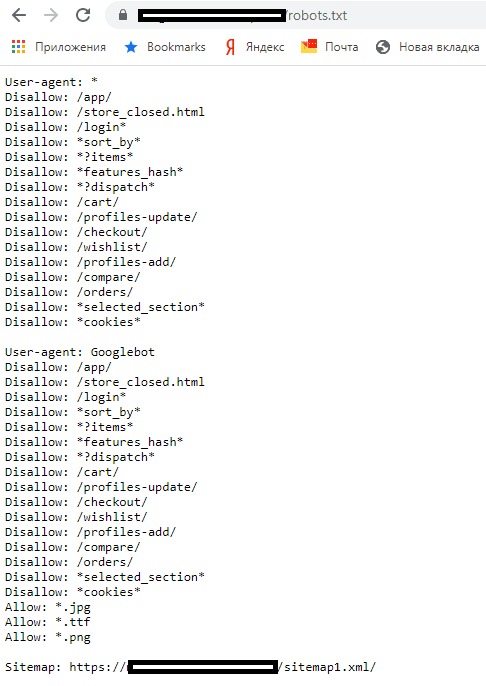

Проверка корректности закрытия сайта от индексации

После того, как вы внесли все необходимые коррективы в файл robots.txt необходимо убедится в том, что все сделано верно. Для этого открываем файл robots.txt на вашем сайте.

Инструменты iqadВ арсенале команды IQAD есть набор бесплатных инструментов для SEO-оптимизаторов. Вы можете воспользоваться бесплатным сервисом просмотра файла robots.txt:

Проверить индексацию

Открыть самостоятельно, файл находится корне Вашего сайта, по адресу:

www. site.ru/robots.txt

site.ru/robots.txt

Где www.site.ru – адрес Вашего сайта.

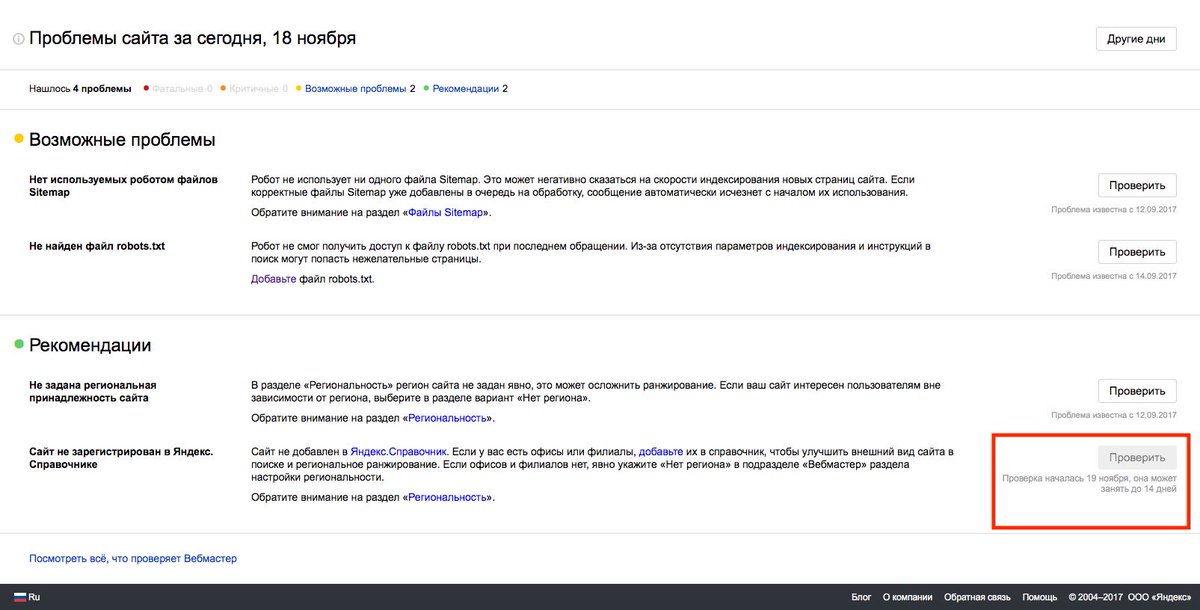

Сервис Я.ВЕБМАСТЕРБесплатный сервис Я.ВЕБМАСТЕР – анализ robots.txt.

Бесплатный сервис ЯНДЕКС.ВЕБМАСТЕР проверит ваш robots.txt, покажет какими секциями Вашего файла пользуется поисковая система Яндекс:

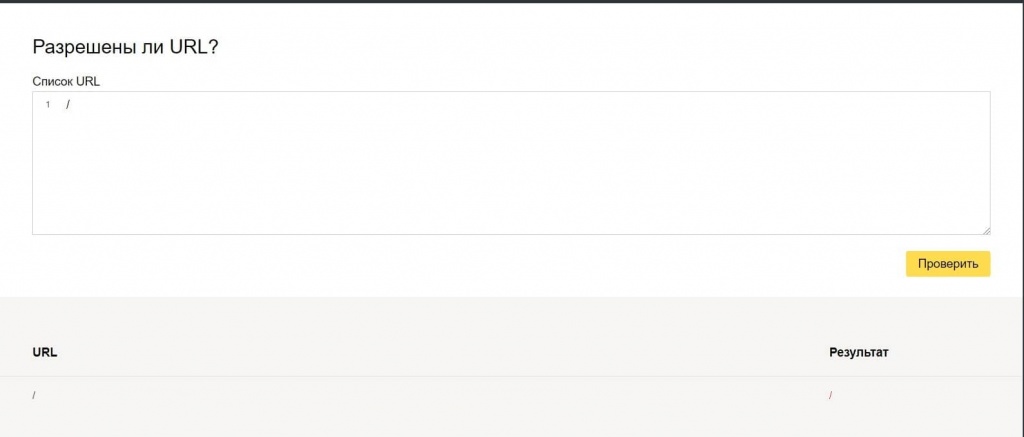

Так же, в сервисе можно проверить запрещена ли та или иная страница вашего сайта к индексации:

Достаточно в специальное поле внести интересующие Вас страницы и ниже отобразится результат.Альтернативные способы закрыть сайт от поисковых систем

- Вы можете

отдавать поисковым роботам отличный от 200 код ответа сервера. Но это не

гарантирует 100% исключения сайта из индекса. Какое-то время робот может

хранить копию Ваших страниц и отдавать именно их.

- С помощью специального meta тега: <meta name=”robots”>

<meta name=”robots” content=”noindex, nofollow”>

Недостатком этого может быть несовершенство поисковых систем и проблемы с индексацией ресурса. Пока робот не переиндексирует весь сайт, а на это может потребоваться много времени, иногда несколько месяцев, часть страниц будет присутствовать в поиске.

- Использование

технологий, усложняющих индексацию Вашего сайта. Вы можете спрятать контент

Вашего сайта под AJAX или скриптами. Таким образом поисковая система не сможет

увидеть контент сайта. При этом по названию сайта или по открытой части в

индексе поисковиков может что-то хранится. Более того, уже завра новое

обновление поисковых роботов может научится индексировать такой контент.

- Скрыть все данные Вашего сайта за регистрационной формой. При этом стартовая страница в любом случае будет доступна поисковым роботам.

Заключение

Самым простым способом закрыть сайт от индексации, во всех поисковых системах, необходимо в файле robots.txt прописать следующую директиву:

Disallow: /

«robots.txt» это служебный файл со специальными правилами для поисковых роботов.

Файл robots.txt всегда находится в корне Вашего сайта. Для изменения директив файла Вам потребуется любой FTP-клиент.

Помимо классического способа с использованием файла robots.txt можно прибегнуть и к другим, не стандартным, подходам. Однако у них есть ряд недостатков. Для проверки текущих директив Вашего сайта предлагаем воспользоваться бесплатным сервисом просмотра файла robots.txt:

Проверить индексацию

Метатег robots | Закрыть страницу от индексации

Статья для тех, кому лень читать справку по GoogleWebmaster и ЯндексВебмастер

Закрывание ненужных страниц веб-ресурса от поисковой индексации очень важно для его SEO-оптимизации, особенно на начальном этапе становления сайта или блога «на ноги». Такое действие способствует продвижению в SERP (СЕРП) и рекомендовано к применению для служебных страниц. К служебным страницам относятся технические и сервисные страницы, предназначенные исключительно для удобства и обслуживания уже состоявшихся клиентов. Эти страницы с неудобоваримым или дублирующим контентом, который не представляет абсолютно никакой поисковой ценности. Сюда входят – пользовательская переписка, рассылка, статистика, объявления, комментарии, личные данные, пользовательские настройки и т.д. А, также – страницы для сортировки материала (пагинация), обратной связи, правила и инструкции и т.п. Такое действие способствует продвижению в SERP (СЕРП) и рекомендовано к применению для служебных страниц. К служебным страницам относятся технические и сервисные страницы, предназначенные исключительно для удобства и обслуживания уже состоявшихся клиентов. Эти страницы с неудобоваримым или дублирующим контентом, который не представляет абсолютно никакой поисковой ценности. Сюда входят – пользовательская переписка, рассылка, статистика, объявления, комментарии, личные данные, пользовательские настройки и т.д. А, также – страницы для сортировки материала (пагинация), обратной связи, правила и инструкции и т.п. |

- Метатег robots

- Почему метатег robots лучше файла robots.txt

Метатег robots

Для управления поведением поисковых роботов на веб-странице, в HTML существует метатег robots и его атрибут content. закрытия веб-страницы от поисковой индексации,

nofollow и noindex – самые загадочные персонажи разметки html-страницы, главная задача которых состоит в запрете индексирования ссылок и текстового материала веб-страницы поисковыми роботами.

nofollow (Яндекс & Google)

nofollow – валидное значение в HTML для атрибута rel тега «a» (rel=»nofollow») |

rel=»nofollow» – не переходить по ссылке

Оба главных русскоязычных поисковика (Google и Яндекс) – прекрасно знают атрибут rel=»nofollow» и, поэтому – превосходно управляются с ним. В этом, и Google, и Яндекс, наконец-то – едины. Ни один поисковый робот не пойдёт по ссылке, если у неё имеется атрибут rel=»nofollow»:

<a href=»http://example.ru» rel=»nofollow»>анкор (видимая часть ссылки)</a>

content=»nofollow» – не переходить по всем ссылкам на странице

Допускается указывать значение nofollow для атрибута content метатега <meta>.

В этом случае, от поисковой индексации будут закрыты все ссылки на веб-странице

<meta name=»robots» content=»nofollow»/>

Атрибут content является атрибутом тега <meta> (метатега). Метатеги используются для хранения информации, предназначенной для браузеров и поисковых систем. Все метатеги размещаются в контейнере <head>, в заголовке веб-страницы.

Метатеги используются для хранения информации, предназначенной для браузеров и поисковых систем. Все метатеги размещаются в контейнере <head>, в заголовке веб-страницы.

Действие атрибутов rel=»nofollow» и content=»nofollow»

на поисковых роботов Google и Яндекса

Действие атрибутов rel=»nofollow» и content=»nofollow»

на поисковых роботов Google и Яндекса несколько разное:

- Увидев атрибут rel=»nofollow» у отдельно стоящей ссылки, поисковые роботы Google не переходят по такой ссылке и не индексируют её видимую часть (анкор). Увидев атрибут content=»nofollow» у метатега <meta> в заголовке страницы, поисковые роботы Google сразу «разворачивают оглобли» и катят к себе восвояси, даже не пытаясь заглянуть на такую страницу. Таким образом, чтобы раз и навсегда закрыть от роботов Google отдельно стоящую ссылку (тег <а>) достаточно добавить к ней атрибут rel=»nofollow»:

<a href=»http://example. ru» rel=»nofollow»>Анкор</a>

ru» rel=»nofollow»>Анкор</a>

А, чтобы раз и навсегда закрыть от роботов Google всю веб-страницу,

достаточно добавить в её заголовок строку с метатегом:

<meta name=»robots» content=»nofollow»/> - Яндекс

- Для роботов Яндекса атрибут rel=»nofollow» имеет действие запрета только! на индексацию ссылки и переход по ней. Видимую текстовую часть ссылки (анкор) – роботы Яндекса всё равно проиндексируют.

Для роботов Яндекса атрибут метатега content=»nofollow» имеет действие запрета только! на индексацию ссылок на странице и переходов по них. Всю видимую текстовую часть веб-страницы – роботы Яндекса всё равно проиндексируют.

Для запрета индексации видимой текстовой части ссылки или страницы для роботов Яндекса – ещё потребуется добавить его любимый тег или значение noindex

noindex – не индексировать текст

(тег и значение только для Яндекса)

Тег <noindex> не входит в спецификацию HTML-языка.

Тег <noindex> – это изобретение Яндекса, который предложил в 2008 году использовать этот тег в качестве маркера текстовой части веб-страницы для её последующего удаления из поискового индекса. Поисковая машина Google это предложение проигнорировала и Яндекс остался со своим ненаглядным тегом, один на один. Поскольку Яндекс, как поисковая система – заслужил к себе достаточно сильное доверие и уважение, то придётся уделить его любимому тегу и его значению – должное внимание.

Тег <noindex> – не признанное изобретение Яндекса

Тег <noindex> используется поисковым алгоритмом Яндекса для исключения служебного текста веб-страницы поискового индекса. Тег <noindex> поддерживается всеми дочерними поисковыми системами Яндекса, вида Mail.ru, Rambler и иже с ними.

Тег noindex – парный тег, закрывающий тег – обязателен!

Учитывая не валидность своего бедного и непризнанного тега,

Яндекс соглашается на оба варианта для его написания:

Не валидный вариант – <noindex></noindex>,

и валидный вариант – <!— noindex —><!—/ noindex —>.

Хотя, во втором случае – лошади понятно, что для гипертекстовой разметки HTML, это уже никакой не тег, а так просто – html-комментарий на веб-странице.

Тег <noindex> – не индексировать кусок текста

Как утверждает справка по Яндекс-Вебмастер, тег <noindex> используется для запрета поискового индексирования служебных участков текста. Иными словами, часть текста на странице, заключённая в теги <noindex></noindex> удаляется поисковой машиной из поискового индекса Яндекса. Размеры и величина куска текста не лимитированы. Хоть всю страницу можно взять в теги <noindex></noindex>. В этом случае – останутся в индексе одни только ссылки, без текстовой части.

Поскольку Яндекс подходит раздельно к индексированию непосредственно самой ссылки и её видимого текста (анкора), то для полного исключения отдельно стоящей ссылки из индекса Яндекса потребуется наличие у неё сразу двух элементов – атрибута rel=»nofollow» и тега <noindex>. Такой избирательный подход Яндекса к индексированию ссылок даёт определённую гибкость при наложении запретов.

Такой избирательный подход Яндекса к индексированию ссылок даёт определённую гибкость при наложении запретов.

Так, например, можно создать четыре конструкции, где:

- Ссылка индексируется полностью

- <a href=»http://example.ru»>Анкор (видимая часть ссылки)</a>

- Индексируется только анкор (видимая часть) ссылки

- <a href=»http://example.ru» rel=»nofollow»>Анкор</a>

- Индексируется только ссылка, без своего анкора

- <a href=»http://example.ru»><noindex>Анкор</noindex></a>

- Ссылка абсолютно НЕ индексируется

- <a href=»http://example.ru» rel=»nofollow»><noindex>Анкор</noindex></a>

Для справки: теги <noindex></noindex>, особенно их валидный вариант <!— noindex —><!—/ noindex —> – абсолютно не чувствительны к вложенности. Их можно устанавливать в любом месте HTML-кода. Главное, не забывать про закрывающий тег, а то – весь текст, до самого конца страницы – вылетит из поиска Яндекса.

Метатег noindex – не индексировать текст всей страницы

Допускается применять noindex в качестве значения для атрибута метатега content –

в этом случае устанавливается запрет на индексацию Яндексом текста всей страницы.

Атрибут content является атрибутом тега <meta> (метатег). Метатеги используются для хранения информации, предназначенной для браузеров и поисковых систем. Все метатеги размещаются в контейнере <head>, в заголовке веб-страницы.

Абсолютно достоверно, ясно и точно, что использование noindex в качестве значения атрибута content для метатега <meta> даёт очень хороший результат и уверенно «выбивает» такую страницу из поискового индекса Яндекса.

<meta name=»robots» content=»noindex»/>

Текст страницы, с таким метатегом в заголовке –

Яндекс совершенно не индексирует, но при этом он –

проиндексирует все ссылки на ней.

Разница в действии тега и метатега noindex

Визуально, разница в действии тега и метатега noindex заключается в том, что запрет на поисковую индексацию тега noindex распространяется только на текст внутри тегов <noindex></noindex>, тогда как запрет метатега – сразу на текст всей страницы.

Пример: <noindex>Этот текст будет не проиндексирован</noindex>

<meta name=»robots» content=»noindex»/>

Текст страницы, с таким метатегом – Яндекс полностью не индексирует

Принципиально, разница в действии тега и метатега проявляется в различиях алгоритма по их обработке поисковой машиной Яндекса. В случае с метатегом noindex, робот просто уходит со страницы, совершенно не интересуясь её содержимым (по крайней мере – так утверждает сам Яндекс). А, вот в случае с использованием обычного тега <noindex> – робот начинает работать с контентом на странице и фильтровать его через своё «ситечко». В момент скачивания, обработки контента и его фильтрации возможны ошибки, как со стороны робота, так и со стороны сервера. Ведь ни что не идеально в этом мире.

Поэтому, кусок текста страницы, заключённого в теги <noindex></noindex> – могёт запросто попасть Яндексу «на зуб» для дальнейшей поисковой индексации. Как утверждает сам Яндекс – это временное неудобство будет сохраняться до следующего посещения робота. Чему я не очень охотно верю, потому как, некоторые мои тексты и страницы, с тегом и метатегом noindex – висели в Яндексе по нескольку месяцев.

Как утверждает сам Яндекс – это временное неудобство будет сохраняться до следующего посещения робота. Чему я не очень охотно верю, потому как, некоторые мои тексты и страницы, с тегом и метатегом noindex – висели в Яндексе по нескольку месяцев.

Особенности метатега noindex

Равно, как и в случае с тегом <noindex>, действие метатега noindex позволяет гибко накладывать запреты на всю страницу. Примеры метатегов для всей страницы сдерём из Яндекс-Вебмастера:

- не индексировать текст страницы

- <meta name=»robots» content=»noindex»/>

- не переходить по ссылкам на странице

- <meta name=»robots» content=»nofollow»/>

- не индексировать текст страницы и не переходить по ссылкам на странице

- <meta name=»robots» content=»noindex, nofollow»/>

- что, аналогично следующему:

- запрещено индексировать текст и переходить

по ссылкам на странице для роботов Яндекса - <meta name=»robots» content=»none»/>

Вот такой он, тег и значение noindex на Яндексе :):):).

Тег и метатег noindex для Google

Что-же касается поисковика Google, то он никак не реагирует на присутствие выражения noindex, ни в заголовке, ни в теле веб-страницы. Google остаётся верен своему валидному «nofollow», который он понимает и выполняет – и для отдельной ссылки, и для всей страницы сразу (в зависимости от того, как прописан запрет). После некоторого скрипения своими жерновами, Яндекс сдался и перестал продвижение своего тега и значения noindex, хотя – и не отказывается от него полностью. Если роботы Яндекса находят тег или значение noindex на странице – они исправно выполняют наложенные запреты.

Универсальный метатег (Яндекс & Google)

С учётом требований Яндекса, общий вид универсального метатега,

закрывающего полностью всю страницу от поисковой индексации,

выглядит так:

- <meta name=»robots» content=»noindex, nofollow»/>

- – запрещено индексировать текст и переходить по ссылкам на странице

для всех поисковых роботов Яндекса и Google

Почему метатег robots лучше файла robots.

txt

txtСамый простой и популярный способ закрыть веб-страницу от индексации – это указать для неё соответствующую директиву в файле robots.txt. Для этого, собственно файл robots.txt и существует. Однако, закрывать через метатег robots – гораздо надёжнее.

И, вот почему.

Алгоритмы обработки роботами метатега robots и файла robots – совершенно различные. Работу этих алгоритмов можно сравнить с действием в известном анекдоте, где бьют не «по паспорту», а – «по морде». Пусть этот пример весьма груб и примитивен, но он, как нельзя лучше – отображает поведение поискового робота на странице:

- В случае использования метатега robots, поисковик просто и прямо заходит на веб-страницу и читает её заголовок («смотрит в её морду». Если робот там находит метатег robots – он разворачивается и уходит восвояси. Вуаля! Всё предельно просто. Робот увидел запись, что здесь ловить нечего, и сразу же – «свалил». Ему проблемы не нужны. Это есть работа по факту записи прямо в заголовке страницы («по морде»).

- В случае использования файла robots.txt, поисковик, перед заходом на страницу – сверяется с этим файлом (читает «паспорт»). Это есть работа по факту записи в постороннем файле («по паспорту»). Если в файле robots.txt («паспорте») прописана соответствующая директива – робот её выполняет. Если нет, то он – сканирует страницу в общем порядке, поскольку по-умолчанию – к сканированию разрешены все страницы.

Казалось-бы, какая разница.

Тем более, что сам Яндекс рассказывает следующее:

При сканировании сайта, на основании его файла robots.txt – составляется специальный список (пул), в котором ясно и чётко указываются и излагаются директории и страницы, разрешённые к поисковому индексированию сайта.

Ну, чего ещё проще – составил списочек,

прошёлся списочком по сайту,

и всё – можно «баиньки»…

Простота развеется, как майский дым, если мы вспомним, что роботов много, что все они разные, и самое главное – что все роботы ходят по ссылкам. А сей час, представим себе стандартную ситуацию, которая случается в интернете миллионы раз на дню – поисковый робот пришёл на страницу по ссылке из другого сайта. Вот он, трудяга Сети – уже стоит у ворот (у заголовка) странички. Ну, и где теперь файл robots.txt?

А сей час, представим себе стандартную ситуацию, которая случается в интернете миллионы раз на дню – поисковый робот пришёл на страницу по ссылке из другого сайта. Вот он, трудяга Сети – уже стоит у ворот (у заголовка) странички. Ну, и где теперь файл robots.txt?

У робота, пришедшего на сайт по внешней ссылке, выбор не большой. Робот может, либо лично «протопать» к файлу robots.txt и свериться с ним, либо просто скачать страницу себе в кэш и уже потом разбираться – индексировать её или нет.

Как поступит наш герой, мы не знает. Это коммерческая тайна каждой поисковой системы. Несомненно, одно. Если в заголовке страницы будет указан метатег robots – поисковик выполнит его немедля. И, если этот метатег запрещает индексирование страницы – робот уйдёт немедля и без раздумий.

Вот теперь, совершенно ясно, что прямой заход на страницу, к метатегу robots –

всегда короче и надёжнее, нежели долгий путь через закоулки файла robots.txt

Метатег robots | Закрыть страницу от индексации на tehnopost. info

info

- Метатег robots

- Почему метатег robots лучше файла robots.txt

Внимание! У Вас нет прав для просмотра скрытого текста.

Как закрыть контент от индексации — пошаговое руководство

Иногда возникают такие ситуации, когда нужно Закрыть от индексации часть контента. Пример такой ситуации мы рассматривали здесь.

Также, иногда нужно:

- Скрыть от поиска техническую информацию

- Закрыть от индекса не уникальный контент

- Скрыть сквозной,повторяющийся внутри сайта, контент

- Закрыть мусорные страницы, которые нужны пользователям, но для робота выглядят как дубль

Постараемся в данной статье максимально подробно расписать инструменты при помощи которых можно закрывать контент от индексации.

Закрываем от индексации домен/поддомен:

Для того, чтобы закрыть от индексации домен, можно использовать:

1. Robots.txt

В котором прописываем такие строки.

User-agent: *

Disallow: /

При помощи данной манипуляции мы закрываем сайт от индексации всеми поисковыми системами.

При необходимости Закрыть от индексации конкретной поисковой системой, можно добавить аналогичный код, но с указанием Юзерагента.

User-agent: yandex

Disallow: /

Иногда, же бывает нужно наоборот открыть для индексации только какой-то конкретной ПС. В таком случае нужно составить файл Robots.txt в таком виде:

User-agent: *

Disallow: /

User-agent: Yandex

Allow: /

Таким образом мы позволяем индексировать сайт только однайо ПС. Однако минусом есть то, что при использовании такого метода, все-таки 100% гарантии не индексации нет. Однако, попадание закрытого таким образом сайта в индекс, носит скорее характер исключения.

Для того, чтобы проверить корректность вашего файла Robots.txt можно воспользоваться данным инструментом просто перейдите по этой ссылке http://webmaster.yandex.ru/robots. xml.

xml.

Статья в тему: Robots.txt — инструкция для SEO

2. Добавление Мета-тега Robots

Также можно закрыть домен от индексации при помощи Добавления к Код каждой страницы Тега:

META NAME=»ROBOTS» CONTENT=»NOINDEX, NOFOLLOW»

Куда писать META-тег “Robots”

Как и любой META-тег он должен быть помещен в область HEAD HTML страницы:

Данный метод работает лучше чем Предыдущий, темболее его легче использовать точечно нежели Вариант с Роботсом. Хотя применение его ко всему сайту также не составит особого труда.

3. Закрытие сайта при помощи .htaccess

Для Того, чтобы открыть доступ к сайту только по паролю, нужно добавить в файл .htaccess, добавляем такой код:

После этого доступ к сайту будет возможен только после ввода пароля.

Защита от Индексации при таком методе является стопроцентной, однако есть нюанс, со сложностью просканить сайт на наличие ошибок. Не все парсеры могут проходить через процедуру Логина.

Закрываем от индексации часть текста

Очень часто случается такая ситуация, что необходимо закрыть от индексации Определенные части контента:

- меню

- текст

- часть кода.

- ссылку

Скажу сразу, что распространенный в свое время метод при помощи тега <noindex> не работает.

<noindex>Тут мог находится любой контент, который нужно было закрыть</noindex>

Однако существует альтернативный метод закрытия от индексации, который очень похож по своему принципу, а именно метод закрытия от индексации при помощи Javascript.

Закрытие контента от индексации при помощи Javacascript

При использовании данного метода текст, блок, код, ссылка или любой другой контент кодируется в Javascript, а далее Данный скрипт закрывается от индексации при помощи Robots.txt

Такой Метод можно использовать для того, чтобы скрыть например Меню от индексации, для лучшего контроля над распределением ссылочного веса. К примеру есть вот такое меню, в котором множество ссылок на разные категории. В данном примере это — порядка 700 ссылок, если не закрыть которые можно получить большую кашу при распределении веса.

К примеру есть вот такое меню, в котором множество ссылок на разные категории. В данном примере это — порядка 700 ссылок, если не закрыть которые можно получить большую кашу при распределении веса.

Данный метод гугл не очень то одобряет, так-как он всегда говорил, что нужно отдавать одинаковый контент роботам и пользователям. И даже рассылал письма в средине прошлого года о том, что нужно открыть для индексации CSS и JS файлы.

Подробнее об этом можно почитать тут.

Однако в данный момент это один из самых действенных методов по борьбе с индексацией нежелательного контента.

Точно также можно скрывать обычный текст, исходящие ссылки, картинки, видео материалы, счетчики, коды. И все то, что вы не хотите показывать Роботам, или что является не уникальным.

Как закрыть от индексации конкретную страницу:

Для того, чтобы закрыть от индекса конкретную страницу чаще всего используются такие методы:

- Роботс txt

- Мета robots noindex

В случае первого варианта закрытия страницы в данный файл нужно добавить такой текст:

User-agent: ag

Disallow: http://site. com/page

com/page

Таким образом данная страница не будет индексироваться с большой долей вероятности. Однако использование данного метода для точечной борьбы со страницами, которые мы не хотим отдавать на индексацию не есть оптимальным.

Так, для закрытия одной страницы от индекса лучше воспользоваться тегом

META NAME=»ROBOTS» CONTENT=»NOINDEX, NOFOLLOW»

Для этого просто нужно добавить в область HEAD HTML страницы. Данный метод позволяет не перегружать файл robots.txt лишними строчками.

Ведь если Вам нужно будет закрыть от индекса не 1 страницу, а к примеру 100 или 200 , то нужно будет добавить 200 строк в этот файл. Но это в том случае, если все эти страницы не имеют общего параметра по которому их можно идентифицировать. Если же такой параметр есть, то их можно закрыть следующим образом.

Закрытие от индексации Раздела по параметру в URL

Для этого можно использовать 2 метода:

Рассмотрим 1 вариант

К примеру, у нас на сайте есть раздел, в котором находится неуникальная информация или Та информация, которую мы не хотим отдавать на индексацию и вся эта информация находится в 1 папке или 1 разделе сайта.

Тогда для закрытия данной ветки достаточно добавить в Robots.txt такие строки:

Если закрываем папку, то:

Disallow: /папка/

Если закрываем раздел, то:

Disallow: /Раздел/*

Также можно закрыть определенное расшерение файла:

User-agent: *

Disallow: /*.js

Данный метод достаточно прост в использовании, однако как всегда не гарантирует 100% неиндексации.

Потому лучше в добавок делать еще закрытие при помощи

META NAME=»ROBOTS» CONTENT=»NOINDEX”

Который должен быть добавлен в секцию Хед на каждой странице, которую нужно закрыть от индекса.

Точно также можно закрывать от индекса любые параметры Ваших УРЛ, например:

?sort

?price

?”любой повторяющийся параметр”

Однозначно самым простым вариантом является закрытие от индексации при помощи Роботс.тхт, однако, как показывает практика — это не всегда действенный метод.

Методы, с которыми нужно работать осторожно:

Также существует достаточно грубый метод Закрытия чего — либо от роботов, а именно запрет на уровне сервера на доступ робота к конкретному контенту.

1. Блокируем все запросы от нежелательных User Agents

Это правило позволяет заблокировать нежелательные User Agent, которые могут быть потенциально опасными или просто перегружать сервер ненужными запросами.

В данному случае плохим ботом можно указать Любую поисковую машину, парсер либо что либо еще.

Подобные техники используются например для скрытия от робота Ахрефса ссылки с сайта, который был создан/сломан, чтобы конкуренты сеошники не увидели истинных источников ссылочной массы сайта.

Однако это метод стоит использовать если вы точно знаете, что хотите сделать и здраво оцениваете последствия от этих действий.

Использование HTTP-заголовка X-Robots-Tag

Заголовок X-Robots-Tag, выступает в роли элемента HTTP-заголовка для определенного URL. Любая директива, которая может использоваться в метатеге robots, применима также и к X-Robots-Tag.

В X-Robots-Tag перед директивами можно указать название агента пользователя. Пример HTTP-заголовка X-Robots-Tag, который запрещает показ страницы в результатах поиска различных систем:

В заключение

Ситуации, когда необходимо закрыть контент от индексации случаются довольно часто, иногда нужно почистить индекс, иногда нужно скрыть какой-то нежелательный материал, иногда нужно взломать чужой сайт и в роботсе указать disalow all, чтобы выбросить сайт зеркало из индекса.

Основные и самые действенные методы мы рассмотрели, как же их применять — дело вашей фантазии и целей, которые вы преследуете.

Хорошие статьи в продолжение:

— Стоит ли открывать рубрики для индексации, если в разных рубриках выводятся одни и те же посты?

— Как открывать страницы поиска в интернет магазине — руководство

А что вы думаете по этому поводу? Давайте обсудим в комментариях!)

Оцените статью

Загрузка…Как правильно настроить robots.txt — Академия SEO (СЕО)

Содержание:

Правильный robots.txt и его важность

Хотите узнать как закрыть сайт от индексации поисковиками, когда Вы в этом не нуждаетесь?

Оказывается, это не так уж сложно. Потребуется лишь правильный robots.txt, размещенный в корневой папке Вашего веб-ресурса.

Ну а теперь по порядку.

robots.txt – текстовый файл, в котором предписываются рекомендации для действий роботов поисковиков. Именно его они первым делом ищут, едва «переступив порог» Вашего веб-ресурса. Если его нет или он присутствует, но не содержит в себе никакой информации, поисковые боты воспринимают это как разрешение «прогуляться» по всему сайту без каких-либо ограничений.

И наоборот, если в нем прописаны определенные инструкции по запрещению индексации, поисковые роботы будут стараться их придерживаться.

Принцип действия и настройка robots.txt

Правильный robots.txt содержит в своем теле записи, каждая из которых начинается со строки, в которой указывается клиентское приложение User-agent. В нем прописывается название робота, к которому относятся инструкции в следующей строке/строках.

В нем прописывается название робота, к которому относятся инструкции в следующей строке/строках.

Если же инструкция относится ко всем паукам-индексаторам, вместо имени используется символ «звездочка»:

Далее прописывается строка с директивой Disallow и несколько спец. символов, которые выбираются в зависимости от цели инструкции.

Закрыть сайт от индексации? Нет ничего проще!

Собственно говоря, основная функция robots – запретить индексацию. Чего именно? Тут уж Вам выбирать. Вариантов существует предостаточно:

- Полностью запретить индексацию сайта. Подразумевается возможность отказать пришедшему «в гости» роботу заходить на Ваш веб-ресурс и выполнять свою работу. Может быть полезно на ранних стадиях разработки сайта, когда публикация контента уже началась, но еще не доведена до нужного уровня. В этом случае индексация неоптимизированных страниц нежелательна, дабы «не подпортить» заранее репутацию сайта.

- Закрыть от индексации раздел/категорию. Используется в случае вполне действующего веб-ресурса, имеющем определенный рейтинг в глазах поисковиков, когда готовится новый раздел или категория, индексация которых пока что нежелательна.

- Запретить индексацию страницы. Удобно использовать в случае, если на сайте размещены документы, которые нужны, но не должны индексироваться и влиять на общий рейтинг веб-ресурса. Например, это может быть «Политика конфиденциальности», состоящая из неуникального текста.

Настройка robots.txt. 10 важных фишек

- Если в robots запретить индексацию, то она будет действовать по принципу старшинства. То есть запрет распространяется на все файлы, страницы и директории, которые подчинены указанному элементу.

- Правильный robots.txt всегда содержит минимум одну строку User-agent, чтобы его принимали к сведению.

- Возможна настройка robots.txt, при которой для одного бота может быть прописана запись, состоящая сразу из нескольких инструкций.

- Символ «*» перед названием поможет запретить индексацию всех объектов с указанным словом.

- Символ «/» используется как в начале, так и в конце названия директории. В противном случае robots может запретить индексацию всех страниц, в имени которых встречается «slovo».

- Пустая директива Disallow дает роботу разрешение индексировать все странички веб-ресурса.

- Желательно, чтобы правильный robots.txt указывал, где находится карта сайта. Это значительно ускорит индексацию страниц и исключит вероятность случайного пропуска роботом некоторых из них.

- Правильный robots.txt может содержать инструкции, прописанные только при использовании нижнего регистра.

- Любая Disallow может указывать только на один файл/раздел/страницу и должна прописываться с новой строки.

- Нельзя прописывать сначала Disallow, а потом User-agent. Подобная настройка robots.txt будет пустой тратой времени, поскольку боты не смогут понять таких инструкций.

И самое главное правило – перед тем, как залить правильный robots.txt в корень веб-сайта, нужно убедить в его правильности. Рекомендуется проверять его на ошибки несколько раз. А еще лучше – дать проверить кому-нибудь другому. Свежему взгляду проще будет увидеть опечатки и прочие неприятности в теле файла.

Только верная настройка robots.txt поможет запретить индексацию именно тех элементов Вашего сайта, которые Вы пока что решили скрыть от «зоркого взгляда» поисковиков.

Остались вопросы? Задавайте! Ждем Вас в комментариях!

Как закрыть сайт от индексации: краткое руководство

Как закрыть сайт от индексации в поиске

Как закрыть сайт от индексацииДля закрытия от индексации всего ресурса достаточно просто создать в корневой папке файл robots. txt с таким текстом:

txt с таким текстом:

Usеr-аgеnt: Yаndех

Dіsаllоw: /

Это позволит закрыть сайт от робота Яндекса. А сделать так, чтобы он не индексировался ни одним поисковиком, можно при помощи такой команды:

Usеr-аgеnt: *

Dіsаllоw: /

Ввод такого текста в «роботс» позволяет скрыть ресурс не только от Яндекса, но и от всех остальных поисковых систем. Можно также использовать файл .htассеss, но при этом устанавливается пароль, что приводит к некоторым сложностям в работе с сайтом.

Как

запретить индексацию папки?Можно отключить робота как полностью, так и частично. Чтобы поисковая система не видела определенную папку, указываем в robots.txt ее название. В результате будет установлен запрет на индексирование всех находящихся в ней объектов.

Шаблон:

Usеr-аgеnt: *

Dіsаllоw: /fоldеr/ (название папки)

Есть также возможность открыть отдельный файл. При такой необходимости дополнительно используется команда Allow. Прописываем разрешение на индексацию нужного объекта и запрет на доступ к папке:

Прописываем разрешение на индексацию нужного объекта и запрет на доступ к папке:

Usеr-аgеnt: *

Аllоw: /fоldеr/fіlе.рhр (местонахождение объекта – его название и папка)

Dіsаllоw: /fоldеr/

Как запретить Яндексу доступ к определенному файлу?

Тут нужно действовать по аналогии с предыдущим примером. Команда та же, но указывается адрес местонахождения файла и название поисковика.

Шаблон команд, блокирующих индексацию:

User-agent: Yandex

Disallow: /folder/file.php

Как определить, документ открыт для индексации или нет?

С этой целью можно использовать специализированные сервисы, в том числе бесплатные. Работают они довольно просто, например по такой схеме: вы вводите перечень адресов, которые нужно проверить, и запрашиваете информацию об их возрасте в поисковике. Для документа, который индексируется, будет указана дата его попадания в индекс, а если он недоступен для поисковых роботов, отобразится соответствующая надпись.

Как блокируется индексирование изображений?

Можно запретить поисковикам индексировать картинки таких распространенных форматов как gif, png и jpg. Для этого в robots.txt указывается расширение файлов.

В зависимости от того, какие изображения блокируются, команды имеют такой вид:

User-Agent: *

Disallow: *.gif (*.png или *.jpg)

Алгоритм действий в этом случае такой же, как при запрете индексации основного сайта. У каждого поддомена есть собственный robots.txt, чаще всего расположенный в его корневой папке. Если не удалось его обнаружить, нужно создать такой файл. Содержащиеся в нем данные корректируются с использованием команды Disallow путем упоминания разделов, которые закрываются.

Как запретить индексацию поддомена с CDN?

При использовании этой версии наличие дубля может превратиться в серьезную помеху для SEO-продвижения. Есть два способа этого избежать. Первый – провести предварительную настройку на домене тега <link> атрибута rel=»canonical», а второй – создать собственный robots. txt на поддомене. Лучше остановиться на первом варианте, поскольку так данные о поведенческих факторах удастся сохранить в полном объеме по каждому из адресов.

txt на поддомене. Лучше остановиться на первом варианте, поскольку так данные о поведенческих факторах удастся сохранить в полном объеме по каждому из адресов.

Как называть роботов разных поисковых систем?

В robots.txt содержатся обращения к индексаторам, и необходимо правильно указать их названия. У каждого поисковика собственный набор роботов.

- У Google главный индексатор – это Googlebot.

- У Яндекса – Yandex.

- У отечественной поисковой системы «Спутник» от компании «Ростелеком» – SputnikBot.

- У поисковика Bing от корпорации «Майкрософт» – робот-индекстор от MSN под названием MSNBot.

- Yahoo! – Slurp.

Как дополнительные команды можно прописать в robots.txt?

Яндексом, кроме рассмотренных выше директив, поддерживаются и такие.

- Sitemap: – показывает путь к карте сайта. Кроме Яндекса, на него реагирует Google и многие другие поисковые системы.

- Clean-param: – демонстрирует параметры GET, не влияющие на то, как на сайте отображается контент, например ref-ссылки или метки UTM.

- Crawl-delay: – устанавливает минимальный временной интервал для поочередного скачивания файлов. Работает в большинстве поисковиков.

Чтобы роботы не индексировали сайт или определенную страницу, можно воспользоваться командой name=»robots» #. Установка запрета на поиск при помощи этого метатега является удачным способом закрытия ресурса, поисковые роботы с большой вероятностью будут выполнять вашу команду. Допускается использование одного из двух равносильных вариантов кода:

1) <meta name=»robots» соntent=»none»/>,

2) <meta name=»robots» content=»nоіndex, nofollow»/>.

Метатег прописывается в зоне <head> </head>. Так блокируется доступ для всех роботов, но при желании можно обратиться к какому-то конкретному, заменив в коде «robots» на его название. Например, для Яндекса команда выглядит так:

<meta name=»yandex» content=»nоіndex, nofollow»/>

Теги

Вам также будет интересно

Файл robots.

txt и мета-тег robots — настройка индексации сайта Яндексом и Гуглом, правильный роботс и его проверка Обновлено 24 января 2021 Просмотров: 28 420 Автор: Дмитрий Петров

txt и мета-тег robots — настройка индексации сайта Яндексом и Гуглом, правильный роботс и его проверка Обновлено 24 января 2021 Просмотров: 28 420 Автор: Дмитрий Петров- Почему так важно управлять индексацией сайта

- Как можно запретить индексацию отдельных частей сайта

- Robots.txt — директива user-agent и боты поисковых систем

- Примеры использования директив Disallow и Allow

- Директивы Sitemap и Host (для Яндекса уже не нужна)

- Проверка robots.txt в Яндексе и Гугле, примеры ошибок

- Мета-тег Robots — помогает закрыть дубли при индексации сайта

- Как создать правильный роботс.тхт?

При самостоятельном продвижении и раскрутке сайта важно не только создание уникального контента или подбор запросов в статистике Яндекса, но и так же следует уделять должное внимание такому показателю, как индексация ресурса поисковиками, ибо от этого тоже зависит весь дальнейший успех продвижения.

У нас с вами имеются в распоряжении два набора инструментов, с помощью которых мы можем управлять этим процессом как бы с двух сторон. Во-первых, существует такой важный инструмент как карта сайта (Sitemap xml). Она говорит поисковикам о том, какие страницы сайта подлежат индексации и как давно они обновлялись.

Во-первых, существует такой важный инструмент как карта сайта (Sitemap xml). Она говорит поисковикам о том, какие страницы сайта подлежат индексации и как давно они обновлялись.

А, во-вторых, это, конечно же, файл robots.txt и похожий на него по названию мета-тег роботс, которые помогают нам запретить индексирование на сайте того, что не содержит основного контента (исключить файлы движка, запретить индексацию дублей контента), и именно о них и пойдет речь в этой статье…

Индексация сайта

Упомянутые выше инструменты очень важны для успешного развития вашего проекта, и это вовсе не голословное утверждение. В статье про Sitemap xml (см. ссылку выше) я приводил в пример результаты очень важного исследования по наиболее частым техническим ошибкам начинающих вебмастеров, там на втором и третьем месте (после не уникального контента) находятся как раз отсутствие этих файлов роботс и сайтмап, либо их неправильное составление и использование.

Почему так важно управлять индексацией сайта

Надо очень четко понимать, что при использовании CMS (движка) не все содержимое сайта должно быть доступно роботам поисковых систем. Почему?

Почему?

- Ну, хотя бы потому, что, потратив время на индексацию файлов движка вашего сайта (а их может быть тысячи), робот поисковика до основного контента сможет добраться только спустя много времени. Дело в том, что он не будет сидеть на вашем ресурсе до тех пор, пока его полностью не занесет в индекс. Есть лимиты на число страниц и исчерпав их он уйдет на другой сайт. Адьес.

- Если не прописать определенные правила поведения в роботсе для этих ботов, то в индекс поисковиков попадет множество страниц, не имеющих отношения к значимому содержимому ресурса, а также может произойти многократное дублирование контента (по разным ссылкам будет доступен один и тот же, либо сильно пересекающийся контент), что поисковики не любят.

Хорошим решением будет запрет всего лишнего в robots.txt (все буквы в названии должны быть в нижнем регистре — без заглавных букв). С его помощью мы сможем влиять на процесс индексации сайта Яндексом и Google. Представляет он из себя обычный текстовый файл, который вы сможете создать и в дальнейшем редактировать в любом текстовом редакторе (например, Notepad++).

Поисковый бот будет искать этот файл в корневом каталоге вашего ресурса и если не найдет, то будет загонять в индекс все, до чего сможет дотянуться. Поэтому после написания требуемого роботса, его нужно сохранить в корневую папку, например, с помощью Ftp клиента Filezilla так, чтобы он был доступен к примеру по такому адресу:

https://ktonanovenkogo.ru/robots.txt

Кстати, если вы хотите узнать как выглядит этот файл у того или иного проекта в сети, то достаточно будет дописать к Урлу его главной страницы окончание вида /robots.txt. Это может быть полезно для понимания того, что в нем должно быть.

Однако, при этом надо учитывать, что для разных движков этот файл будет выглядеть по-разному (папки движка, которые нужно запрещать индексировать, будут называться по-разному в разных CMS). Поэтому, если вы хотите определиться с лучшим вариантом роботса, допустим для Вордпресса, то и изучать нужно только блоги, построенные на этом движке (и желательно имеющие приличный поисковый трафик).

Как можно запретить индексацию отдельных частей сайта и контента?

Прежде чем углубляться в детали написания правильного файла robots.txt для вашего сайта, забегу чуть вперед и скажу, что это лишь один из способов запрета индексации тех или иных страниц или разделов вебсайта. Вообще их три:

- Роботс.тхт — самый высокоуровневый способ, ибо позволяет задать правила индексации для всего сайта целиком (как его отдельный страниц, так и целых каталогов). Он является полностью валидным методом, поддерживаемым всеми поисковиками и другими ботами живущими в сети. Но его директивы вовсе не являются обязательными для исполнения. Например, Гугл не шибко смотрит на запреты в robots.tx — для него авторитетнее одноименный мета-тег рассмотренный ниже.

- Мета-тег robots — имеет влияние только на страницу, где он прописан. В нем можно запретить индексацию и переход робота по находящимся в этом документе ссылкам (подробнее смотрите ниже).

Он тоже является полностью валидным и поисковики будут стараться учитывать указанные в нем значения. Для Гугла, как я уже упоминал, этот метод имеет больший вес, чем файлик роботса в корне сайта.

Он тоже является полностью валидным и поисковики будут стараться учитывать указанные в нем значения. Для Гугла, как я уже упоминал, этот метод имеет больший вес, чем файлик роботса в корне сайта. - Тег Noindex и атрибут rel=»nofollow» — самый низкоуровневый способ влияния на индексацию. Они позволяют закрыть от индексации отдельные фрагменты текста (noindex) и не учитывать вес передаваемый по ссылке. Они не валидны (их нет в стандартах). Как именно их учитывают поисковики и учитывают ли вообще — большой вопрос и предмет долгих споров (кто знает наверняка — тот молчит и пользуется).

Важно понимать, что даже «стандарт» (валидные директивы robots.txt и одноименного мета-тега) являются необязательным к исполнению. Если робот «вежливый», то он будет следовать заданным вами правилам. Но вряд ли вы сможете при помощи такого метода запретить доступ к части сайта роботам, ворующим у вас контент или сканирующим сайт по другим причинам.

Вообще, роботов (ботов, пауков, краулеров) существует множество. Какие-то из них индексируют контент (как например, боты поисковых систем или воришек). Есть боты проверяющие ссылки, обновления, зеркалирование, проверяющие микроразметку и т.д.

Какие-то из них индексируют контент (как например, боты поисковых систем или воришек). Есть боты проверяющие ссылки, обновления, зеркалирование, проверяющие микроразметку и т.д.

Большинство роботов хорошо спроектированы и не создают каких-либо проблем для владельцев сайтов. Но если бот написан дилетантом или «что-то пошло не так», то он может создавать существенную нагрузку на сайт, который он обходит. Кстати, пауки вовсе на заходят на сервер подобно вирусам — они просто запрашивают нужные им страницы удаленно (по сути это аналоги браузеров, но без функции просмотра страниц).

Robots.txt — директива user-agent и боты поисковых систем

Роботс.тхт имеет совсем не сложный синтаксис, который очень подробно описан, например, в хелпе яндекса и хелпе Гугла. Обычно в нем указывается, для какого поискового бота предназначены описанные ниже директивы: имя бота (‘User-agent‘), разрешающие (‘Allow‘) и запрещающие (‘Disallow‘), а также еще активно используется ‘Sitemap’ для указания поисковикам, где именно находится файл карты.

Стандарт создавался довольно давно и что-то было добавлено уже позже. Есть директивы и правила оформления, которые будут понятны только роботами определенных поисковых систем. В рунете интерес представляют в основном только Яндекс и Гугл, а значит именно с их хелпами по составлению robots.txt следует ознакомиться особо детально (ссылки я привел в предыдущем абзаце).

Например, раньше для поисковой системы Яндекс было полезным указать, какое из зеркал вашего вебпроекта является главным в специальной директиве ‘Host’, которую понимает только этот поисковик (ну, еще и Майл.ру, ибо у них поиск от Яндекса). Правда, в начале 2018 Яндекс все же отменил Host и теперь ее функции как и у других поисковиков выполняет 301-редирект.

Если даже у вашего ресурса нет зеркал, то полезно будет указать, какой из вариантов написания является главным — с www или без него.

Теперь поговорим немного о синтаксисе этого файла. Директивы в robots.txt имеют следующий вид:

<поле>:<пробел><значение><пробел> <поле>:<пробел><значение><пробел>

Правильный код должен содержать хотя бы одну директиву «Disallow» после каждой записи «User-agent». Пустой файл предполагает разрешение на индексирование всего сайта.

Пустой файл предполагает разрешение на индексирование всего сайта.

User-agent

Директива «User-agent» должна содержать название поискового бота. При помощи нее можно настроить правила поведения для каждого конкретного поисковика (например, создать запрет индексации отдельной папки только для Яндекса). Пример написания «User-agent», адресованной всем ботам зашедшим на ваш ресурс, выглядит так:

User-agent: *

Если вы хотите в «User-agent» задать определенные условия только для какого-то одного бота, например, Яндекса, то нужно написать так:

User-agent: Yandex

Название роботов поисковых систем и их роль в файле robots.txt

Бот каждой поисковой системы имеет своё название (например, для рамблера это StackRambler). Здесь я приведу список самых известных из них:

Google http://www.google.com Googlebot Яндекс http://www.ya.ru Yandex Бинг http://www.bing.com/ bingbot

У крупных поисковых систем иногда, кроме основных ботов, имеются также отдельные экземпляры для индексации блогов, новостей, изображений и т. д. Много информации по разновидностям ботов вы можете почерпнуть тут (для Google).

д. Много информации по разновидностям ботов вы можете почерпнуть тут (для Google).

Как быть в этом случае? Если нужно написать правило запрета индексации, которое должны выполнить все типы роботов Гугла, то используйте название Googlebot и все остальные пауки этого поисковика тоже послушаются. Однако, можно запрет давать только, например, на индексацию картинок, указав в качестве User-agent бота Googlebot-Image. Сейчас это не очень понятно, но на примерах, я думаю, будет проще.

Примеры использования директив Disallow и Allow в роботс.тхт

Приведу несколько простых примеров использования директив с объяснением его действий.

- Приведенный ниже код разрешает всем ботам (на это указывает звездочка в User-agent) проводить индексацию всего содержимого без каких-либо исключений. Это задается пустой директивой Disallow.

User-agent: * Disallow:

- Следующий код, напротив, полностью запрещает всем поисковикам добавлять в индекс страницы этого ресурса.

Устанавливает это

Устанавливает это Disallowс «/» в поле значения.User-agent: * Disallow: /

- В этом случае будет запрещаться всем ботам просматривать содержимое каталога /image/ (http://mysite.ru/image/ — абсолютный путь к этому каталогу)

User-agent: * Disallow: /image/

- Чтобы заблокировать один файл, достаточно будет прописать его абсолютный путь до него (читайте про абсолютные и относительные пути по ссылке):

User-agent: * Disallow: /katalog1//katalog2/private_file.html

Забегая чуть вперед скажу, что проще использовать символ звездочки (*), чтобы не писать полный путь:

Disallow: /*private_file.html

- В приведенном ниже примере будут запрещены директория «image», а также все файлы и директории, начинающиеся с символов «image», т. е. файлы: «image.htm», «images.htm», каталоги: «image», «images1», «image34» и т. д.):

User-agent: * Disallow: /image

Дело в том, что по умолчанию в конце записи подразумевается звездочка, которая заменяет любые символы, в том числе и их отсутствие. Читайте об этом ниже.

Читайте об этом ниже. - С помощью директивы Allow мы разрешаем доступ. Хорошо дополняет Disallow. Например, таким вот условием поисковому роботу Яндекса мы запрещаем выкачивать (индексировать) все, кроме вебстраниц, адрес которых начинается с /cgi-bin:

User-agent: Yandex Allow: /cgi-bin Disallow: /

Ну, или такой вот очевидный пример использования связки Allow и Disallow:

User-agent: * Disallow: /catalog Allow: /catalog/auto

- При описании путей для директив

Allow-Disallowможно использовать символы ‘*’ и ‘$’, задавая, таким образом, определенные логические выражения.- Символ ‘*'(звездочка) означает любую (в том числе пустую) последовательность символов. Следующий пример запрещает всем поисковикам индексацию файлов с расширение «.php»:

User-agent: * Disallow: *.php$

- Зачем нужен на конце знак $ (доллара)? Дело в том, что по логике составления файла robots.

txt, в конце каждой директивы как бы дописывается умолчательная звездочка (ее нет, но она как бы есть). Например мы пишем:

txt, в конце каждой директивы как бы дописывается умолчательная звездочка (ее нет, но она как бы есть). Например мы пишем:Disallow: /images

Подразумевая, что это то же самое, что:

Disallow: /images*

Т.е. это правило запрещает индексацию всех файлов (вебстраниц, картинок и других типов файлов) адрес которых начинается с /images, а дальше следует все что угодно (см. пример выше). Так вот, символ $ просто отменяет эту умолчательную (непроставляемую) звездочку на конце. Например:

Disallow: /images$

Запрещает только индексацию файла /images, но не /images.html или /images/primer.html. Ну, а в первом примере мы запретили индексацию только файлов оканчивающихся на .php (имеющих такое расширение), чтобы ничего лишнего не зацепить:

Disallow: *.php$

- Символ ‘*'(звездочка) означает любую (в том числе пустую) последовательность символов. Следующий пример запрещает всем поисковикам индексацию файлов с расширение «.php»:

- Во многих движках пользователи настраивают так называемые ЧПУ (человеко-понятные Урлы), в то время как Урлы, генерируемые системой, имеют знак вопроса ‘?’ в адресе.

Этим можно воспользоваться и написать такое правило в robots.txt:

Этим можно воспользоваться и написать такое правило в robots.txt:User-agent: * Disallow: /*?

Звездочка после вопросительного знака напрашивается, но она, как мы с вами выяснили чуть выше, уже подразумевается на конце. Таким образом мы запретим индексацию страниц поиска и прочих служебных страниц создаваемых движком, до которых может дотянуться поисковый робот. Лишним не будет, ибо знак вопроса чаще всего CMS используют как идентификатор сеанса, что может приводить к попаданию в индекс дублей страниц.

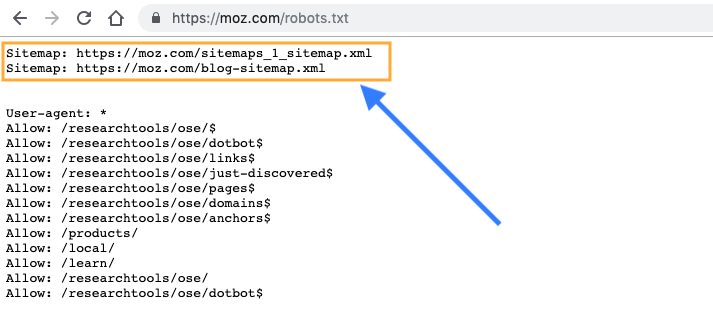

Директивы Sitemap и Host (для Яндекса) в Robots.txt

Во избежании возникновения неприятных проблем с зеркалами сайта, раньше рекомендовалось добавлять в robots.txt директиву Host, которая указывал боту Yandex на главное зеркало.

Однако, в начале 2018 год это было отменено и и теперь функции Host выполняет 301-редирект.

Директива Host — указывает главное зеркало сайта для Яндекса

Например, раньше, если вы еще не перешли на защищенный протокол, указывать в Host нужно было не полный Урл, а доменное имя (без http://, т. е. ktonanovenkogo.ru, а не https://ktonanovenkogo.ru). Если же уже перешли на https, то указывать нужно будет полный Урл (типа https://myhost.ru).

е. ktonanovenkogo.ru, а не https://ktonanovenkogo.ru). Если же уже перешли на https, то указывать нужно будет полный Урл (типа https://myhost.ru).

Сейчас переезд сайта после отказа от директивы Host очень сильно упростился, ибо теперь не нужно ждать пока произойдет склейка зеркал по директиве Host для Яндекса, а можно сразу после настройки Https на сайте делать постраничный редирект с Http на Https.

Напомню в качестве исторического экскурса, что по стандарту написания роботс.тхт за любой директивой User-agent должна сразу следовать хотя бы одна директива Disallow (пусть даже и пустая, ничего не запрещающая). Так же, наверное, имеется смысл прописывать Host для отдельного блока «User-agent: Yandex», а не для общего «User-agent: *», чтобы не сбивать с толку роботов других поисковиков, которые эту директиву не поддерживают:

User-agent: Yandex Disallow: Host: www.site.ru

либо

User-agent: Yandex Disallow: Host: site.ru

либо

User-agent: Yandex Disallow: Host: https://site.ru

либо

User-agent: Yandex Disallow: Host: https://www.site.ru

в зависимости от того, что для вас оптимальнее (с www или без), а так же в зависимости от протокола.

Указываем или скрываем путь до карты сайта sitemap.xml в файле robots

Директива Sitemap указывает на местоположение файла карты сайта (обычно он называется Sitemap.xml, но не всегда). В качестве параметра указывается путь к этому файлу, включая http:// (т.е. его Урл).Благодаря этому поисковый робот сможете без труда его найти. Например:

Sitemap: http://site.ru/sitemap.xml

Раньше файл карты сайта хранили в корне сайта, но сейчас многие его прячут внутри других директорий, чтобы ворам контента не давать удобный инструмент в руки. В этом случае путь до карты сайта лучше в роботс.тхт не указывать. Дело в том, что это можно с тем же успехом сделать через панели поисковых систем (Я.Вебмастер, Google. Вебмастер, панель Майл.ру), тем самым «не паля» его местонахождение.

Вебмастер, панель Майл.ру), тем самым «не паля» его местонахождение.

Местоположение директивы Sitemap в файле robots.txt не регламентируется, ибо она не обязана относиться к какому-то юзер-агенту. Обычно ее прописывают в самом конце, либо вообще не прописывают по приведенным выше причинам.

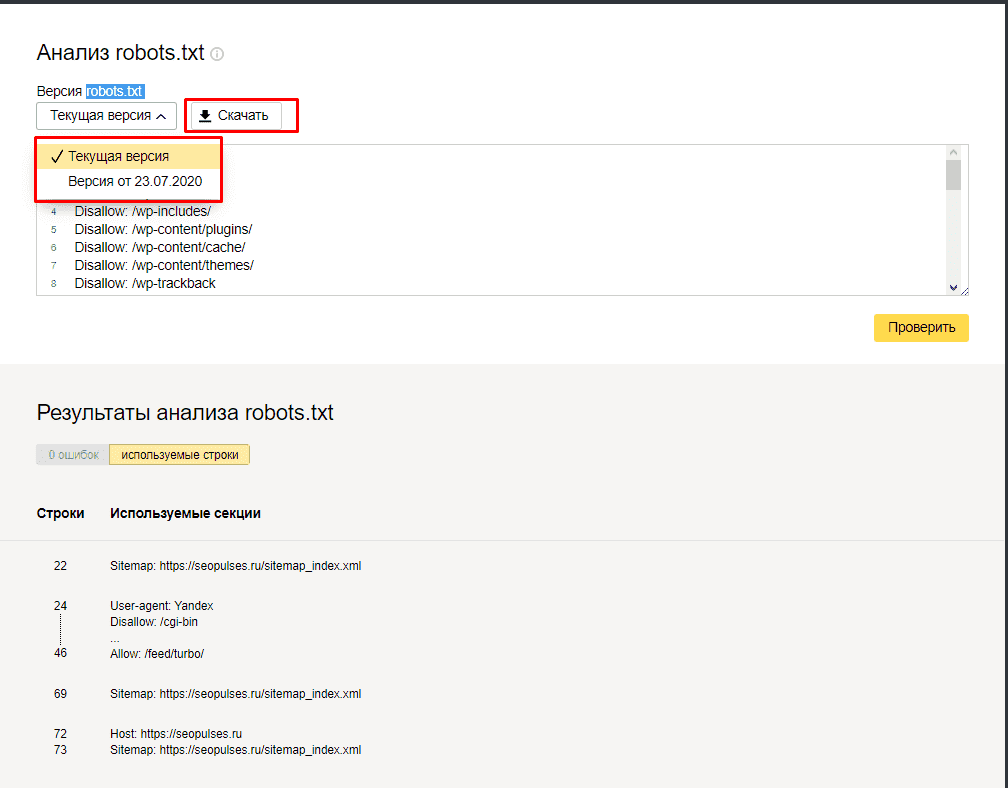

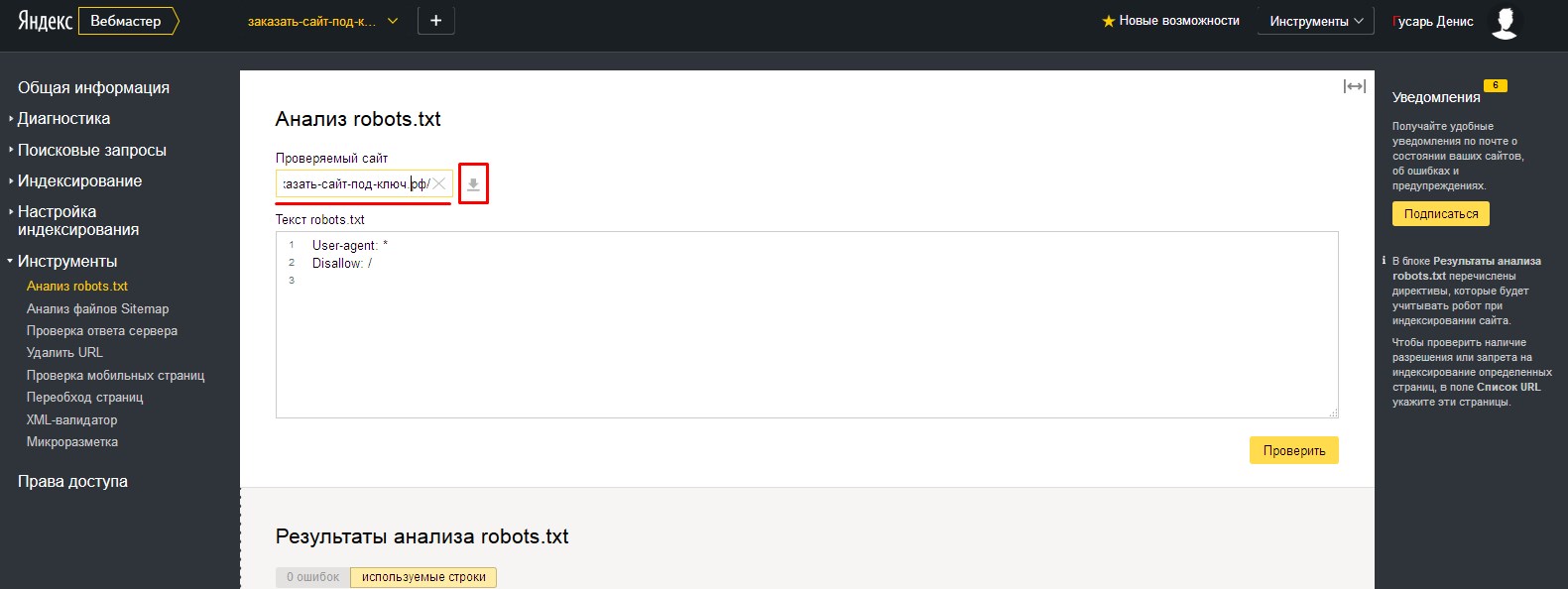

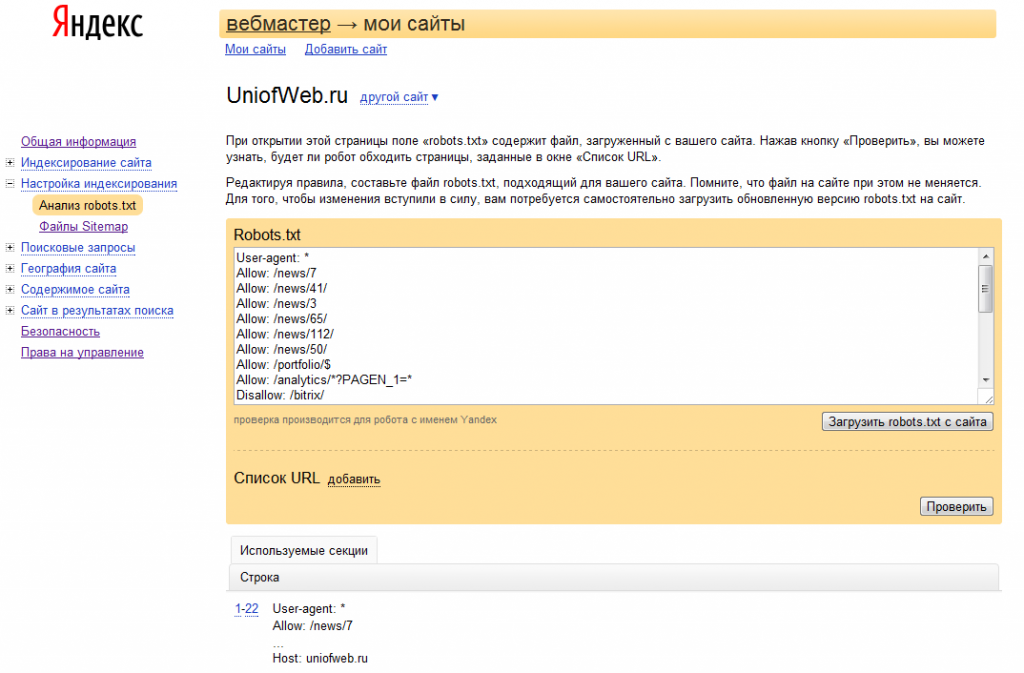

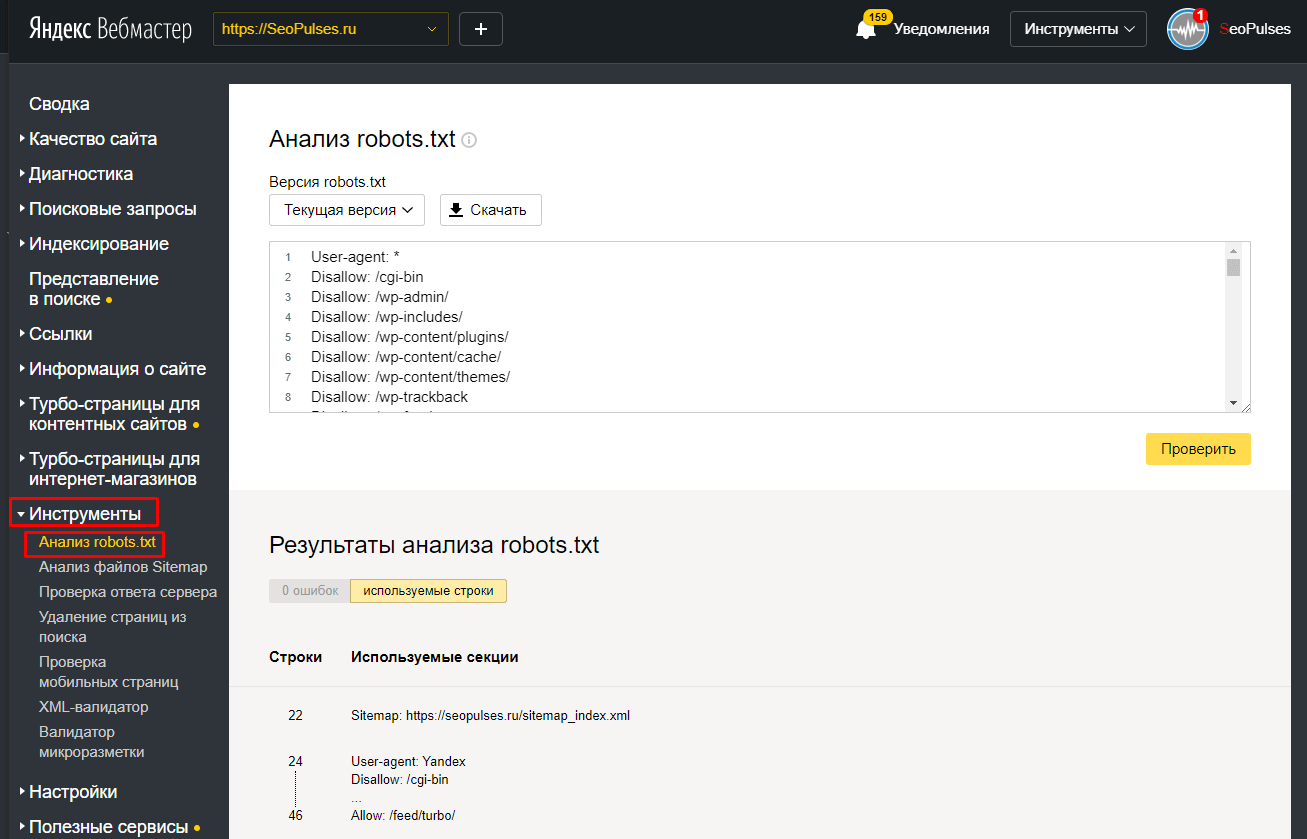

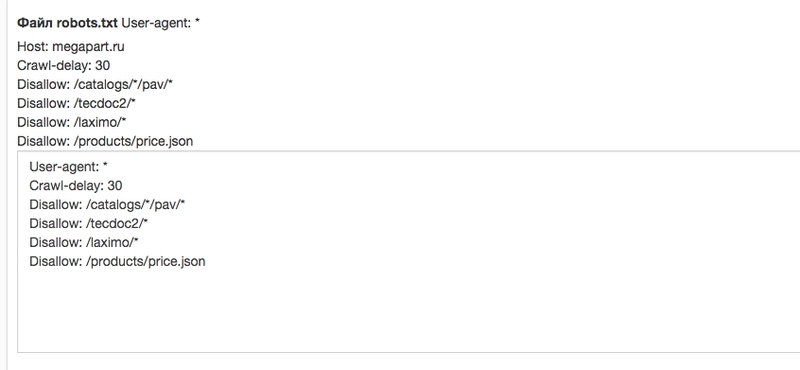

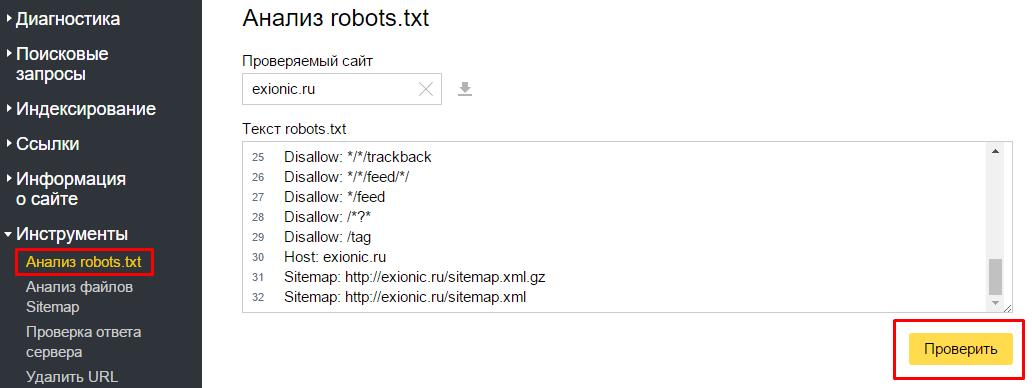

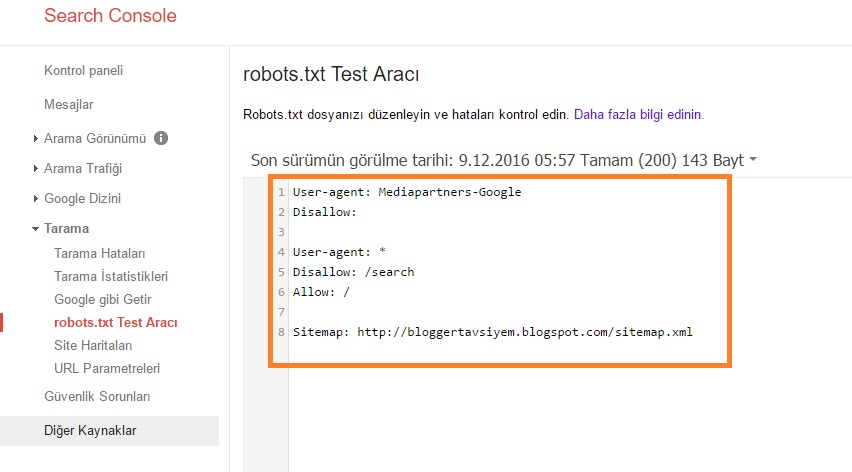

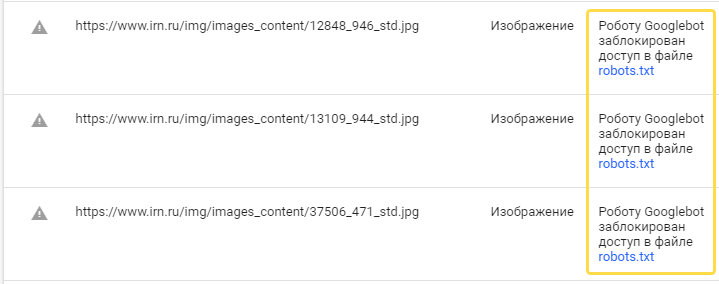

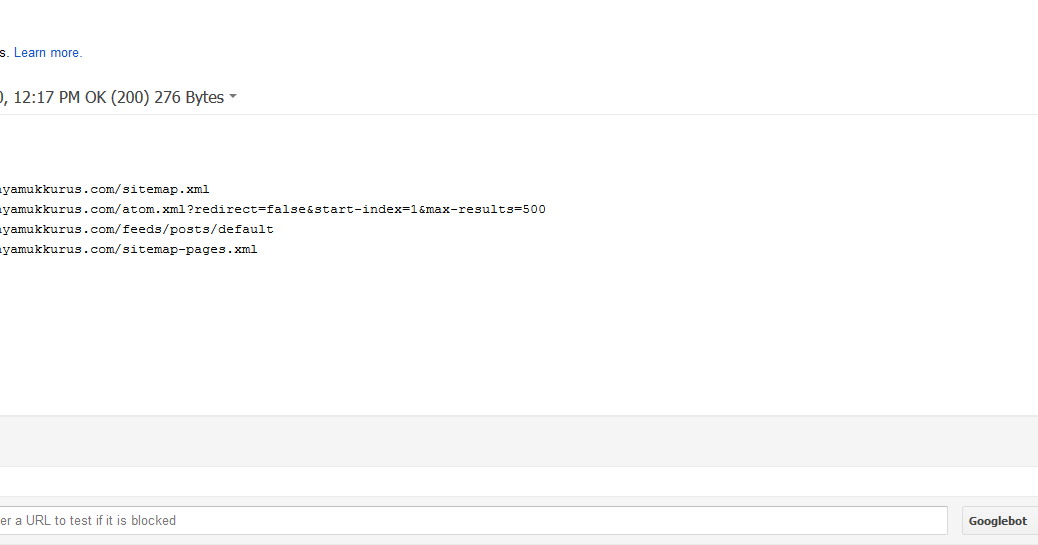

Проверка robots.txt в Яндекс и Гугл вебмастере

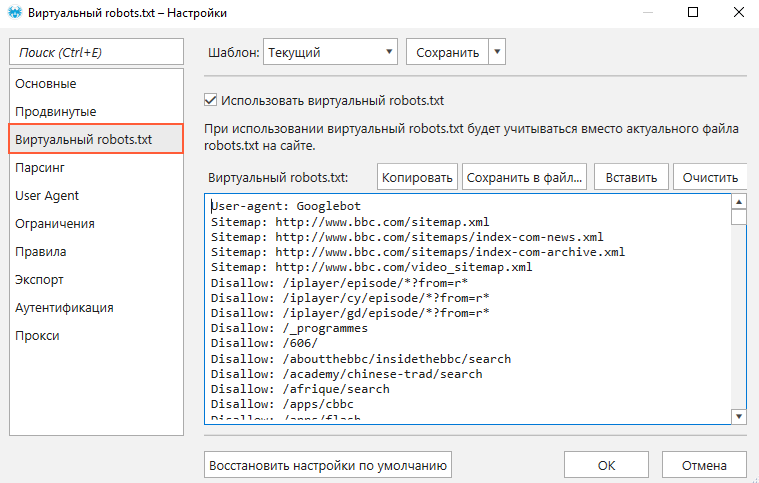

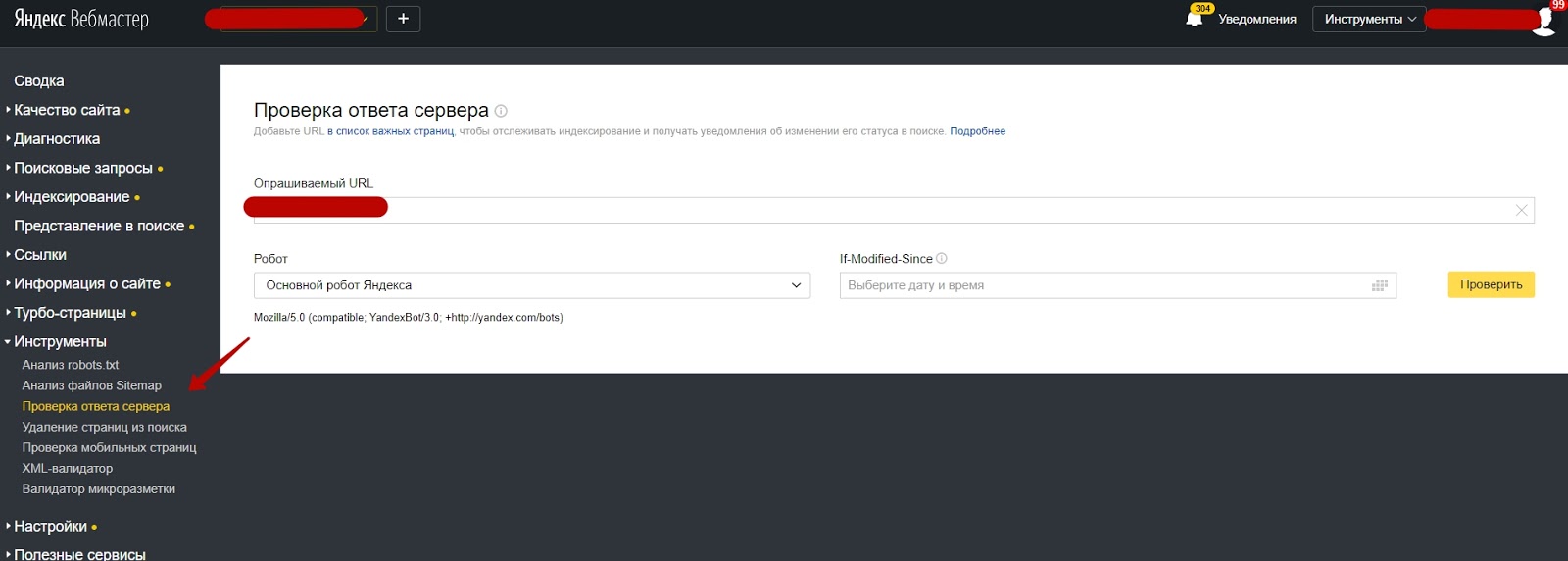

Как я уже упоминал, разные поисковые системы некоторые директивы могут интерпритировать по разному. Поэтому имеет смысл проверять написанный вами файл роботс.тхт в панелях для вебмастеров обоих систем. Как проверять?

- Зайти в инструменты проверки Яндекса и Гугла.

Убедиться, что в панель вебмастера загружена версия файла с внесенными вами изменениями. В Яндекс вебмастере загрузить измененный файл можно с помощью показанной на скриншоте иконки:

В Гугл Вебмастере нужно нажать кнопку «Отправить» (справа под списком директив роботса), а затем в открывшемся окне выбрать последний вариант нажатием опять же на кнопку «Отправить»:

- Набрать список адресов страниц своего сайта (по Урлу в строке), которые должны индексироваться, и вставить их скопом (в Яндексе) или по одному (в Гугле) в расположенную снизу форму.

После чего нажать на кнопку «Проверить».

После чего нажать на кнопку «Проверить».Если возникли нестыковки, то выяснить причины, внести изменения в robots.txt, загрузить обновленный файл в панель вебмастеров и повторить проверку. Все ОК?

Тогда составляйте список страниц, которые не должны индексироваться, и проводите их проверку. При необходимости вносите изменения и проверку повторяйте. Естественно, что проверять следует не все страницы сайта, а ярких представителей своего класса (страницы статей, рубрики, служебные страницы, файлы картинок, файлы шаблона, файлы движка и т.д.)

Причины ошибок выявляемых при проверке файла роботс.тхт

- Файл должен находиться в корне сайта, а не в какой-то папке (это не .htaccess, и его действия распространяются на весь сайт, а не на каталог, в котором его поместили), ибо поисковый робот его там искать не будет.

- Название и расширение файла robots.txt должно быть набрано в нижнем регистре (маленькими) латинскими буквами.

- В названии файла должна быть буква S на конце (не robot.

txt, как многие пишут)

txt, как многие пишут) - Часто в User-agent вместо звездочки (означает, что этот блок robots.txt адресован всем ботам) оставляют пустое поле. Это не правильно и * в этом случае обязательна

User-agent: * Disallow: /

- В одной директиве Disallow или Allow можно прописывать только одно условие на запрет индексации директории или файла. Так нельзя:

Disallow: /feed/ /tag/ /trackback/

Для каждого условия нужно добавить свое Disallow:

Disallow: /feed/ Disallow: /tag/ Disallow: /trackback/

- Довольно часто путают значения для директив и пишут:

User-agent: / Disallow: Yandex

вместо

User-agent: Yandex Disallow: /

- Порядок следования Disallow (Allow) не важен — главное, чтобы была четкая логическая цепь

- Пустая директива Disallow означает то же, что «Allow: /»

- Нет смысла прописывать директиву sitemap под каждым User-agent, если будете указывать путь до карты сайта (читайте об этом ниже), то делайте это один раз, например, в самом конце.

- Директиву Host лучше писать под отдельным «User-agent: Yandex», чтобы не смущать ботов ее не поддерживающих

Мета-тег Robots — помогает закрыть дубли контента при индексации сайта

Существует еще один способ настроить (разрешить или запретить) индексацию отдельных страниц вебсайта, как для Яндекса, так и для Гугл. Причем для Google этот метод гораздо приоритетнее описанного выше. Поэтому, если нужно наверняка закрыть страницу от индексации этой поисковой системой, то данный мета-тег нужно будет прописывать в обязательном порядке.

Для этого внутри тега «HEAD» нужной вебстраницы дописывается МЕТА-тег Robots с нужными параметрами, и так повторяется для всех документов, к которым нужно применить то или иное правило (запрет или разрешение). Выглядеть это может, например, так:

<html> <head> <meta name="robots" content="noindex,nofollow"> <meta name="description" content="Эта страница ...."> <title>...</title> </head> <body> ...

В этом случае, боты всех поисковых систем должны будут забыть об индексации этой вебстраницы (об этом говорит присутствие noindex в данном мета-теге) и анализе размещенных на ней ссылок (об этом говорит присутствие nofollow — боту запрещается переходить по ссылкам, которые он найдет в этом документе).

Существуют только две пары параметров у метатега robots: [no]index и [no]follow:

- Index — указывают, может ли робот проводить индексацию данного документа

- Follow — может ли он следовать по ссылкам, найденным в этом документе

Значения по умолчанию (когда этот мета-тег для страницы вообще не прописан) – «index» и «follow». Есть также укороченный вариант написания с использованием «all» и «none», которые обозначают активность обоих параметров или, соответственно, наоборот: all=index,follow и none=noindex,nofollow.

Более подробные объяснения можно найти, например, в хелпе Яндекса:

Для блога на WordPress вы сможете настроить мета-тег Robots, например, с помощью плагина All in One SEO Pack. Если используете другие плагины или другие движки сайта, то гуглите на тему прописывания для нужных страниц meta name=»robots».

Если используете другие плагины или другие движки сайта, то гуглите на тему прописывания для нужных страниц meta name=»robots».

Как создать правильный роботс.тхт?

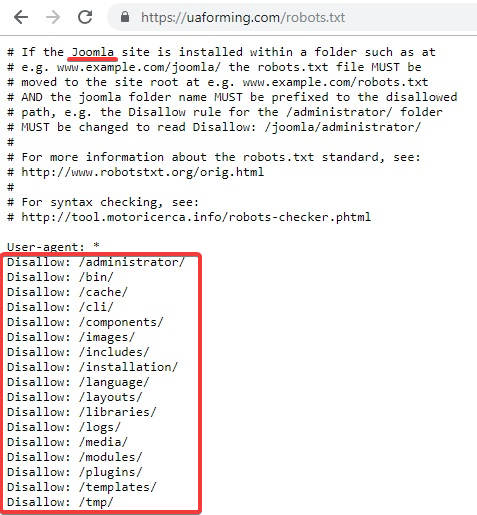

Ну все, с теорией покончено и пора переходить к практике, а именно к составлению оптимальных robots.txt. Как известно, у проектов, созданных на основе какого-либо движка (Joomla, WordPress и др), имеется множество вспомогательных объектов не несущих никакой информативной нагрузки.

Если не запретить индексацию всего этого мусора, то время, отведенное поисковиками на индексацию вашего сайта, будет тратиться на перебор файлов движка (на предмет поиска в них информационной составляющей, т.е. контента). Но фишка в том, что в большинстве CMS контент хранится не в файликах, а в базе данных, к которой поисковым ботам никак не добраться. Полазив по мусорным объектам движка, бот исчерпает отпущенное ему время и уйдет не солоно хлебавши.

Кроме того, следует стремиться к уникальности контента на своем проекте и не следует допускать полного или даже частичного дублирования контента (информационного содержимого). Дублирование может возникнуть в том случае, если один и тот же материал будет доступен по разным адресам (URL).

Дублирование может возникнуть в том случае, если один и тот же материал будет доступен по разным адресам (URL).

Яндекс и Гугл, проводя индексацию, обнаружат дубли и, возможно, примут меры к некоторой пессимизации вашего ресурса при их большом количестве (машинные ресурсы стоят дорого, а посему затраты нужно минимизировать). Да, есть еще такая штука, как мета-тэг Canonical.

Замечательный инструмент для борьбы с дублями контента — поисковик просто не будет индексировать страницу, если в Canonical прописан другой урл. Например, для такой страницы https://ktonanovenkogo.ru/page/2 моего блога (страницы с пагинацией) Canonical указывает на https://ktonanovenkogo.ru и никаких проблем с дублированием тайтлов возникнуть не должно.

<link rel="canonical" href="https://ktonanovenkogo.ru/" />

Но это я отвлекся…

Если ваш проект создан на основе какого-либо движка, то дублирование контента будет иметь место с высокой вероятностью, а значит нужно с ним бороться, в том числе и с помощью запрета в robots. txt, а особенно в мета-теге, ибо в первом случае Google запрет может и проигнорировать, а вот на метатег наплевать он уже не сможет (так воспитан).

txt, а особенно в мета-теге, ибо в первом случае Google запрет может и проигнорировать, а вот на метатег наплевать он уже не сможет (так воспитан).

Например, в WordPress страницы с очень похожим содержимым могут попасть в индекс поисковиков, если разрешена индексация и содержимого рубрик, и содержимого архива тегов, и содержимого временных архивов. Но если с помощью описанного выше мета-тега Robots создать запрет для архива тегов и временного архива (можно теги оставить, а запретить индексацию содержимого рубрик), то дублирования контента не возникнет. Как это сделать описано по ссылке приведенной чуть выше (на плагин ОлИнСеоПак)

Подводя итог скажу, что файл Роботс предназначен для задания глобальных правил запрета доступа в целые директории сайта, либо в файлы и папки, в названии которых присутствуют заданные символы (по маске). Примеры задания таких запретов вы можете посмотреть чуть выше.

Теперь давайте рассмотрим конкретные примеры роботса, предназначенного для разных движков — Joomla, WordPress и SMF. Естественно, что все три варианта, созданные для разных CMS, будут существенно (если не сказать кардинально) отличаться друг от друга. Правда, у всех у них будет один общий момент, и момент этот связан с поисковой системой Яндекс.

Естественно, что все три варианта, созданные для разных CMS, будут существенно (если не сказать кардинально) отличаться друг от друга. Правда, у всех у них будет один общий момент, и момент этот связан с поисковой системой Яндекс.

Т.к. в рунете Яндекс имеет достаточно большой вес, то нужно учитывать все нюансы его работы, и тут нам поможет директива Host. Она в явной форме укажет этому поисковику главное зеркало вашего сайта.

Для нее советуют использовать отдельный блог User-agent, предназначенный только для Яндекса (User-agent: Yandex). Это связано с тем, что остальные поисковые системы могут не понимать Host и, соответственно, ее включение в запись User-agent, предназначенную для всех поисковиков (User-agent: *), может привести к негативным последствиям и неправильной индексации.

Как обстоит дело на самом деле — сказать трудно, ибо алгоритмы работы поиска — это вещь в себе, поэтому лучше сделать так, как советуют. Но в этом случае придется продублировать в директиве User-agent: Yandex все те правила, что мы задали User-agent: *. Если вы оставите User-agent: Yandex с пустым

Если вы оставите User-agent: Yandex с пустым Disallow:, то таким образом вы разрешите Яндексу заходить куда угодно и тащить все подряд в индекс.

Robots для WordPress

Не буду приводить пример файла, который рекомендуют разработчики. Вы и сами можете его посмотреть. Многие блогеры вообще не ограничивают ботов Яндекса и Гугла в их прогулках по содержимому движка WordPress. Чаще всего в блогах можно встретить роботс, автоматически заполненный плагином Google XML Sitemaps.

Но, по-моему, все-таки следует помочь поиску в нелегком деле отсеивания зерен от плевел. Во-первых, на индексацию этого мусора уйдет много времени у ботов Яндекса и Гугла, и может совсем не остаться времени для добавления в индекс вебстраниц с вашими новыми статьями. Во-вторых, боты, лазящие по мусорным файлам движка, будут создавать дополнительную нагрузку на сервер вашего хоста, что не есть хорошо.

Мой вариант этого файла вы можете сами посмотреть. Он старый, давно не менялся, но я стараюсь следовать принципу «не чини то, что не ломалось», а вам уже решать: использовать его, сделать свой или еще у кого-то подсмотреть. У меня там еще запрет индексации страниц с пагинацией был прописан до недавнего времени (Disallow: */page/), но недавно я его убрал, понадеясь на Canonical, о котором писал выше.

У меня там еще запрет индексации страниц с пагинацией был прописан до недавнего времени (Disallow: */page/), но недавно я его убрал, понадеясь на Canonical, о котором писал выше.

А вообще, единственно правильного файла для WordPress, наверное, не существует. Можно, кончено же, реализовать в нем любые предпосылки, но кто сказал, что они будут правильными. Вариантов идеальных robots.txt в сети много.

Приведу две крайности:

- Тут можно найти мегафайлище с подробными пояснениями (символом # отделяются комментарии, которые в реальном файле лучше будет удалить):

User-agent: * # общие правила для роботов, кроме Яндекса и Google, # т.к. для них правила ниже Disallow: /cgi-bin # папка на хостинге Disallow: /? # все параметры запроса на главной Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет, # правило можно удалить) Disallow: *?s= # поиск Disallow: *&s= # поиск Disallow: /search/ # поиск Disallow: /author/ # архив автора Disallow: /users/ # архив авторов Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой # ссылки на статью Disallow: */feed # все фиды Disallow: */rss # rss фид Disallow: */embed # все встраивания Disallow: */wlwmanifest.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat