- Что такое robots.txt и зачем он вообще нужен

- Как закрыть сайт от индексации в robots.txt

- Что такое robots.txt [Основы для новичков]

- Все о файле «robots.txt» по-русски — как составить robots.txt

- Файл robots.txt

- Создание robots.txt

- Описание robots.txt

- Где размещать файл robots.

- Что писать в файл robots.txt

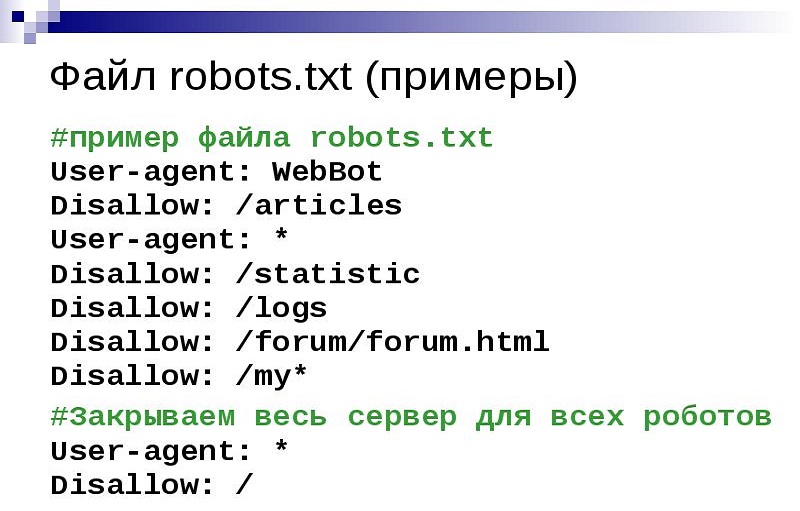

- Запретить весь сайт для индексации всеми роботами

- Разрешить всем роботам индексировать весь сайт

- Закрыть от индексации только несколько каталогов

- Запретить индексацию сайта только для одного робота

- Разрешить индексацию сайта одному роботу и запретить всем остальным

- Запретить к индексации все файлы кроме одного

- Инфографика

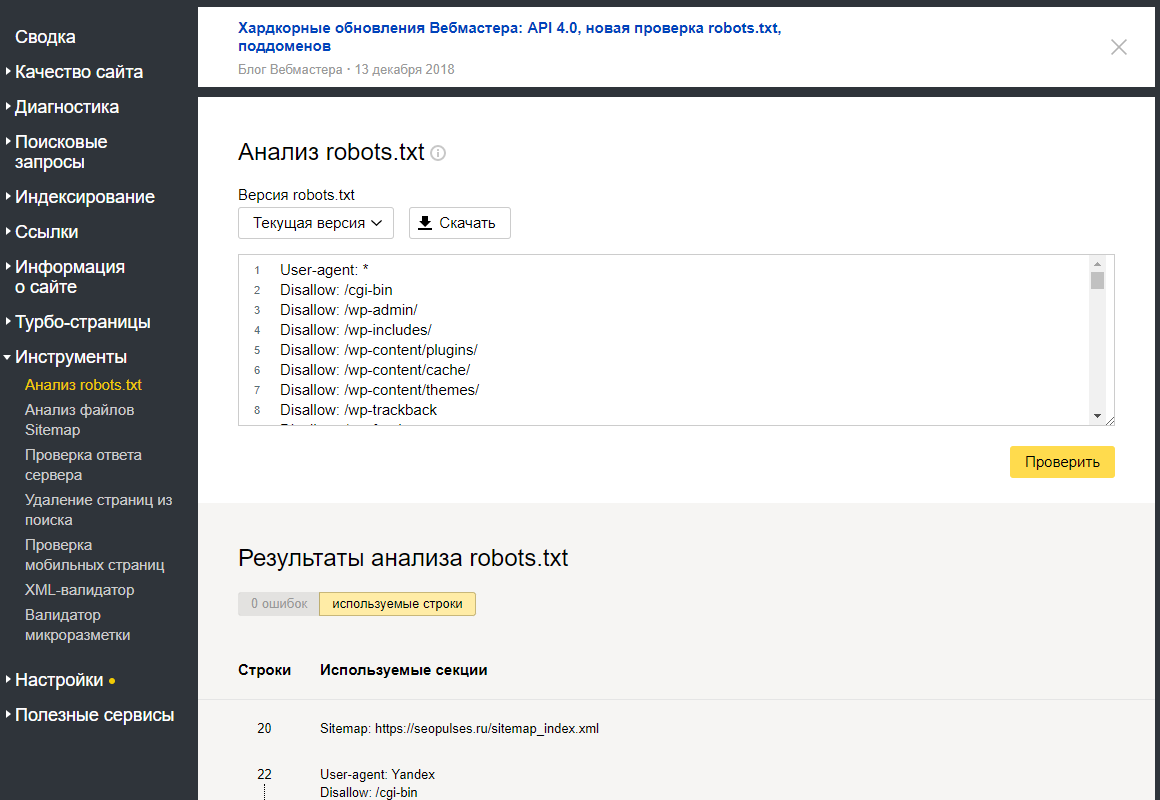

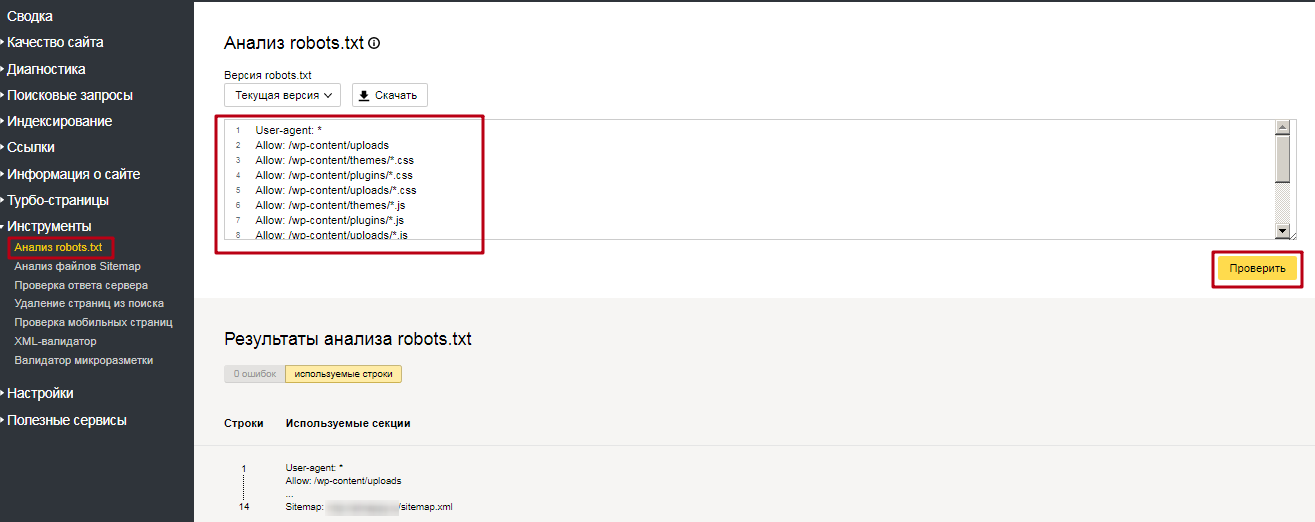

- Проверка

- О сайте

- robots txt: что это такое за файл и как использовать его

- Robots.txt — инструкция для SEO

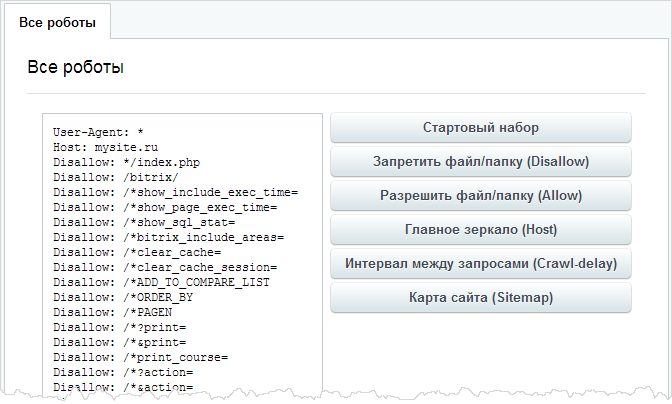

- Управление robots.txt

- Robots.txt Введение и руководство | Центр поиска Google

- Создайте файл robots.txt | Центр поиска Google | Разработчики Google

- Файл robots.txt [примеры 2021] - Moz

- Как создать идеальный файл Robots.txt для SEO

- Robots.txt и SEO: полное руководство

- Файлы Robots.txt

- Robots.txt - Все, что нужно знать оптимизаторам поисковых систем

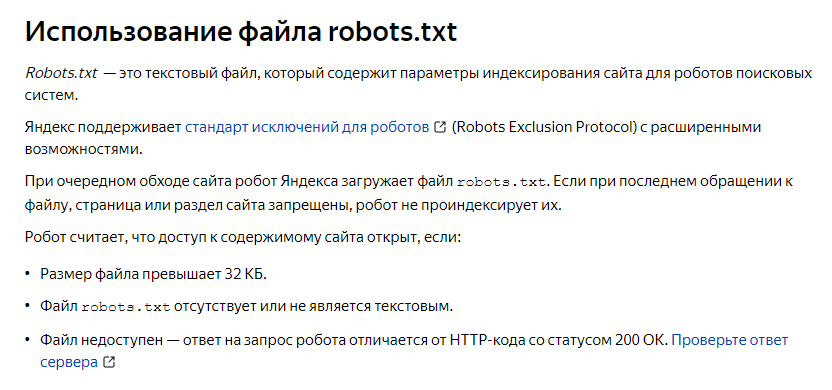

- Для чего используется txt-файл robots?

- Где должен существовать файл robots.txt?

- Когда следует использовать правила robots.txt?

- Когда нельзя использовать robots.

- 1. Блокировка Javascript / CSS

- 2. Параметры блокировки URL

- 3. Блокировка URL с обратными ссылками

- 4. Получение деиндексированных проиндексированных страниц

- 5. Установка правил, игнорирующих поисковые роботы социальных сетей

- 6. Блокировка доступа с тестовых сайтов или сайтов разработчиков

- 7. Когда нечего блокировать

- Синтаксис и форматирование файла Robots.txt

- Robots.txt Блокирует

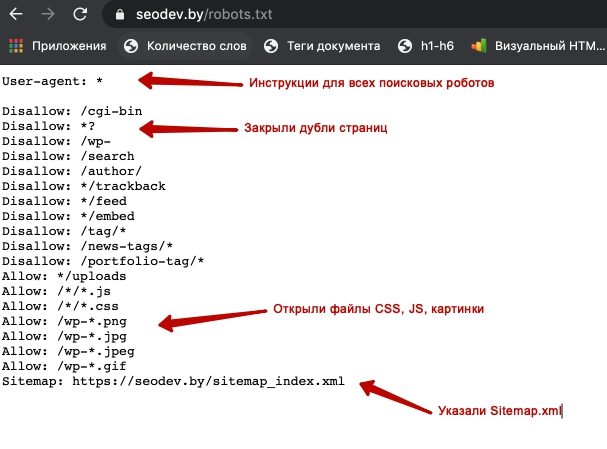

- Robots.txt Разрешить

- Robots.txt Приоритизация

- Роботы.txt Директивы

- Обычные роботы.txt, проблемы

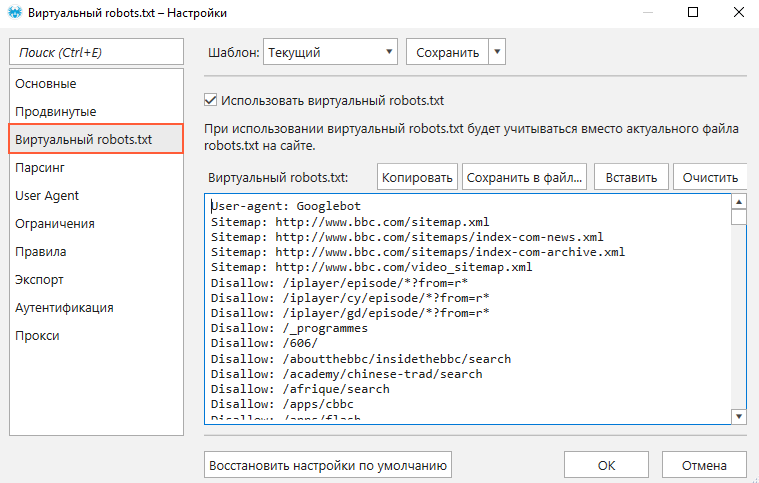

- Роботы для тестирования и аудита.txt

- Monitoring Robots.txt Changes

Что такое robots.txt и зачем он вообще нужен

Каждый блог дает свой ответ на этот счет. Поэтому новички в поисковом продвижении часто путаются, вот так:

Что за роботс ти экс ти?

Файл robots.txt или индексный файл — обычный текстовый документ в кодировке UTF-8, действует для протоколов http, https, а также FTP. Файл дает поисковым роботам рекомендации: какие страницы/файлы стоит сканировать. Если файл будет содержать символы не в UTF-8, а в другой кодировке, поисковые роботы могут неправильно их обработать. Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, протокола и номера порта, где размещен файл.

Файл должен располагаться в корневом каталоге в виде обычного текстового документа и быть доступен по адресу: https://site.com.ua/robots.txt.

В других файлах принято ставить отметку ВОМ (Byte Order Mark). Это Юникод-символ, который используется для определения последовательности в байтах при считывании информации. Его кодовый символ — U+FEFF. В начале файла robots.txt отметка последовательности байтов игнорируется.

Его кодовый символ — U+FEFF. В начале файла robots.txt отметка последовательности байтов игнорируется.

Google установил ограничение по размеру файла robots.txt — он не должен весить больше 500 Кб.

Ладно, если вам интересны сугубо технические подробности, файл robots.txt представляет собой описание в форме Бэкуса-Наура (BNF). При этом используются правила RFC 822.

При обработке правил в файле robots.txt поисковые роботы получают одну из трех инструкций:

- частичный доступ: доступно сканирование отдельных элементов сайта;

- полный доступ: сканировать можно все;

- полный запрет: робот ничего не может сканировать.

При сканировании файла robots.txt роботы получают такие ответы:

- 2xx — сканирование прошло удачно;

- 3xx — поисковый робот следует по переадресации до тех пор, пока не получит другой ответ. Чаще всего есть пять попыток, чтобы робот получил ответ, отличный от ответа 3xx, затем регистрируется ошибка 404;

- 4xx — поисковый робот считает, что можно сканировать все содержимое сайта;

- 5xx — оцениваются как временные ошибки сервера, сканирование полностью запрещается.

Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обрабатываться с кодом ответа 404.

Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обрабатываться с кодом ответа 404.

Пока что неизвестно, как обрабатывается файл robots.txt, который недоступен из-за проблем сервера с выходом в интернет.

Зачем нужен файл robots.txt

Например, иногда роботам не стоит посещать:

- страницы с личной информацией пользователей на сайте;

- страницы с разнообразными формами отправки информации;

- сайты-зеркала;

- страницы с результатами поиска.

Важно: даже если страница находится в файле robots.txt, существует вероятность, что она появится в выдаче, если на неё была найдена ссылка внутри сайта или где-то на внешнем ресурсе.

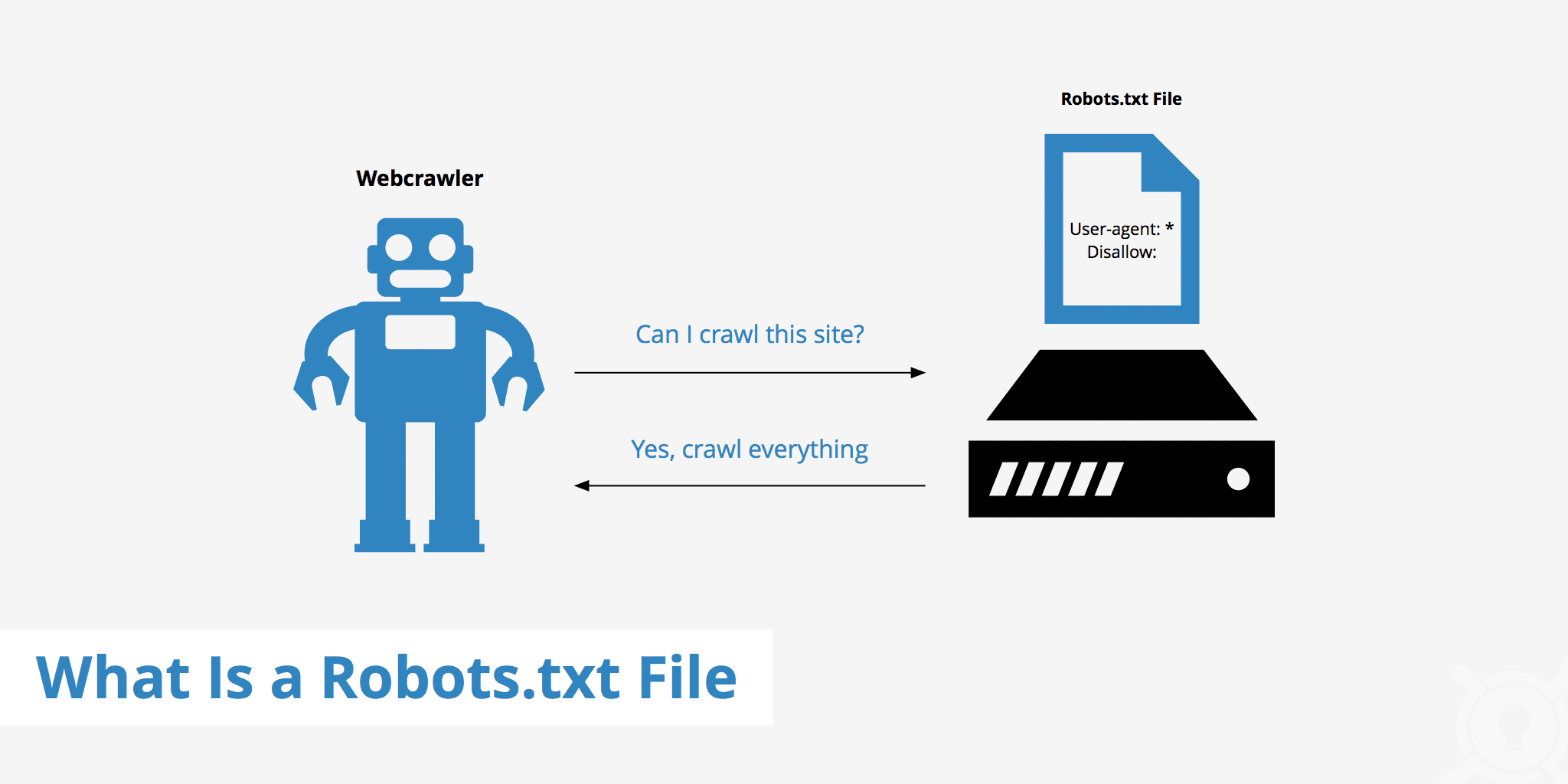

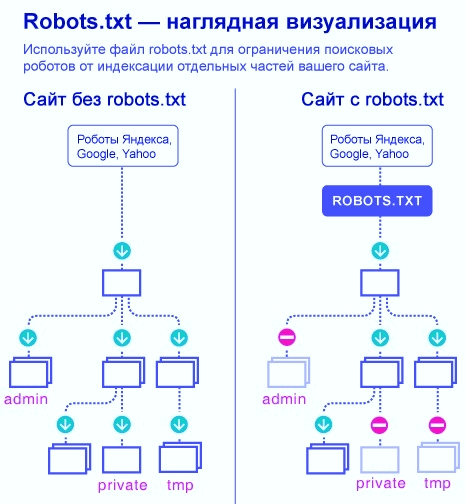

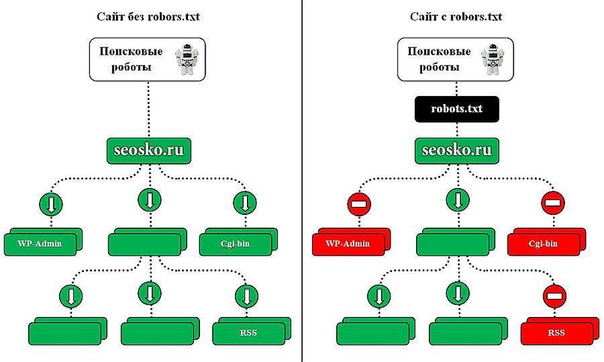

Так роботы поисковых систем видят сайт с файлом robots.txt и без него:

Без robots. txt та информация, которая должна быть скрыта от посторонних глаз, может попасть в выдачу, а из-за этого пострадаете и вы, и сайт.

txt та информация, которая должна быть скрыта от посторонних глаз, может попасть в выдачу, а из-за этого пострадаете и вы, и сайт.

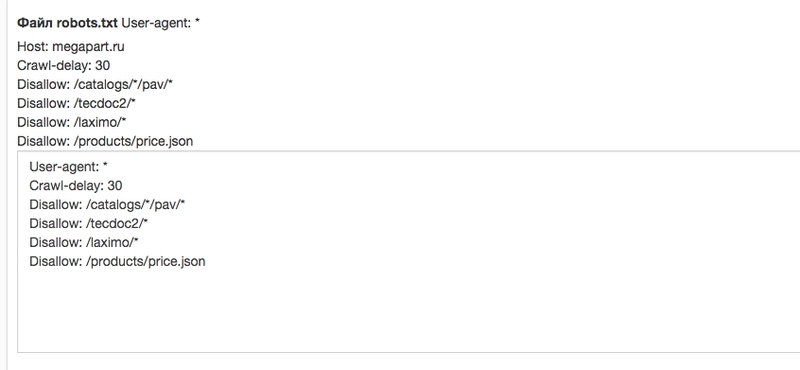

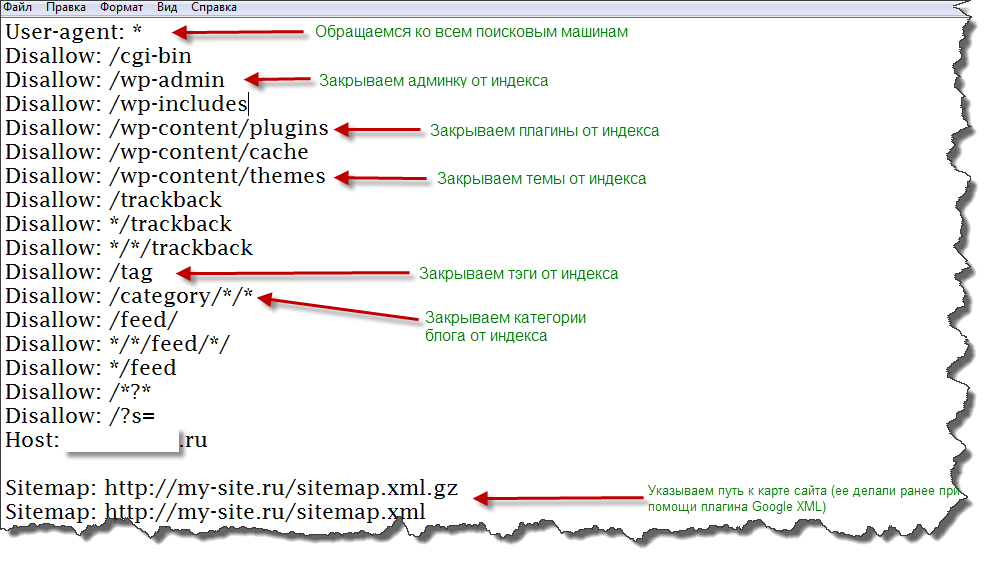

Так робот поисковых систем видит файл robots.txt:

Google обнаружил файл robots.txt на сайте и нашел правила, по которым следует сканировать страницы сайта

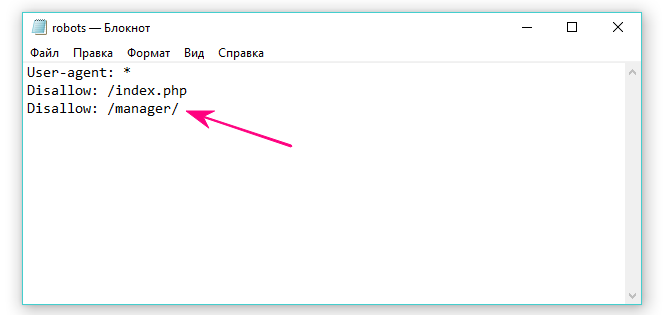

Как создать файл robots.txt

С помощью блокнота, Notepad, Sublime, либо любого другого текстового редактора.

В содержании файла должны быть прописаны инструкция User-agent и правило Disallow, к тому же есть еще несколько второстепенных правил.

User-agent — визитка для роботов

User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в файле robots.txt. На данный момент известно 302 поисковых робота. Чтобы не прописывать всех по отдельности, стоит использовать запись:

Она говорит о том, что мы указываем правила в robots.txt для всех поисковых роботов.

Для Google главным роботом является Googlebot. Если мы хотим учесть только его, запись в файле будет такой:

Если мы хотим учесть только его, запись в файле будет такой:

В этом случае все остальные роботы будут сканировать контент на основании своих директив по обработке пустого файла robots.txt.

Для Yandex главным роботом является… Yandex:

Другие специальные роботы:

- Mediapartners-Google — для сервиса AdSense;

- AdsBot-Google — для проверки качества целевой страницы;

- YandexImages — индексатор Яндекс.Картинок;

- Googlebot-Image — для картинок;

- YandexMetrika — робот Яндекс.Метрики;

- YandexMedia — робот, индексирующий мультимедийные данные;

- YaDirectFetcher — робот Яндекс.Директа;

- Googlebot-Video — для видео;

- Googlebot-Mobile — для мобильной версии;

- YandexDirectDyn — робот генерации динамических баннеров;

- YandexBlogs — робот поиск по блогам, индексирующий посты и комментарии;

- YandexMarket— робот Яндекс.

Маркета;

Маркета; - YandexNews — робот Яндекс.Новостей;

- YandexDirect — скачивает информацию о контенте сайтов-партнеров Рекламной сети, чтобы уточнить их тематику для подбора релевантной рекламы;

- YandexPagechecker — валидатор микроразметки;

- YandexCalendar — робот Яндекс.Календаря.

Disallow — расставляем «кирпичи»

Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

Такая запись открывает для сканирования весь сайт:

А эта запись говорит о том, что абсолютно весь контент на сайте запрещен для сканирования:

Ее стоит использовать, если сайт находится в процессе доработок, и вы не хотите, чтобы он в нынешнем состоянии засветился в выдаче.

Важно снять это правило, как только сайт будет готов к тому, чтобы его увидели пользователи. К сожалению, об этом забывают многие вебмастера.

Пример. Как прописать правило Disallow, чтобы дать рекомендации роботам не просматривать содержимое папки /papka/:

Чтобы роботы не сканировали конкретный URL:

Чтобы роботы не сканировали конкретный файл:

Чтобы роботы не сканировали все файлы определенного разрешения на сайте:

Данная строка запрещает индексировать все файлы с расширением . gif

gif

Allow — направляем роботов

Allow разрешает сканировать какой-либо файл/директиву/страницу. Допустим, необходимо, чтобы роботы могли посмотреть только страницы, которые начинались бы с /catalog, а весь остальной контент закрыть. В этом случае прописывается следующая комбинация:

Правила Allow и Disallow сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно. Если для страницы подходит несколько правил, робот выбирает последнее правило в отсортированном списке.

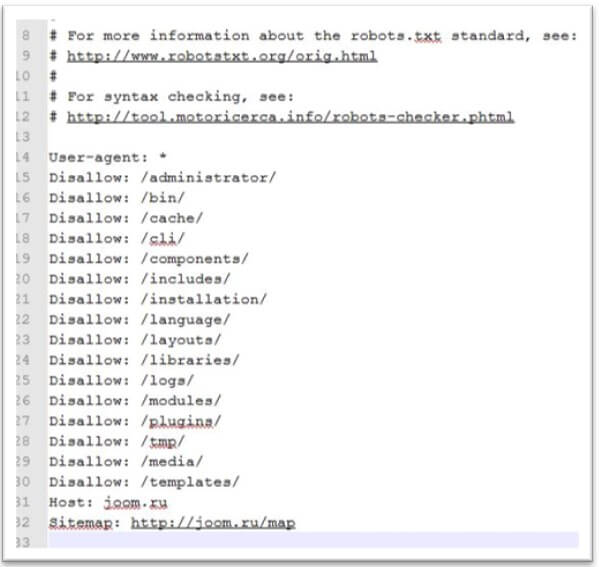

Host — выбираем зеркало сайта

Host — одно из обязательных для robots.txt правил, оно сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

Зеркало сайта — точная или почти точная копия сайта, доступная по разным адресам.

Робот не будет путаться при нахождении зеркал сайта и поймет, что главное зеркало указано в файле robots.txt. Адрес сайта указывается без приставки «http://», но если сайт работает на HTTPS, приставку «https://» указать нужно.

Как необходимо прописать это правило:

Пример файла robots.txt, если сайт работает на протоколе HTTPS:

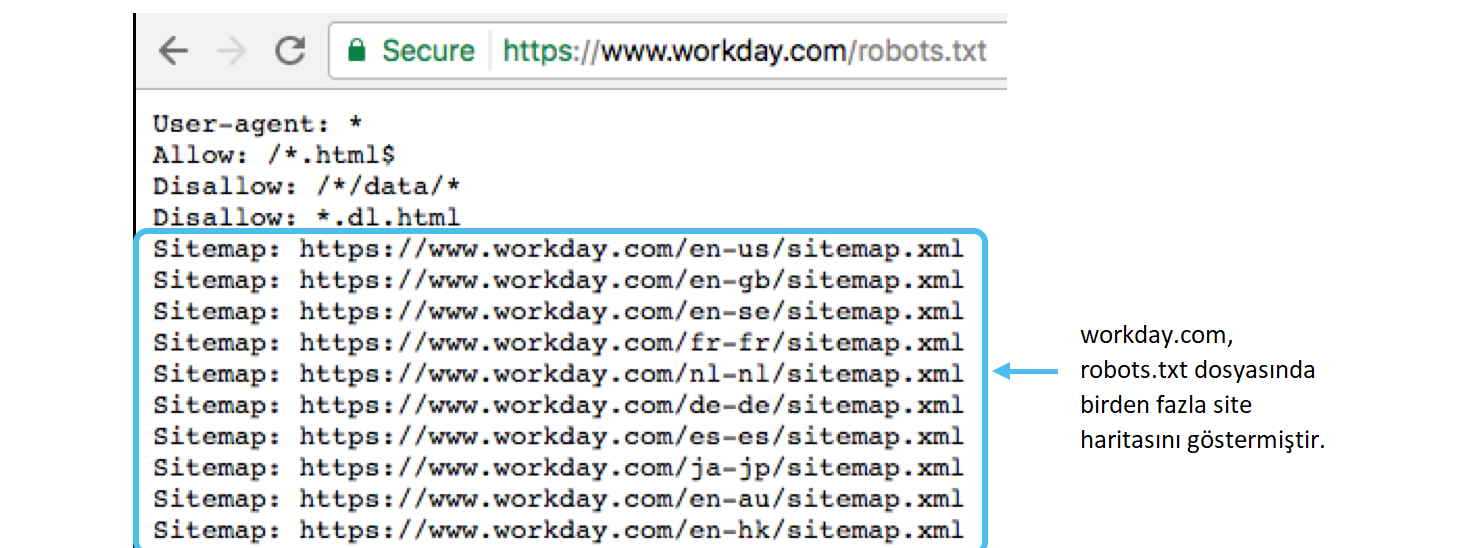

Sitemap — медицинская карта сайта

Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу http://site.ua/sitemap.xml. При каждом обходе робот будет смотреть, какие изменения вносились в этот файл, и быстро освежать информацию о сайте в базах данных поисковой системы.

Инструкция должна быть грамотно вписана в файл:

Crawl-delay — секундомер для слабых серверов

Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта. Данное правило актуально, если у вас слабый сервер. В таком случае возможны большие задержки при обращении поисковых роботов к страницам сайта. Этот параметр измеряется в секундах.

Clean-param — охотник за дублирующимся контентом

Clean-param помогает бороться с get-параметрами для избежания дублирования контента, который может быть доступен по разным динамическим адресам (со знаками вопроса). Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Допустим, страница доступна по адресам:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

В таком случае файл robots.txt будет выглядеть так:

Здесь ref указывает, откуда идет ссылка, поэтому она записывается в самом начале, а уже потом указывается остальная часть адреса.

Но прежде чем перейти к эталонному файлу, необходимо еще узнать о некоторых знаках, которые применяются при написании файла robots.txt.

Символы в robots.txt

Основные символы файла — «/, *, $, #».

С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами. Например, если стоит один слеш в правиле Disallow, мы запрещаем сканировать весь сайт. С помощью двух знаков слэш можно запретить сканирование какой-либо отдельной директории, например: /catalog/.

Такая запись говорит, что мы запрещаем сканировать все содержимое папки catalog, но если мы напишем /catalog, запретим все ссылки на сайте, которые будут начинаться на /catalog.

Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

Эта запись говорит, что все роботы не должны индексировать любые файлы с расширением .gif в папке /catalog/

Знак доллара «$» ограничивает действия знака звездочки. Если необходимо запретить все содержимое папки catalog, но при этом нельзя запретить урлы, которые содержат /catalog, запись в индексном файле будет такой:

Решетка «#» используется для комментариев, которые вебмастер оставляет для себя или других вебмастеров. Робот не будет их учитывать при сканировании сайта.

Например:

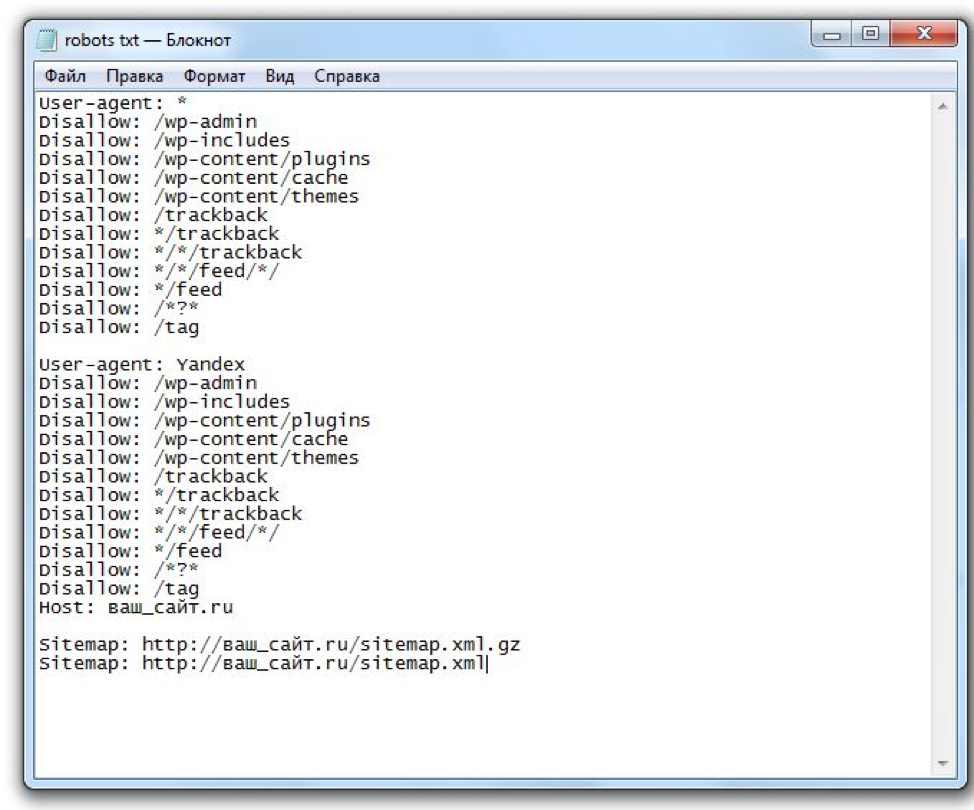

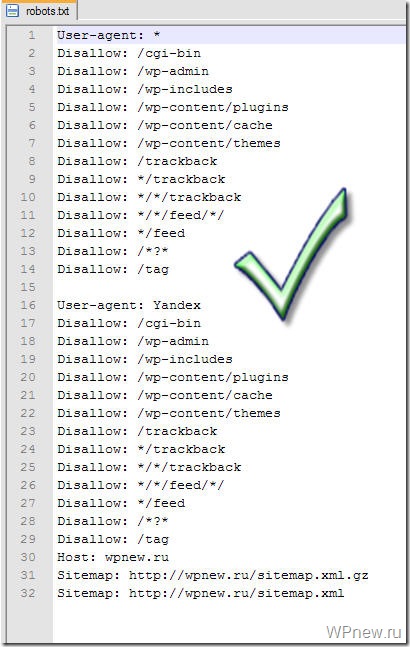

Как выглядит идеальный robots.txt

Такой файл robots.txt можно разместить почти на любом сайте:

Файл открывает содержимое сайта для индексирования, прописан хост и указана карта сайта, которая позволит поисковым системам всегда видеть адреса, которые должны быть проиндексированы. Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Но не спешите копировать содержимое файл к себе — для каждого сайта должны быть прописаны уникальные правила, которые зависит от типа сайта и CMS. поэтому тут стоит вспомнить все правила при заполнении файла robots.txt.

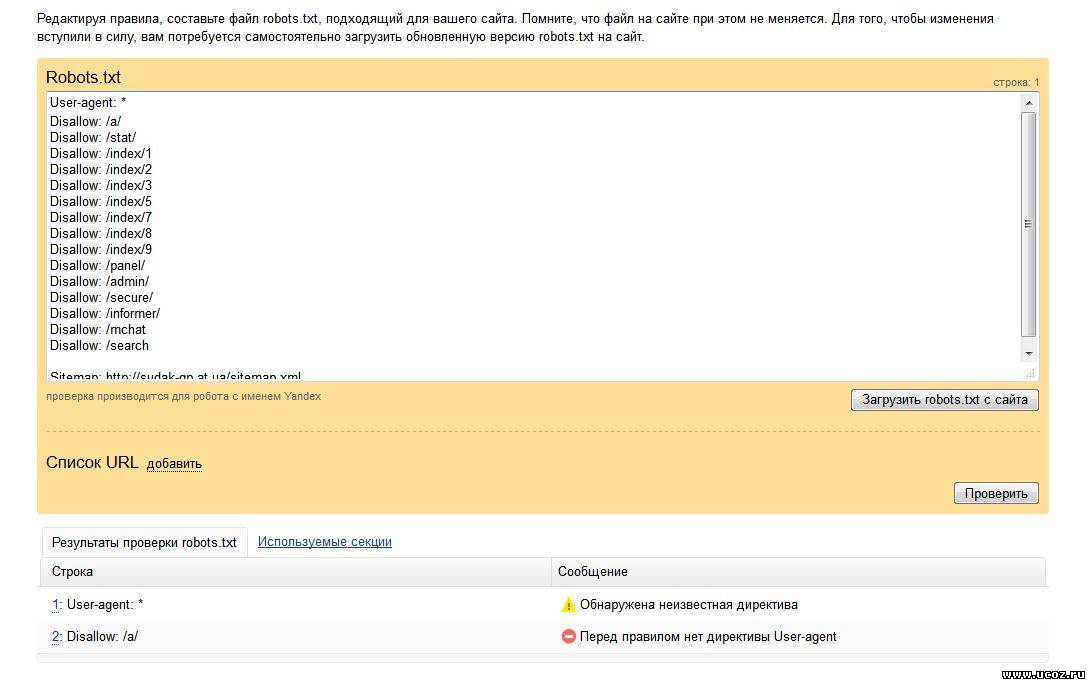

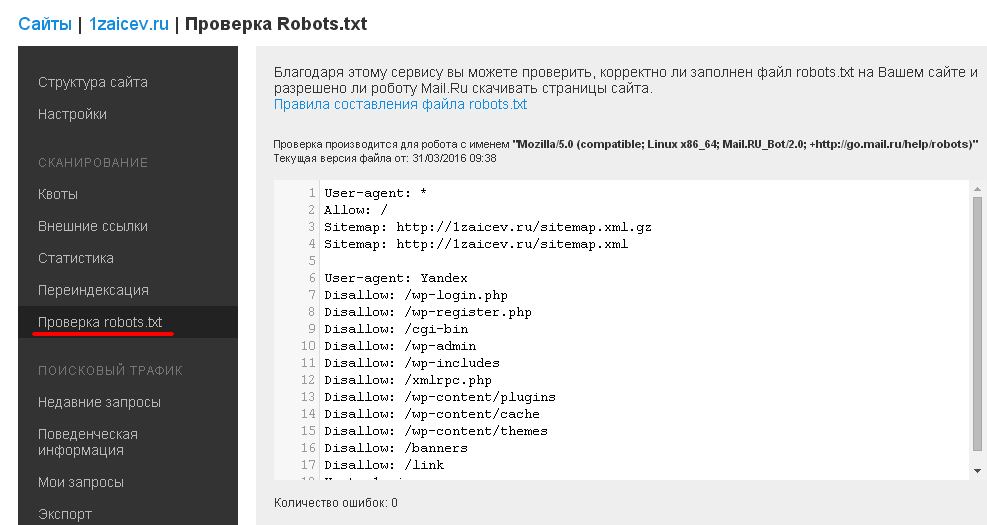

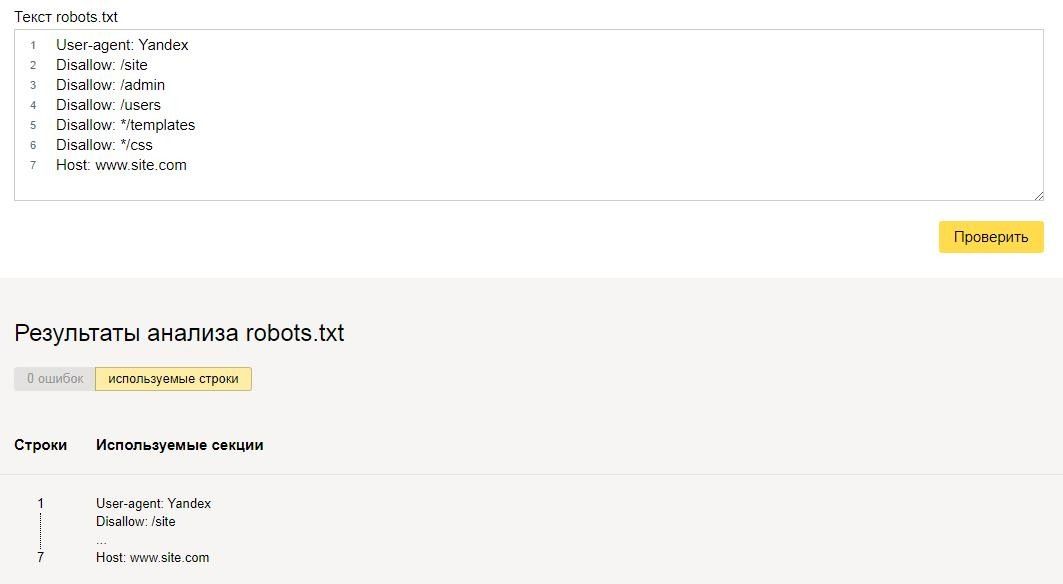

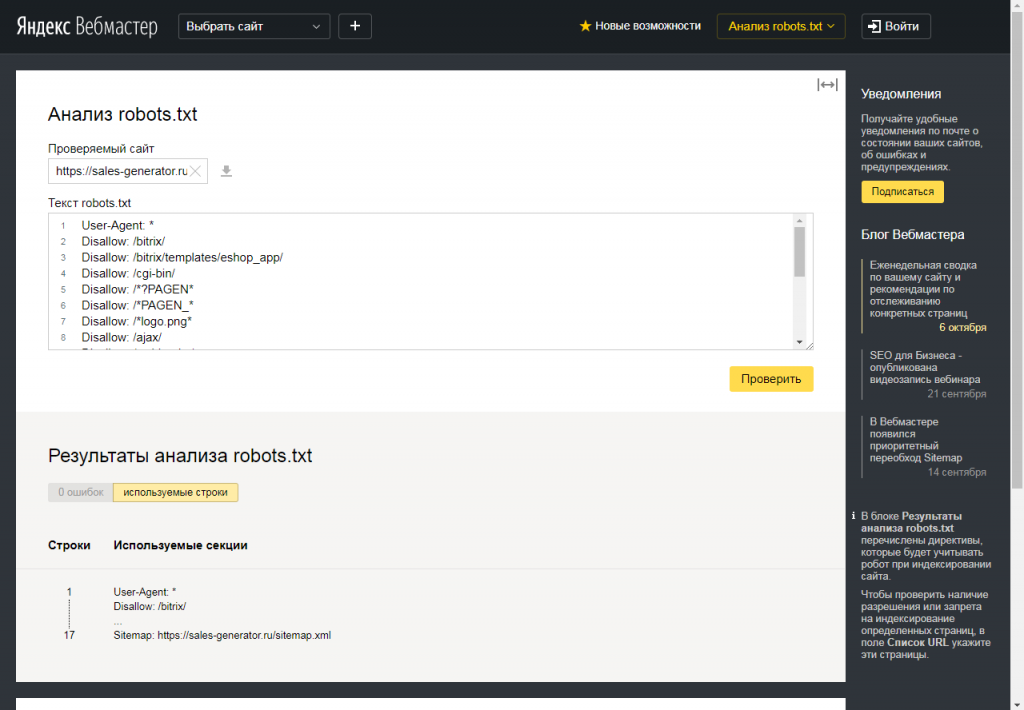

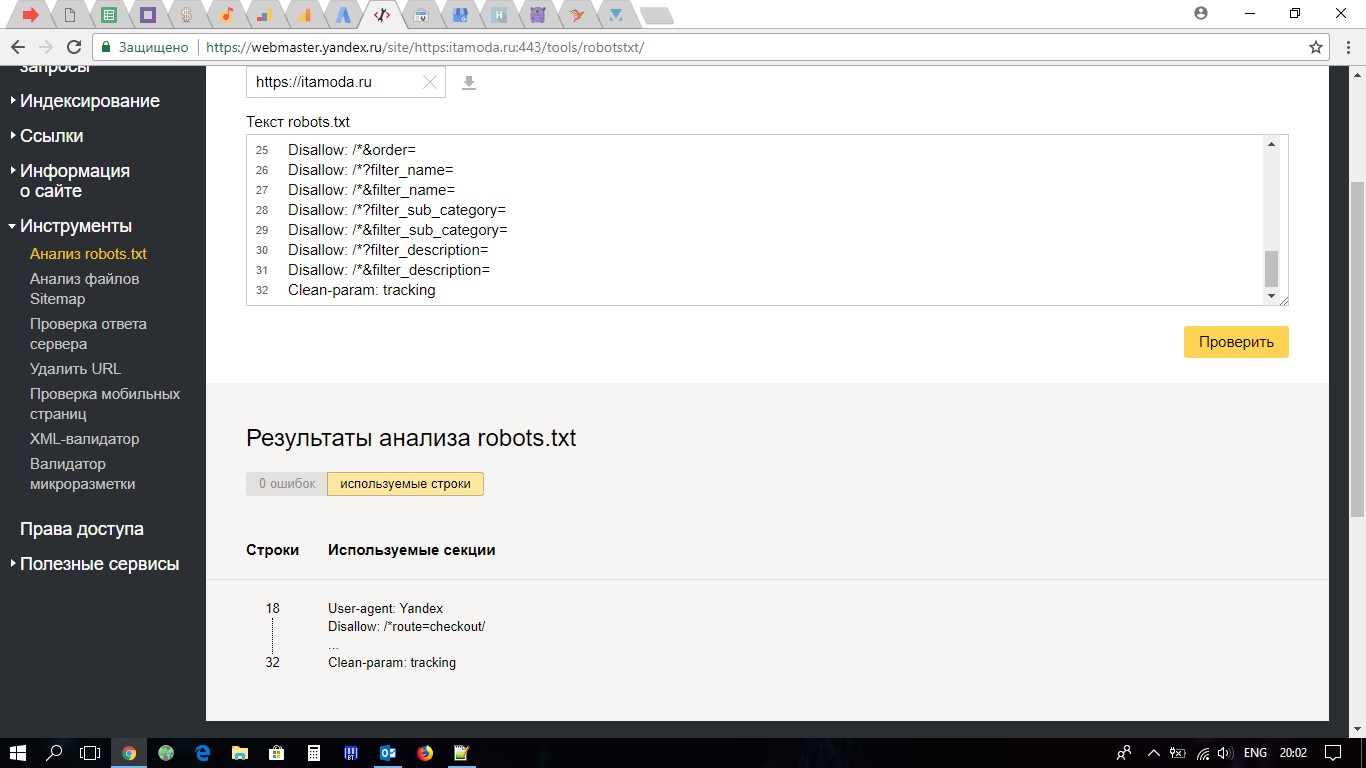

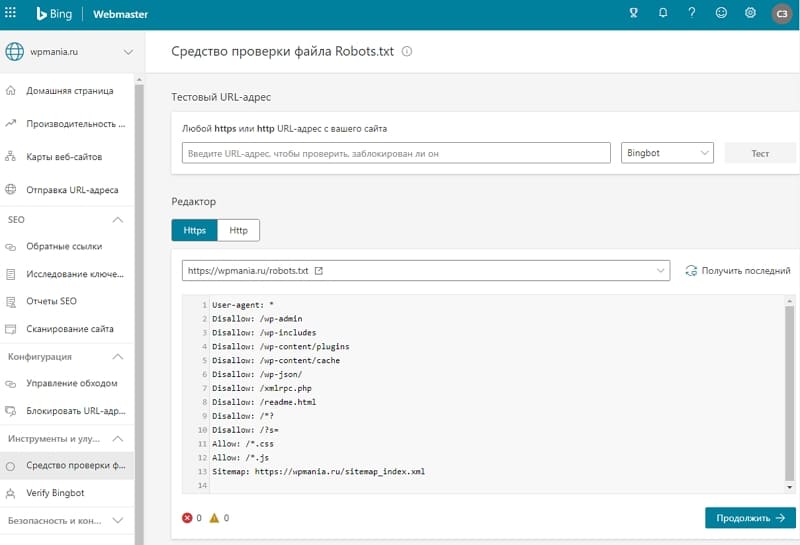

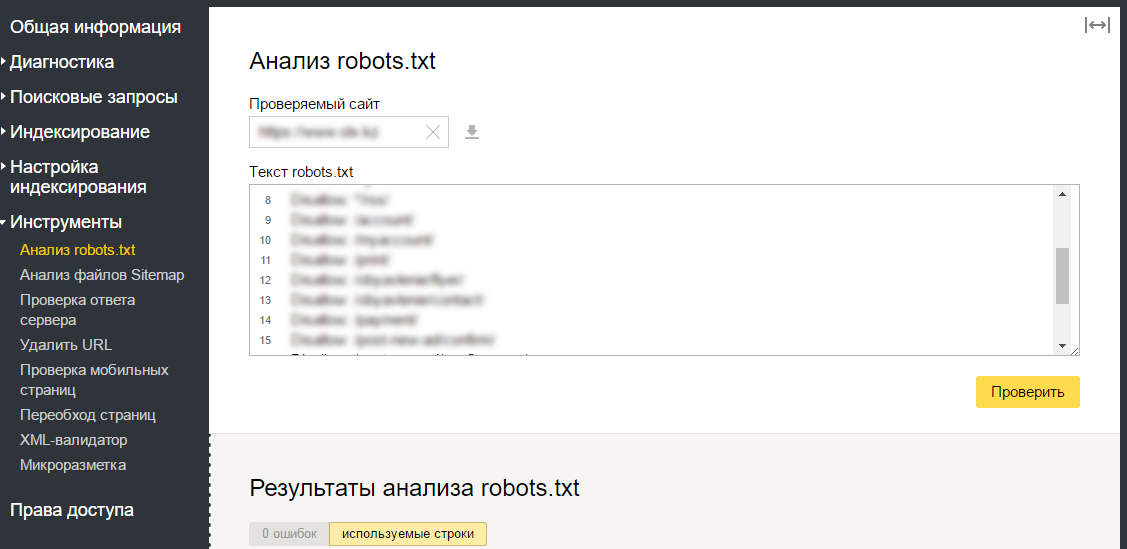

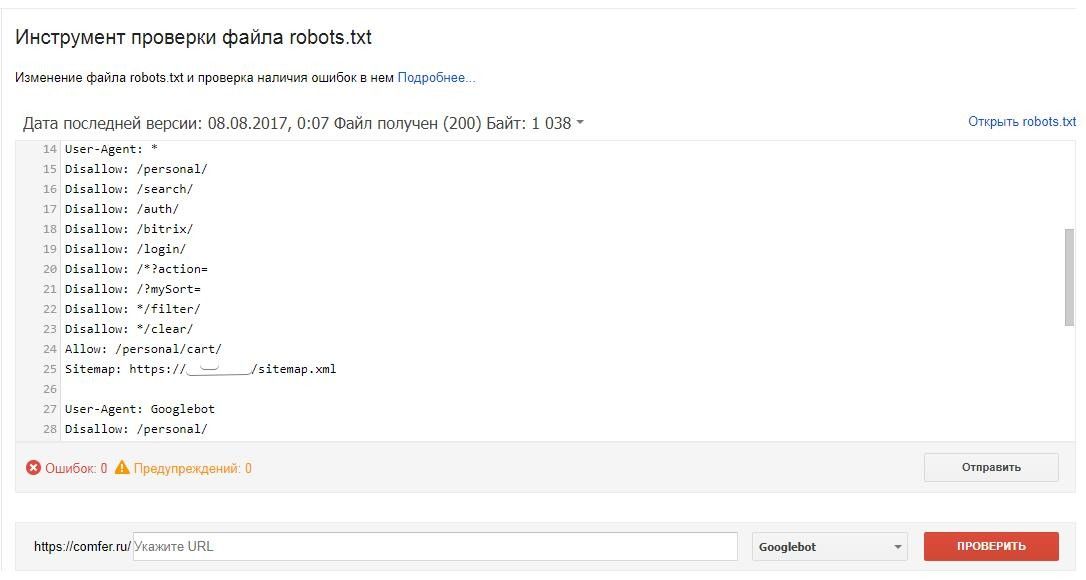

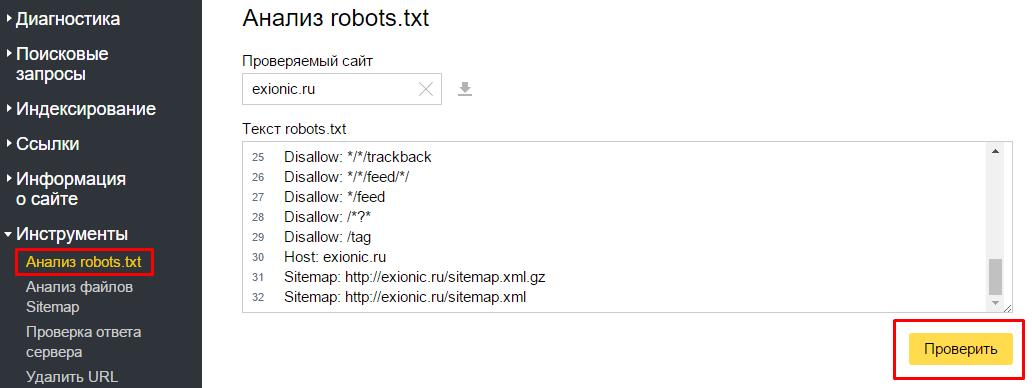

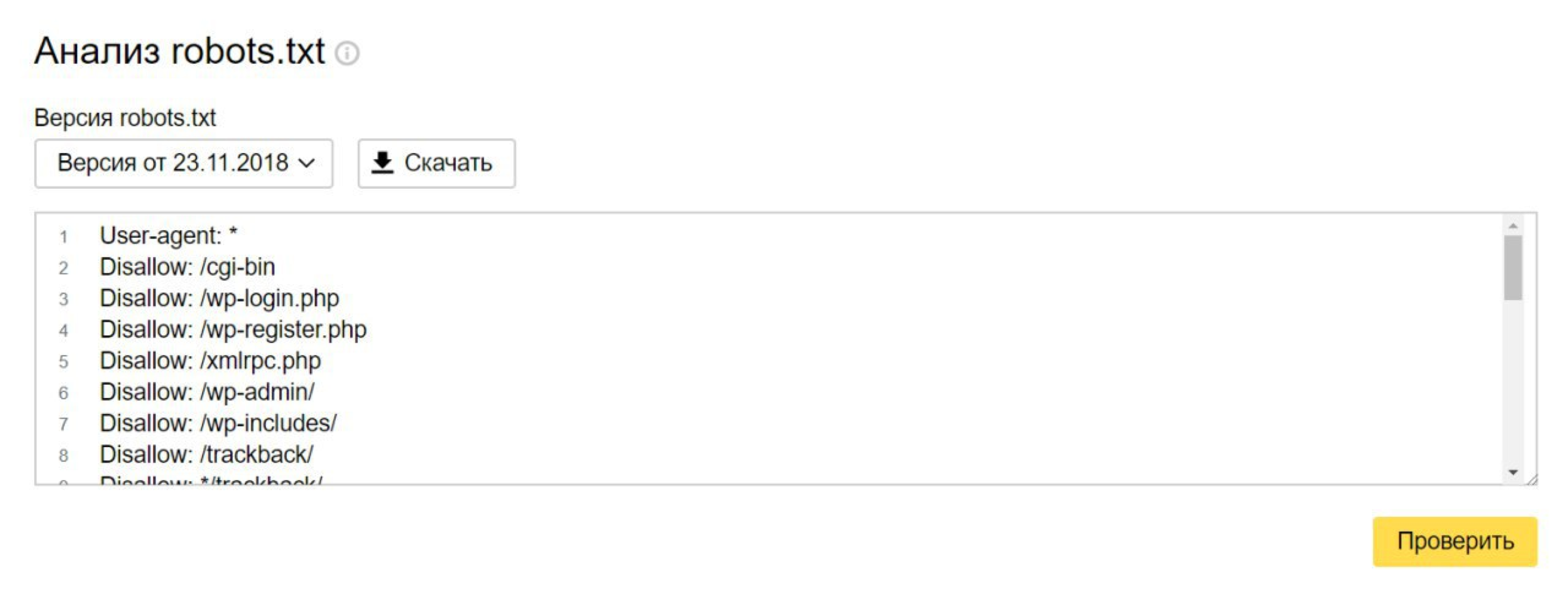

Как проверить файл robots.txt

Если хотите узнать, правильно ли заполнили файл robots.txt, проверьте его в инструментах вебмастеров Google и Яндекс. Просто введите исходный код файла robots.txt в форму по ссылке и укажите проверяемый сайт.

Как не нужно заполнять файл robots.txt

Часто при заполнении индексного файла допускаются досадные ошибки, причем они связаны с обычной невнимательностью или спешкой. Чуть ниже — чарт ошибок, которые я встречала на практике.

1. Перепутанные инструкции:

Правильный вариант:

2. Запись нескольких папок/директорий в одной инструкции Disallow:

Такая запись может запутать поисковых роботов, они могут не понять, что именно им не следует индексировать: то ли первую папку, то ли последнюю, — поэтому нужно писать каждое правило отдельно.

3. Сам файл должен называться только robots.txt, а не Robots.txt, ROBOTS.TXT или как-то иначе.

4. Нельзя оставлять пустым правило User-agent — нужно сказать, какой робот должен учитывать прописанные в файле правила.

5. Лишние знаки в файле (слэши, звездочки).

6. Добавление в файл страниц, которых не должно быть в индексе.

Нестандартное применение robots.txt

Кроме прямых функций индексный файл может стать площадкой для творчества и способом найти новых сотрудников.

Вот сайт, в котором robots.txt сам является маленьким сайтом с рабочими элементами и даже рекламным блоком.

Хотите что-то поинтереснее? Ловите ссылку на robots.txt со встроенной игрой и музыкальным сопровождением.

Многие бренды используют robots.txt, чтобы еще раз заявить о себе:

В качестве площадки для поиска специалистов файл используют в основном SEO-агентства. А кто же еще может узнать о его существовании? 🙂

А у Google есть специальный файл humans. txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

Когда у вебмастера появляется достаточно свободного времени, он часто тратит его на модернизацию robots.txt:

Хотите, чтобы все страницы вашего сайта заходили в индекс быстро? Мы выберем для вас оптимальную стратегию SEO-продвижения:

{«0»:{«lid»:»1531306243545″,»ls»:»10″,»loff»:»»,»li_type»:»nm»,»li_name»:»name»,»li_ph»:»Имя»,»li_req»:»y»,»li_nm»:»name»},»1″:{«lid»:»1573230091466″,»ls»:»20″,»loff»:»»,»li_type»:»ph»,»li_name»:»phone»,»li_req»:»y»,»li_masktype»:»a»,»li_nm»:»phone»},»2″:{«lid»:»1573567927671″,»ls»:»30″,»loff»:»y»,»li_type»:»in»,»li_name»:»surname»,»li_ph»:»Фамилия»,»li_req»:»y»,»li_nm»:»surname»},»3″:{«lid»:»1531306540094″,»ls»:»40″,»loff»:»»,»li_type»:»in»,»li_name»:»domains»,»li_ph»:»Адрес сайта»,»li_rule»:»url»,»li_req»:»y»,»li_nm»:»domains»},»4″:{«lid»:»1573230077755″,»ls»:»50″,»loff»:»»,»li_type»:»em»,»li_name»:»email»,»li_ph»:»Email»,»li_req»:»y»,»li_nm»:»email»},»5″:{«lid»:»1575903646714″,»ls»:»60″,»loff»:»»,»li_type»:»hd»,»li_name»:»comment»,»li_value»:»Автоматический коммент: заявка из блога, без пользовательского комментария»,»li_nm»:»comment»},»6″:{«lid»:»1575903664523″,»ls»:»70″,»loff»:»»,»li_type»:»hd»,»li_name»:»lead_channel_id»,»li_value»:»24″,»li_nm»:»lead_channel_id»},»7″:{«lid»:»1584374224865″,»ls»:»80″,»loff»:»»,»li_type»:»hd»,»li_name»:»ip»,»li_nm»:»ip»},»8″:{«lid»:»1609939359940″,»ls»:»90″,»loff»:»»,»li_type»:»hd»,»li_name»:»post_id»,»li_nm»:»post_id»}}

Поможем обогнать конкурентов

Выводы

С помощью Robots. txt вы сможете задавать инструкции поисковым роботам, рекламировать себя, свой бренд, искать специалистов. Это большое поле для экспериментов. Главное, помните о грамотном заполнении файла и типичных ошибках.

txt вы сможете задавать инструкции поисковым роботам, рекламировать себя, свой бренд, искать специалистов. Это большое поле для экспериментов. Главное, помните о грамотном заполнении файла и типичных ошибках.

Правила, они же директивы, они же инструкции файла robots.txt:

- User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в robots.txt.

- Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

- Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу http://site.ua/sitemap.xml.

- Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта.

- Host сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

- Allow разрешает сканировать какой-либо файл/директиву/страницу.

- Clean-param помогает бороться с get-параметрами для избежания дублирования контента.

Знаки при составлении robots. txt:

txt:

- Знак доллара «$» ограничивает действия знака звездочки.

- С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами.

- Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

- Решетка «#» используется, чтобы обозначить комментарии, которые пишет вебмастер для себя или других вебмастеров.

Используйте индексный файл с умом — и сайт всегда будет в выдаче.

Как закрыть сайт от индексации в robots.txt

Если закрывать сайт полностью не требуется, запрещайте индексацию отдельных страниц. Пользователям не следует видеть в поиске служебные разделы сайта, личные кабинеты, устаревшую информацию из раздела акций или календаря. Дополнительно нужно закрыть от индексации скрипты, всплывающие окна и баннеры, тяжелые файлы. Это поможет уменьшить время индексации и снизит нагрузку на сервер.

Дополнительно нужно закрыть от индексации скрипты, всплывающие окна и баннеры, тяжелые файлы. Это поможет уменьшить время индексации и снизит нагрузку на сервер.

Как закрыть сайт полностью

Запретить индексацию сайта можно для всех поисковиков, для отдельного робота или запретить для всех, кроме одного.

| Запрет для всех |

User-agent: * Disallow: / |

| Запрет для отдельного робота |

User-agent: YandexImages Disallow: / |

|

User-agent: * Disallow: / User-agent: Yandex Allow: / |

Как закрыть отдельные страницы

Маленькие сайты-визитки обычно не требуют сокрытия отдельных страниц. Для ресурсов с большим количеством служебной информации закрывайте страницы и целые разделы:

Для ресурсов с большим количеством служебной информации закрывайте страницы и целые разделы:

- административная панель;

- служебные каталоги;

- личный кабинет;

- формы регистрации;

- формы заказа;

- сравнение товаров;

- избранное;

- корзина;

- каптча;

- всплывающие окна и баннеры;

- поиск на сайте;

- идентификаторы сессий.

Желательно запрещать индексацию т.н. мусорных страниц. Это старые новости, акции и спецпредложения, события и мероприятия в календаре. На информационных сайтах закрывайте статьи с устаревшей информацией. Иначе ресурс будет восприниматься неактуальным. Чтобы не закрывать статьи и материалы, регулярно обновляйте данные в них.

Запрет индексации

| Отдельной страницы |

User-agent: * Disallow: /contact.  html html

|

| Раздела |

User-agent: * Disallow: /catalog/ |

| Всего сайта, кроме одного раздела |

User-agent: * Allow: /catalog |

| Всего раздела, кроме одного подраздела |

User-agent: * Disallow: /product Allow: /product/auto |

| Поиска на сайте |

User-agent: * Disallow: /search |

| Административной панели |

User-agent: * Disallow: /admin |

Как закрыть другую информацию

txt позволяет закрывать папки на сайте, файлы, скрипты, utm-метки. Их можно скрыть полностью или выборочно. Указывайте запрет для индексации всем роботам или отдельным.

txt позволяет закрывать папки на сайте, файлы, скрипты, utm-метки. Их можно скрыть полностью или выборочно. Указывайте запрет для индексации всем роботам или отдельным.

Запрет индексации

| Типа файлов |

User-agent: * Disallow: /*.jpg |

| Папки |

User-agent: * Disallow: /images/ |

| Папку, кроме одного файла |

User-agent: * Disallow: /images/ Allow: file.jpg |

| Скриптов |

User-agent: * Disallow: /plugins/*.js |

| utm-меток |

User-agent: * Disallow: *utm= |

| utm-меток для Яндекса | Clean-Param: utm_source&utm_medium&utm_campaign |

Как закрыть сайт через мета-теги

Альтернативой файлу robots. txt является мета-тег robots. Прописывайте его в исходный код сайта в файле index.html. Размещайте в контейнере <head>. Указывайте, для каких краулеров сайт закрыт от индексации. Если для всех, напишите robots. Если для одного робота, укажите его название. Для Google — Googlebot, для Яндекса — Yandex. Существуют два варианта записи мета-тега.

txt является мета-тег robots. Прописывайте его в исходный код сайта в файле index.html. Размещайте в контейнере <head>. Указывайте, для каких краулеров сайт закрыт от индексации. Если для всех, напишите robots. Если для одного робота, укажите его название. Для Google — Googlebot, для Яндекса — Yandex. Существуют два варианта записи мета-тега.

Вариант 2.

<meta name=”robots” content=”none”/>

Атрибут “content” имеет следующие значения:

- none — индексация запрещена, включая noindex и nofollow;

- noindex — запрещена индексация содержимого;

- nofollow — запрещена индексация ссылок;

- follow — разрешена индексация ссылок;

- index — разрешена индексация;

- all — разрешена индексация содержимого и ссылок.

На такой странице ссылки будут индексироваться, а текст — нет. Используйте для разных случаев сочетания значений.

На такой странице ссылки будут индексироваться, а текст — нет. Используйте для разных случаев сочетания значений. Если закрыть сайт от индексации через мета-теги, создавать robots.txt отдельно не нужно.

Какие встречаются ошибки

Логические — когда правила противоречат друг другу. Выявляйте логические ошибки через проверку файла robots.txt в инструментах Яндекс.Вебмастере и Google Robots Testing Tool.

Синтаксические — когда неправильно записаны правила в файле.

К наиболее часто встречаемым относятся:

- запись без учета регистра;

- запись заглавными буквами;

- перечисление всех правил в одной строке;

- отсутствие пустой строки между правилами;

- указание краулера в директиве;

- перечисление множества вместо закрытия целого раздела или папки;

- отсутствие обязательной директивы disallow.

Шпаргалка

-

Для запрета на индексацию сайта используйте два варианта. Создайте файл robots.txt и укажите запрет через директиву disallow для всех краулеров. Другой вариант — пропишите запрет через мета-тег robots в файле index.html внутри тега .

-

Закрывайте служебные информацию, устаревающие данные, скрипты, сессии и utm-метки. Для каждого запрета создавайте отдельное правило. Запрещайте всем поисковым роботам через * или указывайте название конкретного краулера. Если вы хотите разрешить только одному роботу, прописывайте правило через disallow.

-

При создании файла robots.txt избегайте логических и синтаксических ошибок. Проверяйте файл через инструменты Яндекс.

Вебмастер и Google Robots Testing Tool.

Вебмастер и Google Robots Testing Tool.

Материал подготовила Светлана Сирвида-Льорентэ.

Что такое robots.txt [Основы для новичков]

Успешная индексация нового сайта зависит от многих слагаемых. Один из них — файл robots.txt, с правильным заполнением которого должен быть знаком любой начинающий веб-мастер. Обновили материал для новичков.

Подробно о правилах составления файла в полном руководстве «Как составить robots.txt самостоятельно».

А в этом материале основы для начинающих, которые хотят быть в курсе профессиональных терминов.

Что такое robots.txt

Файл robots.txt — это документ в формате .txt, содержащий инструкции по индексации конкретного сайта для поисковых ботов. Он указывает поисковикам, какие страницы веб-ресурса стоит проиндексировать, а какие не нужно допустить к индексации.

Поисковый робот, придя к вам на сайт, первым делом пытается отыскать robots.txt. Если робот не нашел файл или он составлен неправильно, бот будет изучать сайт по своему собственному усмотрению. Далеко не факт, что он начнет с тех страниц, которые нужно вводить в поиск в первую очередь (новые статьи, обзоры, фотоотчеты и так далее). Индексация нового сайта может затянуться. Поэтому веб-мастеру нужно вовремя позаботиться о создании правильного файла robots.txt.

На некоторых конструкторах сайтов файл формируется сам. Например, Wix автоматически создает robots.txt. Чтобы посмотреть файл, добавьте к домену «/robots.txt». Если вы увидите там странные элементы типа «noflashhtml» и «backhtml», не пугайтесь: они относятся к структуре сайтов на платформе и не влияют на отношение поисковых систем.

Зачем нужен robots.txt

Казалось бы, зачем запрещать индексировать какое-то содержимое сайта? Далеко не весь контент, из которого состоит сайт, нужен поисковым роботам. Есть системные файлы, есть дубликаты страниц, есть рубрики ключевых слов и много чего еще есть, что вовсе не обязательно индексировать. Есть одно но:

Есть системные файлы, есть дубликаты страниц, есть рубрики ключевых слов и много чего еще есть, что вовсе не обязательно индексировать. Есть одно но:

Содержимое файла robots.txt — это рекомендации для ботов, а не жесткие правила. Рекомендации боты могут проигнорировать.

Google предупреждает, что через robots.txt нельзя заблокировать страницы для показа в Google. Даже если вы закроете доступ к странице в robots.txt, если на какой-то другой странице будет ссылка на эту, она может попасть в индекс. Лучше использовать и ограничения в robots, и другие методы запрета:

Запрет индексирования сайта, Яндекс

Блокировка индексирования, Google

Тем не менее, без robots.txt больше вероятность, что информация, которая должна быть скрыта, попадет в выдачу, а это бывает чревато раскрытием персональных данных и другими проблемами.

Из чего состоит robots.txt

Файл должен называться только «robots.txt» строчными буквами и никак иначе. Его размещают в корневом каталоге — https://site.com/robots.txt в единственном экземпляре. В ответ на запрос он должен отдавать HTTP-код со статусом 200 ОК. Вес файла не должен превышать 32 КБ. Это максимум, который будет воспринимать Яндекс, для Google robots может весить до 500 КБ.

Его размещают в корневом каталоге — https://site.com/robots.txt в единственном экземпляре. В ответ на запрос он должен отдавать HTTP-код со статусом 200 ОК. Вес файла не должен превышать 32 КБ. Это максимум, который будет воспринимать Яндекс, для Google robots может весить до 500 КБ.

Внутри все должно быть на латинице, все русские названия нужно перевести с помощью любого Punycode-конвертера. Каждый префикс URL нужно писать на отдельной строке.

В robots.txt с помощью специальных терминов прописываются директивы (команды или инструкции). Кратко о директивах для поисковых ботах:

«Us-agent:» — основная директива robots.txt

Используется для конкретизации поискового робота, которому будут давать указания. Например, User-agent: Googlebot или User-agent: Yandex.

В файле robots.txt можно обратиться ко всем остальным поисковым системам сразу. Команда в этом случае будет выглядеть так: User-agent: *. Под специальным символом «*» принято понимать «любой текст».

После основной директивы «User-agent:» следуют конкретные команды.

Команда «Disallow:» — запрет индексации в robots.txt

При помощи этой команды поисковому роботу можно запретить индексировать веб-ресурс целиком или какую-то его часть. Все зависит от того, какое расширение у нее будет.

User-agent: Yandex Disallow: /

Такого рода запись в файле robots.txt означает, что поисковому роботу Яндекса вообще не позволено индексировать данный сайт, так как запрещающий знак «/» не сопровождается какими-то уточнениями.

User-agent: Yandex Disallow: /wp-admin

На этот раз уточнения имеются и касаются они системной папки wp-admin в CMS WordPress. То есть индексирующему роботу рекомендовано отказаться от индексации всей этой папки.

Команда «Allow:» — разрешение индексации в robots.txt

Антипод предыдущей директивы. При помощи тех же самых уточняющих элементов, но используя данную команду в файле robots. txt, можно разрешить индексирующему роботу вносить нужные вам элементы сайта в поисковую базу.

txt, можно разрешить индексирующему роботу вносить нужные вам элементы сайта в поисковую базу.

User-agent: * Allow: /catalog Disallow: /

Разрешено сканировать все, что начинается с «/catalog», а все остальное запрещено.

На практике «Allow:» используется не так уж и часто. В ней нет надобности, поскольку она применяется автоматически. В robots «разрешено все, что не запрещено». Владельцу сайта достаточно воспользоваться директивой «Disallow:», запретив к индексации какое-то содержимое, а весь остальной контент ресурса воспринимается поисковым роботом как доступный для индексации.

Директива «Sitemap:» — указание на карту сайта

«Sitemap:» указывает индексирующему роботу правильный путь к так Карте сайта — файлам sitemap.xml и sitemap.xml.gz в случае с CMS WordPress.

User-agent: * Sitemap: http://pr-cy.ru/sitemap.xml Sitemap: http://pr-cy.ru/sitemap.xml.gz

Прописывание команды в файле robots.txt поможет поисковому роботу быстрее проиндексировать Карту сайта. Это ускорит процесс попадания страниц ресурса в выдачу.

Файл robots.txt готов — что дальше

Итак, вы создали текстовый документ robots.txt с учетом особенностей вашего сайта. Его можно сделать автоматически, к примеру, с помощью нашего инструмента.

Что делать дальше:

- проверить корректность созданного документа, например, посредством сервиса Яндекса;

- при помощи FTP-клиента закачать готовый файл в корневую папку своего сайта. В ситуации с WordPress речь обычно идет о системной папке Public_html.

Дальше остается только ждать, когда появятся поисковые роботы, изучат ваш robots.txt, а после возьмутся за индексацию вашего сайта.

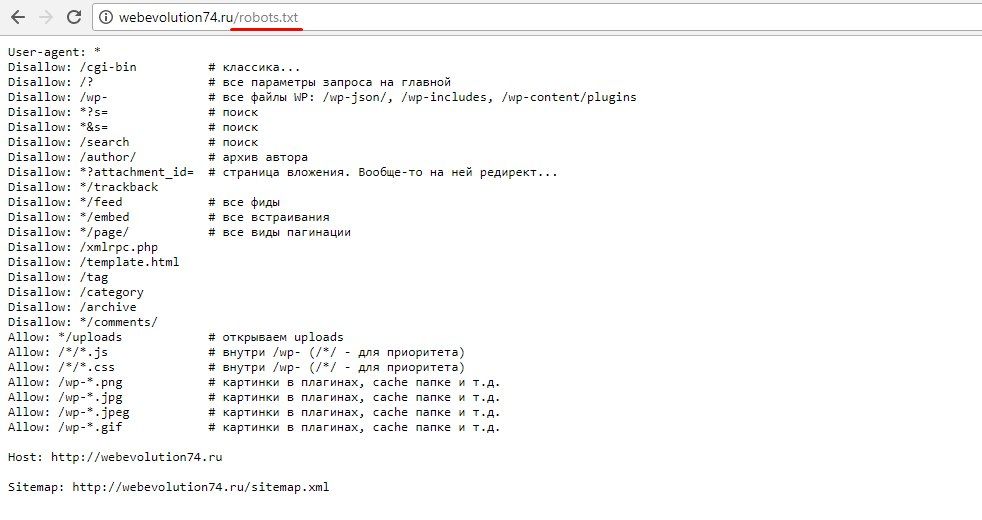

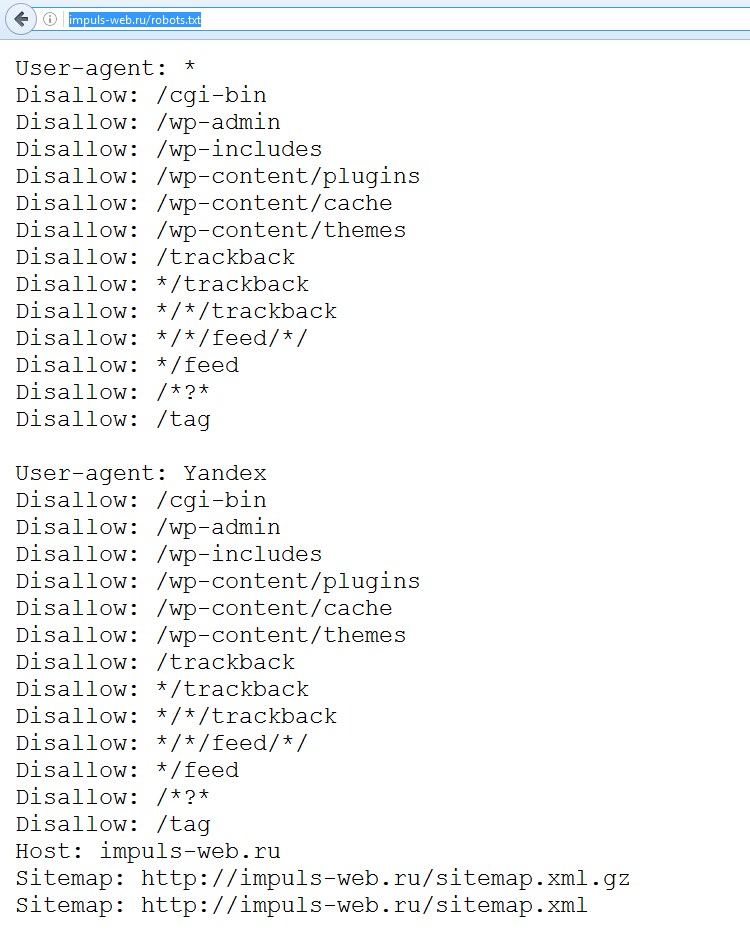

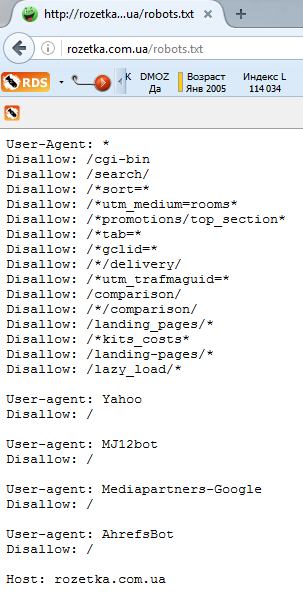

Как посмотреть robots.txt чужого сайта

Если вам интересно сперва посмотреть на готовые примеры файла robots.txt в исполнении других, то нет ничего проще. Для этого в адресной строке браузера достаточно ввести site.ru/robots.txt. Вместо «site.ru» — название интересующего вас ресурса.

Для этого в адресной строке браузера достаточно ввести site.ru/robots.txt. Вместо «site.ru» — название интересующего вас ресурса.

Все о файле «robots.txt» по-русски — как составить robots.txt

Файл robots.txt

Все поисковые роботы при заходе на сайт в первую очередь ищут файл robots.txt. Если вы – вебмастер, вы должны знать назначение и синтаксис robots.txt.

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции для поисковых роботов. Эти инструкции могут запрещать к индексации некоторые разделы или страницы на сайте, указывать на правильное «зеркалирование» домена, рекомендовать поисковому роботу соблюдать определенный временной интервал между скачиванием документов с сервера и т.д.

Создание robots.txt

Файл с указанным расширением – простой текстовый документ. Он создается с помощью обычного блокнота, программ Notepad или Sublime, а также любого другого редактора текстов. Важно, что в его названии должен быть нижний регистр букв – robots.txt.

Важно, что в его названии должен быть нижний регистр букв – robots.txt.

Также существует ограничение по количеству символов и, соответственно, размеру. Например, в Google максимальный вес установлен как 500 кб, а у Yandex – 32 кб. В случае их превышения корректность работы может быть нарушена.

Создается документ в кодировке UTF-8, и его действие распространяется на протоколы HTTP, HTTPS, FTP.

При написании содержимого файла запрещается использование кириллицы. Если есть необходимость применения кириллических доменов, необходимо прибегать к помощи Punycode. Кодировка адресов отдельных страниц должна происходить в соответствии с кодировкой структуры сайта, которая была применена.

После того как файл создан, его следует запустить в корневой каталог. При этом используется FTP-клиент, проверяется возможность доступа по ссылке https://site.com./robots.txt и полнота отображения данных.

Важно помнить, что для каждого поддомена сайта оформляется свой файл с ограничениями.

Описание robots.txt

Чтобы правильно написать robots.txt, предлагаем вам изучить разделы этого сайта. Здесь собрана самая полезная информация о синтаксисе robots.txt, о формате robots.txt, примеры использования, а также описание основных поисковых роботов Рунета.

- Как работать с robots.txt — узнайте, что вы можете сделать, чтобы управлять роботами, которые посещают ваш веб-сайт.

- Роботы Рунета — разделы по роботам поисковых систем, популярных на просторах Рунета.

- Частые ошибки в robots.txt — список наиболее частых ошибок, допускаемых при написании файла robots.txt.

- ЧаВо по веб-роботам — часто задаваемые вопросы о роботах от пользователей, авторов и разработчиков.

- Ссылки по теме — аналог оригинального раздела «WWW Robots Related Sites», но дополненый и расширенный, в основном по русскоязычной тематике.

Где размещать файл robots.

txt

txtРобот просто запрашивает на вашем сайте URL «/robots.txt», сайт в данном случае – это определенный хост на определенном порту.

На сайте может быть только один файл «/robots.txt». Например, не следует помещать файл robots.txt в пользовательские поддиректории – все равно роботы не будут их там искать. Если вы хотите иметь возможность создавать файлы robots.txt в поддиректориях, то вам нужен способ программно собирать их в один файл robots.txt, расположенный в корне сайта. Вместо этого можно использовать Мета-тег Robots.

Не забывайте, что URL-ы чувствительны к регистру, и название файла «/robots.txt» должно быть написано полностью в нижнем регистре.

Как видите, файл robots.txt нужно класть исключительно в корень сайта.

Что писать в файл robots.txt

В файл robots.txt обычно пишут нечто вроде:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

В этом примере запрещена индексация трех директорий.

Затметьте, что каждая директория указана на отдельной строке – нельзя написать «Disallow: /cgi-bin/ /tmp/». Нельзя также разбивать одну инструкцию Disallow или User-agent на несколько строк, т.к. перенос строки используется для отделения инструкций друг от друга.

Регулярные выражения и символы подстановки так же нельзя использовать. «Звездочка» (*) в инструкции User-agent означает «любой робот». Инструкции вида «Disallow: *.gif» или «User-agent: Ya*» не поддерживаются.

Конкретные инструкции в robots.txt зависят от вашего сайта и того, что вы захотите закрыть от индексации. Вот несколько примеров:

Запретить весь сайт для индексации всеми роботами

User-agent: *

Disallow: /

Разрешить всем роботам индексировать весь сайт

User-agent: *

Disallow:

Или можете просто создать пустой файл «/robots.txt».

Закрыть от индексации только несколько каталогов

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /private/

Запретить индексацию сайта только для одного робота

User-agent: BadBot

Disallow: /

Разрешить индексацию сайта одному роботу и запретить всем остальным

User-agent: Yandex

Disallow:

User-agent: *

Disallow: /

Запретить к индексации все файлы кроме одного

Это довольно непросто, т. к. не существует инструкции “Allow”. Вместо этого можно переместить все файлы кроме того, который вы хотите разрешить к индексации в поддиректорию и запретить ее индексацию:

к. не существует инструкции “Allow”. Вместо этого можно переместить все файлы кроме того, который вы хотите разрешить к индексации в поддиректорию и запретить ее индексацию:

User-agent: *

Disallow: /docs/

Либо вы можете запретить все запрещенные к индексации файлы:

User-agent: *

Disallow: /private.html

Disallow: /foo.html

Disallow: /bar.html

Инфографика

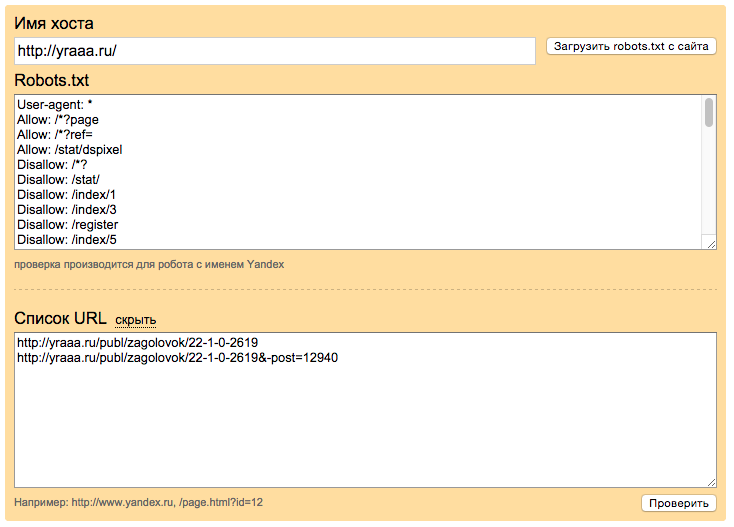

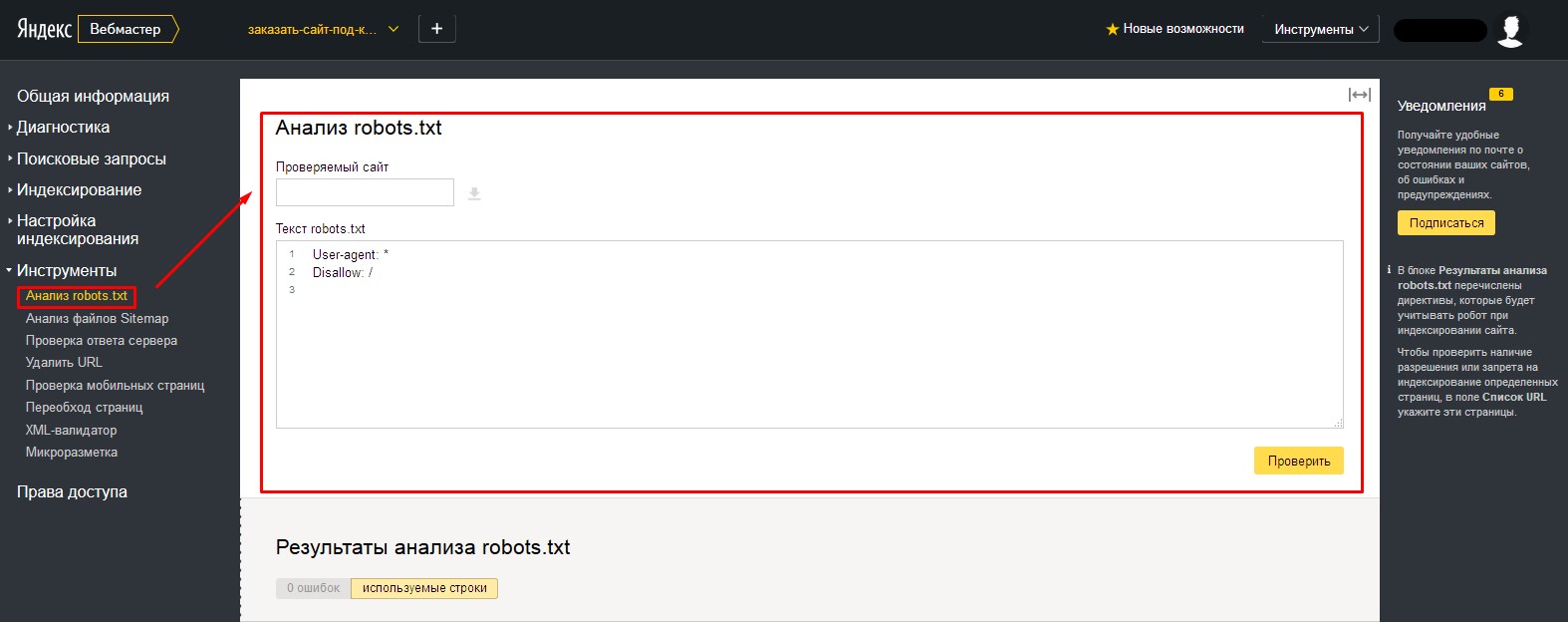

Проверка

Оценить правильность созданного документа robots.txt можно с помощью специальных проверочных ресурсов:

- Анализ robots.txt. – при работе с Yandex.

- robots.txt Tester – для Google.

Важно помнить, что неправильно созданный или прописанный документ может являться угрозой для посещаемости и ранжирования сайта.

О сайте

Этот сайт — некоммерческий проект. Значительная часть материалов — это переводы www.robotstxt.org, другая часть — оригинальные статьи. Мы не хотим ограничиваться только robots.txt, поэтому в некоторых статьях описаны альтернативные методы «ограничения» роботов.

Мы не хотим ограничиваться только robots.txt, поэтому в некоторых статьях описаны альтернативные методы «ограничения» роботов.

robots txt: что это такое за файл и как использовать его

1. Введение

Технические аспекты созданного сайта играют не менее важную роль для продвижения сайта в поисковых системах, чем его наполнение. Одним из наиболее важных технических аспектов является индексирование сайта, т. е. определение областей сайта (файлов и директорий), которые могут или не могут быть проиндексированы роботами поисковых систем. Для этих целей используется robots.txt – это специальный файл, который содержит команды для роботов поисковиков. Правильный файл robots.txt для Яндекса и Google поможет избежать многих неприятных последствий, связанных с индексацией сайта.

2. Понятие файла robots.txt и требования, предъявляемые к нему

Файл /robots.txt предназначен для указания всем поисковым роботам (spiders) индексировать информационные сервера так, как определено в этом файле, т. е. только те директории и файлы сервера, которые не описаны в /robots.txt. Этот файл должен содержать 0 или более записей, которые связаны с тем или иным роботом (что определяется значением поля agent_id) и указывают для каждого робота или для всех сразу, что именно им не надо индексировать.

е. только те директории и файлы сервера, которые не описаны в /robots.txt. Этот файл должен содержать 0 или более записей, которые связаны с тем или иным роботом (что определяется значением поля agent_id) и указывают для каждого робота или для всех сразу, что именно им не надо индексировать.

Синтаксис файла позволяет задавать запретные области индексирования, как для всех, так и для определенных, роботов.

К файлу robots.txt предъявляются специальные требования, не выполнение которых может привести к неправильному считыванию роботом поисковой системы или вообще к недееспособности данного файла.

Основные требования:

- все буквы в названии файла должны быть прописными, т. е. должны иметь нижний регистр:

- robots.txt – правильно,

- Robots.txt или ROBOTS.TXT – неправильно;

- файл robots.txt должен создаваться в текстовом формате Unix. При копировании данного файла на сайт ftp-клиент должен быть настроен на текстовый режим обмена файлами;

- файл robots.

txt должен быть размещен в корневом каталоге сайта.

txt должен быть размещен в корневом каталоге сайта.

3. Содержимое файла robots.txt

Файл robots.txt включает в себя две записи: «User-agent» и «Disallow». Названия данных записей не чувствительны к регистру букв.

Некоторые поисковые системы поддерживают еще и дополнительные записи. Так, например, поисковая система «Yandex» использует запись «Host» для определения основного зеркала сайта (основное зеркало сайта – это сайт, находящийся в индексе поисковых систем).

Каждая запись имеет свое предназначение и может встречаться несколько раз, в зависимости от количества закрываемых от индексации страниц или (и) директорий и количества роботов, к которым Вы обращаетесь.

Предполагается следующий формат строк файла robots.txt:

имя_записи[необязательные

пробелы]:[необязательные

пробелы]значение[необязательные пробелы]

Чтобы файл robots.txt считался верным, необходимо, чтобы, как минимум, одна директива «Disallow» присутствовала после каждой записи «User-agent».

Полностью пустой файл robots.txt эквивалентен его отсутствию, что предполагает разрешение на индексирование всего сайта.

Запись «User-agent»

Запись «User-agent» должна содержать название поискового робота. В данной записи можно указать каждому конкретному роботу, какие страницы сайта индексировать, а какие нет.

Пример записи «User-agent», где обращение происходит ко всем поисковым системам без исключений и используется символ «*»:

User-agent: *

Пример записи «User-agent», где обращение происходит только к роботу поисковой системы Rambler:

User-agent: StackRambler

Робот каждой поисковой системы имеет свое название. Существует два основных способа узнать его (название):

на сайтах многих поисковых систем присутствует специализированный§ раздел «помощь веб-мастеру», в котором часто указывается название поискового робота;

при просмотре логов веб-сервера, а именно при просмотре обращений к§ файлу robots.txt, можно увидеть множество имен, в которых присутствуют названия поисковых систем или их часть. Поэтому Вам остается лишь выбрать нужное имя и вписать его в файл robots.txt.

Поэтому Вам остается лишь выбрать нужное имя и вписать его в файл robots.txt.

Запись «Disallow»

Запись «Disallow» должна содержать предписания, которые указывают поисковому роботу из записи «User-agent», какие файлы или (и) каталоги индексировать запрещено.

Рассмотрим различные примеры записи «Disallow».

Пример записи в robots.txt (разрешить все для индексации):

Disallow:

Пример (сайт полностью запрещен к индексации. Для этого используется символ «/»):Disallow: /

Пример (для индексирования запрещен файл «page.htm», находящийся в корневом каталоге и файл «page2.htm», располагающийся в директории «dir»):

Disallow: /page.htm

Disallow: /dir/page2.htm

Пример (для индексирования запрещены директории «cgi-bin» и «forum» и, следовательно, все содержимое данной директории):

Disallow: /cgi-bin/

Disallow: /forum/

Возможно закрытие от индексирования ряда документов и (или) директорий, начинающихся с одних и тех же символов, используя только одну запись «Disallow». Для этого необходимо прописать начальные одинаковые символы без закрывающей наклонной черты.

Для этого необходимо прописать начальные одинаковые символы без закрывающей наклонной черты.

Пример (для индексирования запрещены директория «dir», а так же все файлы и директории, начинающиеся буквами «dir», т. е. файлы: «dir.htm», «direct.htm», директории: «dir», «directory1», «directory2» и т. д.):

Запись «Allow»

Опция «Allow» используется для обозначения исключений из неиндексируемых директорий и страниц, которые заданы записью «Disallow».

Например, есть запись следующего вида:

Disallow: /forum/

Но при этом нужно, чтобы в директории /forum/ индексировалась страница page1. Тогда в файле robots.txt потребуются следующие строки:

Disallow: /forum/

Allow: /forum/page1

Запись «Sitemap»

Эта запись указывает на расположение карты сайта в формате xml, которая используется поисковыми роботами. Эта запись указывает путь к данному файлу.

Пример:

Sitemap: http://site.ru/sitemap.xml

Запись «Host»

Запись «host» используется поисковой системой «Yandex». Она необходима для определения основного зеркала сайта, т. е. если сайт имеет зеркала (зеркало – это частичная или полная копия сайта. Наличие дубликатов ресурса бывает необходимо владельцам высокопосещаемых сайтов для повышения надежности и доступности их сервиса), то с помощью директивы «Host» можно выбрать то имя, под которым Вы хотите быть проиндексированы. В противном случае «Yandex» выберет главное зеркало самостоятельно, а остальные имена будут запрещены к индексации.

Она необходима для определения основного зеркала сайта, т. е. если сайт имеет зеркала (зеркало – это частичная или полная копия сайта. Наличие дубликатов ресурса бывает необходимо владельцам высокопосещаемых сайтов для повышения надежности и доступности их сервиса), то с помощью директивы «Host» можно выбрать то имя, под которым Вы хотите быть проиндексированы. В противном случае «Yandex» выберет главное зеркало самостоятельно, а остальные имена будут запрещены к индексации.

В целях совместимости с поисковыми роботами, которые при обработке файла robots.txt не воспринимают директиву Host, необходимо добавлять запись «Host» непосредственно после записей Disallow.

Пример: www.site.ru – основное зеркало:

Host: www.site.ru

Запись «Crawl-delay»

Эту запись воспринимает Яндекс. Она является командой для робота делать промежутки заданного времени (в секундах) между индексацией страниц. Иногда это бывает нужно для защиты сайта от перегрузок.

Так, запись следующего вида обозначает, что роботу Яндекса нужно переходить с одной страницы на другую не раньше чем через 3 секунды:

Crawl-delay: 3

Комментарии

Любая строка в robots. txt, начинающаяся с символа «#», считается комментарием. Разрешено использовать комментарии в конце строк с директивами, но некоторые роботы могут неправильно распознать данную строку.

txt, начинающаяся с символа «#», считается комментарием. Разрешено использовать комментарии в конце строк с директивами, но некоторые роботы могут неправильно распознать данную строку.

Пример (комментарий находится на одной строке вместе с директивой):

Disallow: /cgi-bin/ #комментарий

Желательно размещать комментарий на отдельной строке. Пробел в начале строки разрешается, но не рекомендуется.

4. Примеры файлов robots.txt

Пример (комментарий находится на отдельной строке):

Disallow: /cgi-bin/#комментарий

Пример файла robots.txt, разрешающего всем роботам индексирование всего сайта:

User-agent: *

Disallow:

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование сайта:

User-agent: *

Disallow: /

Host: www.site.ru

Пример файла robots.txt, запрещающего всем роботам индексирование директории «abc», а так же всех директорий и файлов, начинающихся с символов «abc».

User-agent: *

Disallow: /abc

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование страницы «page.htm», находящейся в корневом каталоге сайта, поисковым роботом «googlebot»:

User-agent: googlebot

Disallow: /page.htm

Host: www.site.ru

Пример файла robots.txt, запрещающего индексирование:

– роботу «googlebot» – страницы «page1.htm», находящейся в директории «directory»;

– роботу «Yandex» – все директории и страницы, начинающиеся символами «dir» (/dir/, /direct/, dir.htm, direction.htm, и т. д.) и находящиеся в корневом каталоге сайта.

User-agent: googlebot

Disallow: /directory/page1.htm

User-agent: Yandex

Disallow: /dir

Host: www.site.ru

5. Ошибки, связанные с файлом robots.txt

Одна из самых распространенных ошибок – перевернутый синтаксис.

Неправильно:

User-agent: /

Disallow: Yandex

Правильно:

User-agent: Yandex

Disallow: /

Неправильно:

User-agent: *

Disallow: /dir/ /cgi-bin/ /forum/

Правильно:

User-agent: *

Disallow: /dir/

Disallow: /cgi-bin/

Disallow: /forum/

Если при обработке ошибки 404 (документ не найден), веб-сервер выдает специальную страницу, и при этом файл robots. txt отсутствует, то возможна ситуация, когда поисковому роботу при запросе файла robots.txt выдается та самая специальная страница, никак не являющаяся файлом управления индексирования.

txt отсутствует, то возможна ситуация, когда поисковому роботу при запросе файла robots.txt выдается та самая специальная страница, никак не являющаяся файлом управления индексирования.

Ошибка, связанная с неправильным использованием регистра в файле robots.txt. Например, если необходимо закрыть директорию «cgi-bin», то в записе «Disallow» нельзя писать название директории в верхнем регистре «cgi-bin».

Неправильно:

User-agent: *

Disallow: /CGI-BIN/

Правильно:

User-agent: *

Disallow: /cgi-bin/

Ошибка, связанная с отсутствием открывающей наклонной черты при закрытии директории от индексирования.

Неправильно:

User-agent: *

Disallow: dir

User-agent: *

Disallow: page.HTML

Правильно:

User-agent: *

Disallow: /dir

User-agent: *

Disallow: /page.HTML

Чтобы избежать наиболее распространенных ошибок, файл robots.txt можно проверить средствами Яндекс. Вебмастера или Инструментами для вебмастеров Google. Проверка осуществляется после загрузки файла.

Вебмастера или Инструментами для вебмастеров Google. Проверка осуществляется после загрузки файла.

6. Заключение

Таким образом, наличие файла robots.txt, а так же его составление, может повлиять на продвижение сайта в поисковых системах. Не зная синтаксиса файла robots.txt, можно запретить к индексированию возможные продвигаемые страницы, а так же весь сайт. И, наоборот, грамотное составление данного файла может очень помочь в продвижении ресурса, например, можно закрыть от индексирования документы, которые мешают продвижению нужных страниц.

Robots.txt — инструкция для SEO

Файл robots.txt предоставляет важную информацию для поисковых роботов, которые сканируют интернет. Перед тем как пройтись по страницам вашего сайта, поисковые роботы проверяют данный файл.

Это позволят им с большей эффективностью сканировать сайт, так как вы помогаете роботам сразу приступать к индексации действительно важной информации на вашем сайте (это при условии, что вы правильно настроили robots. txt).

txt).

Но, как директивы в robots.txt, так и инструкция noindex в мета-теге robots являются лишь рекомендацией для роботов, поэтому они не гарантируют что закрытые страницы не будут проиндексированы и не будут добавлены в индекс.

Если вам нужно действительно закрыть часть сайта от индексации, то, например, можно дополнительно воспользоваться закрытие директорий паролем.

Основной синтаксисUser-Agent: робот для которого будут применяться следующие правила (например, «Googlebot»)

Disallow: страницы, к которым вы хотите закрыть доступ (можно указать большой список таких директив с каждой новой строки)

Каждая группа User-Agent / Disallow должны быть разделены пустой строкой. Но, не пустые строки не должны существовать в рамках группы (между User-Agent и последней директивой Disallow).

Символ хэш (#) может быть использован для комментариев в файле robots. txt: для текущей строки всё что после # будет игнорироваться. Данные комментарий может быть использован как для всей строки, так в конце строки после директив.

txt: для текущей строки всё что после # будет игнорироваться. Данные комментарий может быть использован как для всей строки, так в конце строки после директив.

Каталоги и имена файлов чувствительны к регистру: «catalog», «Catalog» и «CATALOG» – это всё разные директории для поисковых систем.

Host: применяется для указание Яндексу основного зеркала сайта. Поэтому, если вы хотите склеить 2 сайта и делаете постраничный 301 редирект, то для файла robots.txt (на дублирующем сайте) НЕ надо делать редирект, чтобы Яндекс мог видеть данную директиву именно на сайте, который необходимо склеить.

Crawl-delay: можно ограничить скорость обхода вашего сайта, так как если у вашего сайта очень большая посещаемость, то, нагрузка на сервер от различных поисковых роботов может приводить к дополнительным проблемам.

Регулярные выражения: для более гибкой настройки своих директив вы можете использовать 2 символа

- * (звездочка) – означает любую последовательность символов

- $ (знак доллара) – обозначает конец строки

txt

txtЗапрет на индексацию всего сайта

User-agent: *

Disallow: /

Эту инструкцию важно использовать, когда вы разрабатываете новый сайт и выкладываете доступ к нему, например, через поддомен.

Очень часто разработчики забывают таким образом закрыть от индексации сайт и получаем сразу полную копию сайта в индексе поисковых систем. Если это всё-таки произошло, то надо сделать постраничный 301 редирект на ваш основной домен.

А такая конструкция ПОЗВОЛЯЕТ индексировать весь сайт:

User-agent: *

Disallow:

Запрет на индексацию определённой папки

User-agent: Googlebot

Disallow: /no-index/

Запрет на посещение страницы для определенного робота

User-agent: Googlebot

Disallow: /no-index/this-page.html

Запрет на индексацию файлов определенного типа

User-agent: *

Disallow: /*.pdf$

Разрешить определенному поисковому роботу посещать определенную страницу

User-agent: *

Disallow: /no-bots/block-all-bots-except-rogerbot-page. html

html

User-agent: Yandex

Allow: /no-bots/block-all-bots-except-Yandex-page.html

Ссылка на Sitemap

User-agent: *

Disallow:

Sitemap: http://www.example.com/none-standard-location/sitemap.xml

Нюансы с использованием данной директивы: если у вас на сайте постоянно добавляется уникальный контент, то

- лучше НЕ добавлять в robots.txt ссылку на вашу карту сайта,

- саму карту сайта сделать с НЕСТАНДАРТНЫМ названием sitemap.xml (например, my-new-sitemap.xml и после этого добавить эту ссылку через «вебмастерсы» поисковых систем),

так как, очень много недобросовестных вебмастеров парсят с чужих сайтов контент и используют для своих проектов.

Что лучше использовать robots.txt или noindex?Статья в тему: Создаем sitemap для Google и Яндекс

Если вы хотите, чтобы страница не попала в индекс, то лучше использовать noindex в мета-теге robots. Для этого на странице в секции <head> необходимо добавить следующий метатег:

<meta name=”robots” content=”noindex, follow”>.

Это позволит вам

- убрать из индекса страницу при следующем посещение поискового робота (и не надо будет делать в ручном режиме удаление данной страницы, через вебмастерс)

- позволит вам передать ссылочный вес страницы

Через robots.txt лучше всего закрывать от индексации:

- админку сайта

- результаты поиска по сайту

- страницы регистрации/авторизации/восстановление пароля

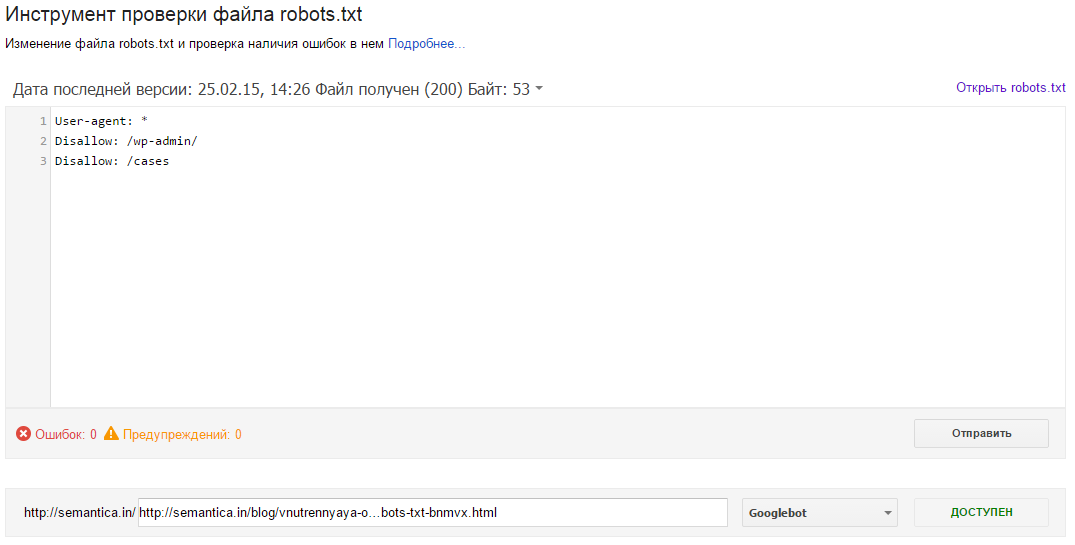

После того, как вы окончательно сформировали файл robots.txt необходимо проверить его на ошибки. Для этого можно воспользоваться инструментами проверки от поисковых систем:

Google Вебмастерс: войти в аккаунт с подтверждённым в нём текущим сайтом, перейти на Сканирование -> Инструмент проверки файла robots.txt.

В данном инструменте вы можете:

- сразу увидеть все свои ошибки и возможные проблемы,

- прямо в этом инструменте провести все правки и сразу проверить на ошибки, чтобы потом уже перенести готовый файл себе на сайт,

- проверить правильно ли вы закрыли все не нужные для индексации страницы и открыты ли все нужные страницы.

Яндекс Вебмастер: чтобы воспользоваться данным инструментом просто перейдите по этой ссылке http://webmaster.yandex.ru/robots.xml.

Этот инструмент почти аналогичный предыдущему с тем небольшим отличием, что:

- тут можно не авторизоваться и нет необходимости в подтверждении прав на сайт, а поэтому, можно сразу приступать к проверке вашего файла robots.txt,

- для проверки сразу можно задать список страниц, а не вбивать их по одному,

- точно убедиться, что Яндекс правильно понял ваши инструкции.

Создание и настройка robots.txt является в списке первых пунктов по внутренней оптимизации сайта и началом поискового продвижения.

Важно его настроить грамотно, чтобы нужные страницы и разделы были доступны к индексации поисковых систем. А не нужные были закрыты.

Но главное помнить, что robots.txt не гарантирует того, что страницы не будут проиндексированы. Как когда-то сказала наша коллега Анастасия Пареха:

Robots.

txt — как презерватив, вроде защищает, но вероятность всегда есть)

Хорошие статьи в продолжение:

— 301 редирект – самое полное руководство

— Пагинация для SEO – пошаговое руководство

— Ответы сервера – практичная методичка

А что вы думаете про настройку robots.txt на сайте?

Оцените статью

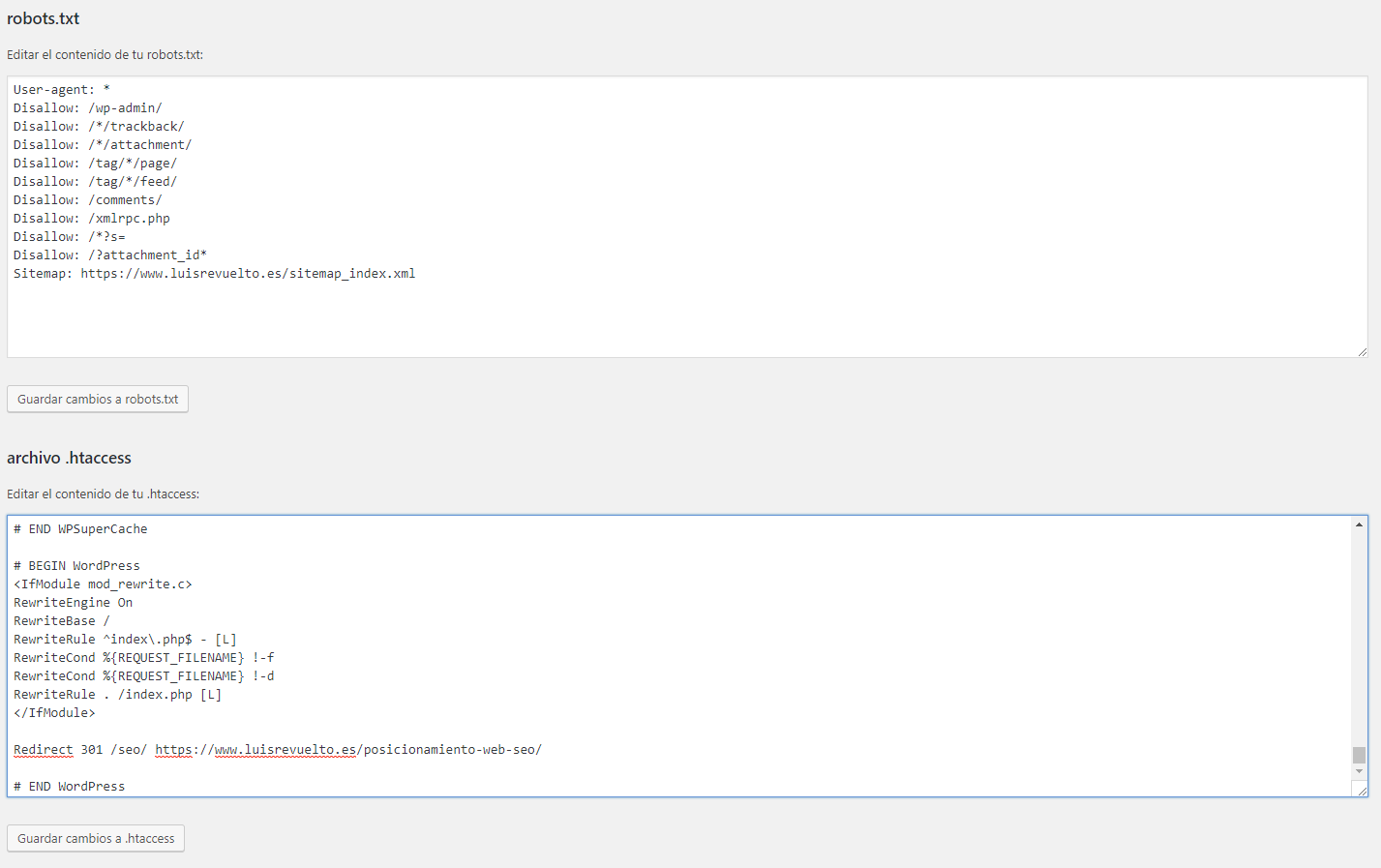

Загрузка…Управление robots.txt

Общие правила

Данная вкладка служит для указания общих правил для индексирования сайта поисковыми системами. В поле отображается текущий набор инструкций. Любая из инструкций (кроме User-Agent: *) может быть удалена, если навести на нее курсор мыши и нажать на «крестик». Для генерации инструкций необходимо воспользоваться кнопками, расположенными рядом с полем.

| Кнопка | Описание |

|---|---|

| Стартовый набор | Позволяет задать набор стандартных правил и ограничений (закрываются от индексации административные страницы, личные данные пользователя, отладочная информация).

Если часть стандартного набора уже задана, то будут добавлены только необходимые отсутствующие инструкции. |

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно. |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами. |

| Интервал между запросами (Crawl-delay) | Служит для указания минимального временного интервала (в сек.) между запросами поискового робота. |

| Карта сайта | Позволяет задать ссылку к файлу карты сайта sitemap.xml. |

Яндекс

Настройка правил и ограничений для роботов Яндекса. Настройку можно выполнить как сразу для всех роботов Яндекса (вкладка «Yandex»), так и каждого в отдельности (на вкладке с соответствующим названием робота). Внешний вид вкладок одинаков и содержит следующий набор кнопок для генерации инструкций:

| Кнопка | Описание |

|---|---|

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно.  |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами.

Важно! Для каждого файла robots.txt обрабатывается только одна директива Host. |

| Интервал между запросами (Crawl-delay) | Служит для указания минимального временного интервала (в сек.) между запросами поискового робота. |

Настройка правил и ограничений для роботов Google. Настройка выполняется для каждого робота в отдельности (на вкладке с соответствующим названием робота). Внешний вид вкладок одинаков и содержит следующий набор кнопок для генерации инструкций:

Внешний вид вкладок одинаков и содержит следующий набор кнопок для генерации инструкций:

| Кнопка | Описание |

|---|---|

| Запретить файл/папку (Disallow) | Позволяет составить инструкции, запрещающие индексировать файлы и папки по маске пути.

При нажатии на кнопку открывается форма со списком уже имеющихся инструкций запрета индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые индексировать не нужно. |

| Разрешить файл/папку (Allow) | Позволяет указать файлы и папки, разрешенные для индексации.

При нажатии на кнопку открывается форма со списком путей к файлам и папкам, разрешенных для индексации. В открывшейся форме кнопка […] позволяет выбрать файлы или папки, которые должны быть проиндексированы. |

| Главное зеркало (Host) | Позволяет задать адрес главного зеркала сайта. Главное зеркало необходимо обязательно указывать, если сайт обладает несколькими зеркалами.

Важно! Для каждого файла robots.txt обрабатывается только одна директива Host. |

Редактировать

На данной вкладке представлено текстовое поле, в котором можно вручную отредактировать содержимое файла robots.txt.

Смотрите также

© «Битрикс», 2001-2021, «1С-Битрикс», 2021

Наверх

Robots.txt Введение и руководство | Центр поиска Google

Что такое файл robots.txt?

Файл robots.txt сообщает сканерам поисковых систем, какие страницы или файлы он может или

не могу запросить с вашего сайта. Это используется в основном для того, чтобы избежать перегрузки вашего сайта

Запросы; , это не механизм для защиты веб-страницы от Google. Чтобы веб-страница не попала в Google, вы должны использовать

Чтобы веб-страница не попала в Google, вы должны использовать директив noindex ,

или защитите свою страницу паролем.

Для чего используется robots.txt?

Файлrobots.txt используется в основном для управления трафиком сканера на ваш сайт, а обычно для защиты страницы от Google, в зависимости от типа файла:

| Тип страницы | Управление движением | Скрыть от Google | Описание |

|---|---|---|---|

| Интернет-страница | Для веб-страниц (HTML, PDF или другие немедийные форматы, которые может читать Google), robots.txt можно использовать для управления обходным трафиком, если вы считаете, что ваш сервер будет перегружен запросами от поискового робота Google, или чтобы избежать сканирования неважных или похожих страниц на вашем сайте. Вы не должны использовать robots.txt как средство, чтобы скрыть свои веб-страницы от результатов поиска Google. Это связано с тем, что, если другие страницы указывают на вашу страницу с описательным текстом, ваша страница все равно может быть проиндексирована без посещения страницы. Если вы хотите заблокировать свою страницу из результатов поиска, используйте другой метод, например защиту паролем или директиву Если ваша веб-страница заблокирована файлом robots.txt , она все равно может отображаться в результатах поиска, но результат поиска не будет иметь описания и будет выглядеть примерно так. Файлы изображений, видеофайлы, PDF-файлы и другие файлы, отличные от HTML, будут исключены. Если вы видите этот результат поиска для своей страницы и хотите его исправить, удалите запись robots.txt, блокирующую страницу. Если вы хотите полностью скрыть страницу от поиска, воспользуйтесь другим методом. | ||

| Медиа-файл | Используйте роботов.txt для управления трафиком сканирования, а также для предотвращения появления изображений, видео и аудио файлов в результатах поиска Google. (Обратите внимание, что это не помешает другим страницам или пользователям ссылаться на ваш файл изображения / видео / аудио.) | ||

| Файл ресурсов | Вы можете использовать robots.txt для блокировки файлов ресурсов, таких как неважные изображения, скрипты или файлы стилей, , если вы считаете, что страницы, загруженные без этих ресурсов, не пострадают от потери .Однако, если отсутствие этих ресурсов затрудняет понимание страницы поисковым роботом Google, вы не должны блокировать их, иначе Google не сможет хорошо проанализировать страницы, которые зависят от этих ресурсов. |

Пользуюсь услугами хостинга сайтов

Если вы используете службу хостинга веб-сайтов, такую как Wix, Drupal или Blogger, вам может не потребоваться (или у вас будет возможность) напрямую редактировать файл robots. txt. Вместо этого ваш провайдер может открыть страницу настроек поиска или какой-либо другой механизм, чтобы сообщить поисковым системам, сканировать ли вашу страницу или нет.

txt. Вместо этого ваш провайдер может открыть страницу настроек поиска или какой-либо другой механизм, чтобы сообщить поисковым системам, сканировать ли вашу страницу или нет.

Чтобы узнать, просканировала ли ваша страница Google, найдите URL-адрес страницы в Google.

Если вы хотите скрыть (или показать) свою страницу от поисковых систем, добавьте (или удалите) любые требования для входа на страницу, которые могут существовать, и выполните поиск инструкций по изменению видимости вашей страницы в поисковых системах на вашем хостинге, например: wix скрыть страницу от поисковых систем

Узнайте об ограничениях robots.txt

Прежде чем создавать или редактировать robots.txt, вы должны знать ограничения этого метода блокировки URL.Иногда вам может потребоваться рассмотреть другие механизмы, чтобы гарантировать, что ваши URL-адреса не будут найдены в Интернете.

- Директивы Robots.txt могут поддерживаться не всеми поисковыми системами.

Инструкции в файлахrobots.txtне могут принудить сканер к вашему сайту, он должен им подчиняться. В то время как робот Googlebot и другие уважаемые веб-сканеры подчиняются инструкциям из файлаrobots.txt, другие сканеры могут этого не делать. Поэтому, если вы хотите защитить информацию от веб-сканеров, лучше использовать другие методы блокировки, такие как защита паролем личных файлов на вашем сервере. - Разные сканеры по-разному интерпретируют синтаксис

Хотя уважаемые веб-сканеры следуют директивам в файле robots.txt, каждый сканер может интерпретировать директивы по-разному. Вы должны знать правильный синтаксис для обращения к различным поисковым роботам, поскольку некоторые из них могут не понимать определенные инструкции. - Роботизированная страница все еще может быть проиндексирована, если на нее есть ссылки с других сайтов

В то время как Google не будет сканировать и индексировать контент, заблокированныйrobots., мы все равно можем найти и проиндексировать запрещенный URL, если на него есть ссылки из других мест в Интернете. В результате URL-адрес и, возможно, другая общедоступная информация, такая как текст привязки в ссылках на страницу, может по-прежнему отображаться в результатах поиска Google. Чтобы правильно предотвратить появление вашего URL в результатах поиска Google, вы должны защитить паролем файлы на своем сервере или использовать метатег noindex или заголовок ответа (или полностью удалить страницу). txt

txt

Тестирование страницы на наличие роботов.txt блоки

Вы можете проверить, заблокирована ли страница или ресурс правилом robots.txt.

Для проверки директив noindex используйте инструмент проверки URL.

Создайте файл robots.txt | Центр поиска Google | Разработчики Google

Если вы пользуетесь услугами хостинга сайтов, например Wix или Blogger, вам может не понадобиться создавать или редактировать файл robots. txt.

txt.Начало работы

Файл robots.txt находится в корне вашего сайта. Итак, для сайта www.example.com, файл robots.txt находится по адресу www.example.com/robots.txt. robots.txt - это простой текстовый файл, соответствующий Стандарту исключения для роботов. Файл robots.txt состоит из одного или нескольких правил. Каждое правило блокирует (или разрешает) доступ для данного сканера к указанному пути к файлу на этом веб-сайте.

Вот простой файл robots.txt с двумя правилами, описанными ниже:

# Группа 1 Пользовательский агент: Googlebot Запретить: / nogooglebot / # Группа 2 Пользовательский агент: * Позволять: / Карта сайта: http: //www.example.ru / sitemap.xml

Пояснение:

- Пользовательский агент с именем "робот Googlebot" не должен сканировать папку

http://example.com/nogooglebot/или любые ее подкаталоги. - Все остальные пользовательские агенты могут получить доступ ко всему сайту.

(Его можно было бы опустить, и результат был бы таким же, поскольку предполагается полный доступ.)

(Его можно было бы опустить, и результат был бы таким же, поскольку предполагается полный доступ.) - Файл Sitemap сайта находится по адресу http://www.example.com/sitemap.xml

Мы предоставим более подробный пример позже.

Основные правила robots.txt

Вот несколько основных рекомендаций для файлов robots.txt. Мы рекомендуем вам прочитать полный синтаксис файлов robots.txt, потому что синтаксис robots.txt имеет некоторые тонкие особенности, которые вы должны понять.

Формат и расположение

Для создания файла robots.txt можно использовать практически любой текстовый редактор. Текстовый редактор должен уметь создавать стандартные текстовые файлы UTF-8. Не используйте текстовый процессор; текстовые процессоры часто сохраняют файлы в проприетарном формате и могут добавлять неожиданные символы, такие как фигурные кавычки, что может вызвать проблемы для поисковых роботов.

Правила формата и расположения:

- Файл должен называться robots.txt

- На вашем сайте может быть только один файл robots.txt.

- Файл robots.txt должен находиться в корне хоста веб-сайта, к которому он применяется. Например, для управления сканированием всех URL ниже

http: // www.example.com/, файл robots.txt должен находиться по адресуhttp://www.example.com/robots.txt. Это не может быть помещенным в подкаталог (например,http://example.com/pages/robots.txt). Если вы не знаете, как получить доступ к корню вашего веб-сайта или вам нужны разрешения для этого, обратитесь к поставщику услуг веб-хостинга. Если вы не можете получить доступ к корню своего веб-сайта, используйте альтернативный метод блокировки, например метатеги.

Если вы не можете получить доступ к корню своего веб-сайта, используйте альтернативный метод блокировки, например метатеги. - Файл robots.txt может применяться к поддоменам (например,

http: // , веб-сайт .example.com/robots.txt) или на нестандартных портах (например,http://example.com: 8181 /robots.txt). - Комментарии - это любое содержимое после знака #.

Синтаксис

- robots.txt должен быть текстовым файлом в кодировке UTF-8 (включая ASCII). Использование других наборов символов невозможно.

- Файл robots.txt состоит из одной или нескольких группы .

- Каждая группа состоит из нескольких правил или директив (инструкций), по одной директиве на строку.

- Группа предоставляет следующую информацию:

- Кому относится группа (пользовательский агент )

- К каким каталогам или файлам может обращаться агент и / или

- Какие каталоги или файлы не может получить агент .

- Группы обрабатываются сверху вниз, и пользовательский агент может соответствовать только одному набору правил, который является первым, наиболее конкретным правилом, которое соответствует данному пользовательскому агенту.

- Предположение по умолчанию состоит в том, что пользовательский агент может сканировать любую страницу или каталог, не заблокированные правилом

Disallow:. - Правила чувствительны к регистру . Например,

Disallow: /file.aspприменяется кhttp://www.example.com/file.asp, но неhttp://www.example.com/FILE.asp.

В файлах robots.txt используются следующие директивы:

-

Агент пользователя:[ Обязательно, один или несколько на группу ] Имя поисковой системы , робот (программное обеспечение веб-краулера), к которому применяется правило. Это первая строка любого правила. Большинство имен пользовательских агентов Google перечислены в базе данных веб-роботов или в списке пользовательских агентов Google. Поддерживает подстановочный знак

Это первая строка любого правила. Большинство имен пользовательских агентов Google перечислены в базе данных веб-роботов или в списке пользовательских агентов Google. Поддерживает подстановочный знак *для префикса пути, суффикса или всей строки. Использование звездочки (*), как в примере ниже, будет соответствовать всем поисковым роботам , кроме различных поисковых роботов AdsBot , которые должны иметь явное имя. (См. Список имен сканеров Google.) Примеры:# Пример 1. Блокировать только Googlebot Пользовательский агент: Googlebot Запретить: / # Пример 2. Блокировка роботов Google и Adsbot Пользовательский агент: Googlebot Пользовательский агент: AdsBot-Google Запретить: / # Пример 3. Блокировка всех сканеров, кроме AdsBot Пользовательский агент: * Disallow: /

-

Disallow:[ По крайней мере один или несколькоDisallowилиAllowзаписей на правило ] Каталог или страница относительно корневого домена, которые не должны сканироваться пользовательским агентом. Если страница, это должно быть полное имя страницы, как показано в браузере; если каталог, он должен заканчиваться отметкой

Если страница, это должно быть полное имя страницы, как показано в браузере; если каталог, он должен заканчиваться отметкой /. Поддерживает подстановочный знак*для префикса пути, суффикса или всей строки. -

Разрешить:[ По крайней мере один или несколькоЗапретитьилиРазрешитьзаписей на правило ] Каталог или страница относительно корневого домена, которые должен сканировать только что упомянутый пользовательский агент. Это используется для переопределения директивыDisallow, чтобы разрешить сканирование подкаталога или страницы в запрещенном каталоге.Если страница, это должно быть полное имя страницы, как показано в браузере; если каталог, он должен заканчиваться отметкой/. Поддерживает подстановочный знак

Поддерживает подстановочный знак *для префикса пути, суффикса или всей строки. -

Sitemap:[ Необязательно, ноль или более на файл ] Местоположение карты сайта для этого веб-сайта. Должен быть полностью определенный URL; Google не предполагает и не проверяет альтернативы http / https / www.non-www. Файлы Sitemap - хороший способ указать, какой контент Google должен сканировать , а не какой контент может сканировать или не может сканировать .Узнайте больше о файлах Sitemap. Пример:Карта сайта: https://example.com/sitemap.xml Карта сайта: http://www.example.com/sitemap.xml

Остальные правила игнорируются.

Другой пример файла

Файл robots.txt состоит из одной или нескольких групп, каждая из которых начинается со строки User-agent , в которой указывается цель групп. Вот файл с двумя группами; встроенные комментарии объясняют каждую группу:

Вот файл с двумя группами; встроенные комментарии объясняют каждую группу:

# Заблокируйте googlebot из примера.com / directory1 / ... и example.com/directory2 / ... # но разрешить доступ к directory2 / subdirectory1 / ... # Все остальные каталоги на сайте разрешены по умолчанию. Пользовательский агент: googlebot Запретить: / directory1 / Запретить: / каталог2 / Разрешить: / directory2 / subdirectory1 / # Блокировать весь сайт от другого сканера. Пользовательский агент: anothercrawler Запретить: /

Полный синтаксис robots.txt

Полный синтаксис robots.txt можно найти здесь. Пожалуйста, прочтите полную документацию, так как синтаксис robots.txt имеет несколько сложных частей, которые важно изучить.

Полезные правила robots.txt

Вот несколько общих полезных правил robots.txt:

| Правило | Образец |

|---|---|

Запретить сканирование всего веб-сайта. Имейте в виду, что в некоторых ситуациях URL-адреса с веб-сайта все еще могут индексироваться, даже если они не сканировались. Примечание. Это не относится к различным сканерам AdsBot, которые должны иметь явное имя. Имейте в виду, что в некоторых ситуациях URL-адреса с веб-сайта все еще могут индексироваться, даже если они не сканировались. Примечание. Это не относится к различным сканерам AdsBot, которые должны иметь явное имя. | Пользовательский агент: * Запретить: / |

| Запретить сканирование каталога и его содержимого , поставив после имени каталога косую черту.Помните, что вам не следует использовать robots.txt для блокировки доступа к личному контенту: вместо этого используйте правильную аутентификацию. URL-адреса, запрещенные файлом robots.txt, могут по-прежнему индексироваться без сканирования, а файл robots.txt может быть просмотрен кем угодно, потенциально раскрывая местонахождение вашего личного содержания. | Пользовательский агент: * Запретить: / календарь / Запретить: / junk / |

| Разрешить доступ одному сканеру | User-agent: Googlebot-news Позволять: / Пользовательский агент: * Запретить: / |

| Разрешить доступ всем, кроме одного поискового робота | User-agent: Ненужный бот Запретить: / Пользовательский агент: * Позволять: / |

Запретить сканирование отдельной веб-страницы , указав страницу после косой черты: | Пользовательский агент: * Запретить: / частный_файл. |

Заблокировать определенное изображение из Картинок Google: | Пользовательский агент: Googlebot-Image Запретить: /images/dogs.jpg |

Заблокировать все изображения на вашем сайте из Картинок Google: | Пользовательский агент: Googlebot-Image Disallow: / |

Запретить сканирование файлов определенного типа (например, | Пользовательский агент: Googlebot Disallow: /*.gif$ |

Запретить сканирование всего сайта, но показать рекламу AdSense на этих страницах , запретить все веб-сканеры, кроме | Пользовательский агент: * Запретить: / Пользовательский агент: Mediapartners-Google Разрешить: / |