- Что такое индексация сайта, как ее проверить и как ускорить

- Сколько сайт индексируется по времени. Как быстро сайт появляется в поиске

- Индексация сайта — что это такое, определение в маркетинге на ROMI center

- Что это такое

- Как проходит индексация сайта

- Как происходит автоматическая проверка

- Проверка уровня индексации вашего сайта в поисковых системах

- Сколько времени индексируется новый сайт

- Как проверить количество страниц в индексе

- Что значит переиндексация сайта

- Как проверить сайт на запрет индексации

- Как открыть сайт для индексации, скрыв отдельные страницы

- Как запретить индексацию сайта полностью

- Индексация Яндекс и Google: что важно учесть

- Как ускорить индексацию

- Как ускорить индексацию сайта в Яндексе и Google

- Что такое индексация сайта поисковыми системами?

- Для чего необходимо ускорить индексацию сайта в Яндексе и Google

- Особенности ускоренной индексации сайтов поисковыми системами

- Способы и советы по ускорению индексации сайта

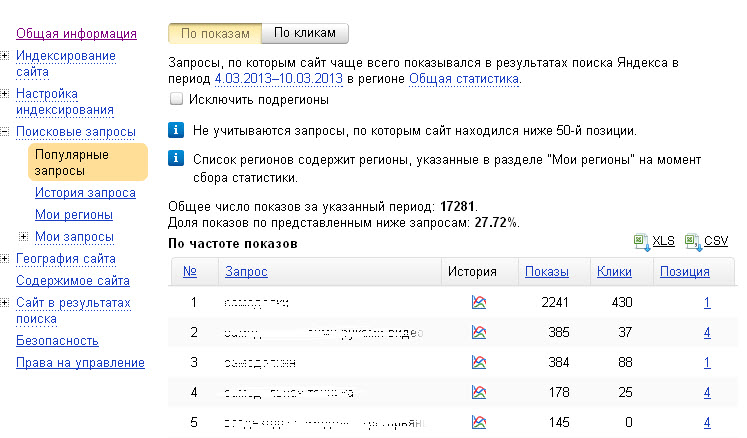

- Регистрация в панелях для Вебмастеров поисковых систем

- Добавление новой страницы в Аддурилки поисковых систем

- Создание правильного файла robots.txt

- Создание карты сайта в формате sitemap.xml

- Создание карты сайта в формате html

- Качество и частота написания уникального контента для сайта

- Использование социальных сетей

- Размещение внешних ссылок на новые статьи сайта

- Добавление сайта в различные рейтинги

- Перелинковка страниц сайта

- Другие способы ускорения индексации

- Как ускорить индексацию сайта в Яндексе и Google

- что это такое, как происходит, как ускорить и проверить индексацию

- Что такое индексация и как она происходит

- Как быстрее попасть в индекс

- Как проверить индексацию сайта

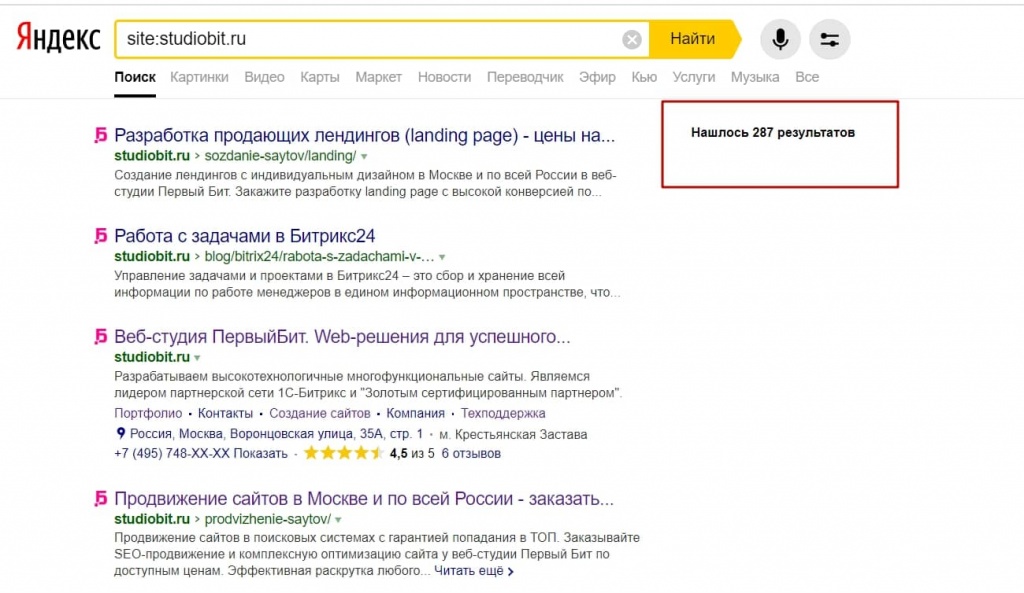

- Например, наберем URL zamkitut.ru для проверки индексации сайта. В результатах поиска будут только проиндексированные страницы заданного сайта, и ничего не придется выбирать вручную.

- Так выглядит рабочее окно Netpeak Spider: программа выдает много дополнительной информации, помимо количества страниц в индексе.

- Почему сайт не индексируется и как это исправить

- Как закрыть сайт от индексации и когда это нужно

- Индексирование сайта. Рассказываем, как добавляться в поисковые системы, и отвечаем на важные вопрос

- Индексирование сайта по тегу Яндекс.Метрики

- Как добавить сайт в поиск?

- Статистика сканирования — Вебмастер. Справка

- Индексирование сайта с помощью Яндекс.Метрика

- Страниц в поиске — Webmaster.Справка

- Скорость сканирования сайта — Вебмастер. Помощь

- Индексирование страниц сайта: как быстро проверить в поисковиках в Go

Что такое индексация сайта, как ее проверить и как ускорить

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц.

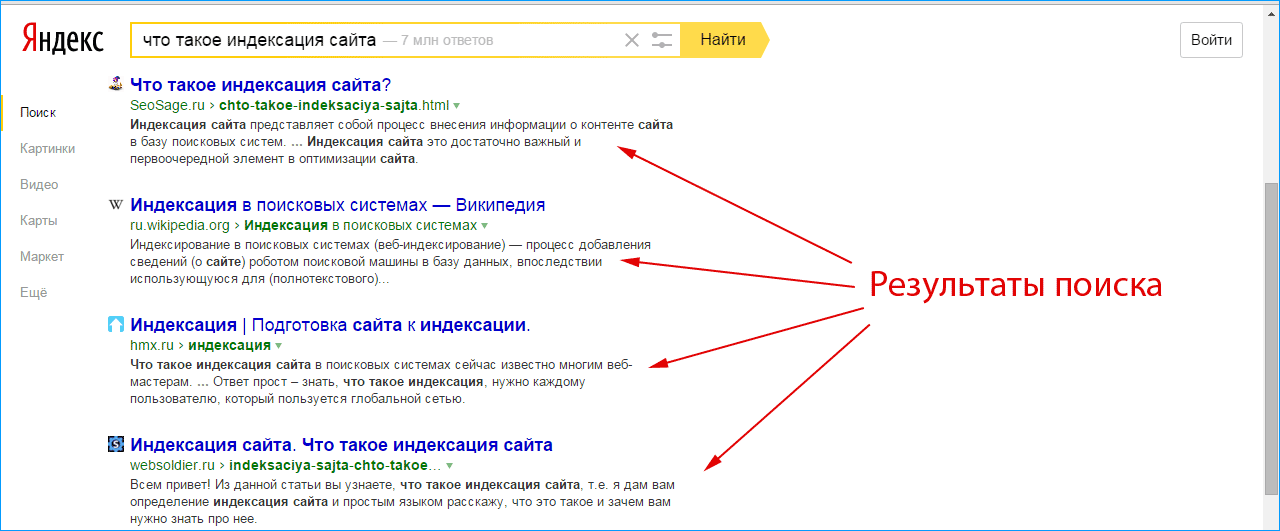

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

-

Поисковые роботы самостоятельно находят и проверяют созданный сайт или его новые страницы. Многие эксперты считают такой вариант самым выгодным, ведь если ПС сами хотят внести ресурс в индекс, то он пользуется популярностью. Значит, приносит пользу. Как роботы определяют полезность страниц: наличие активных внешних ссылок, объемы трафика и вовлеченность посетителей.

- Пользователь принудительно отправляет сайт на индексацию с помощью заполнения формы на сервисе поисковой системы. Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

-

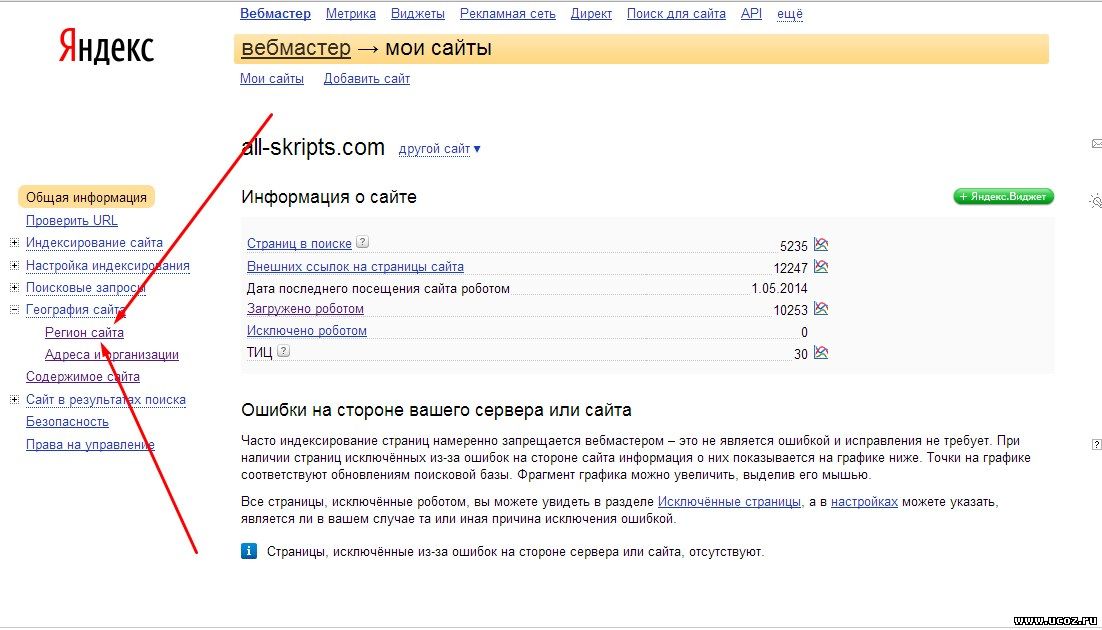

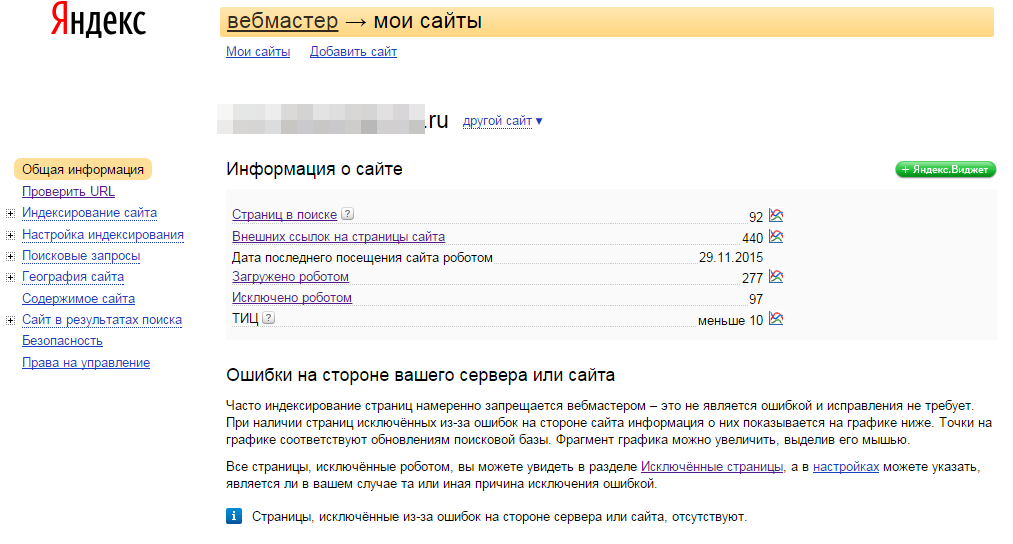

Использовать инструменты вебмастеров, которые предоставляются поисковыми системами бесплатно – это webmaster.yandex.ru или google.com/webmasters. В Гугле откройте Search Console и далее раздел «Индекс Google».

Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца.

Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца. -

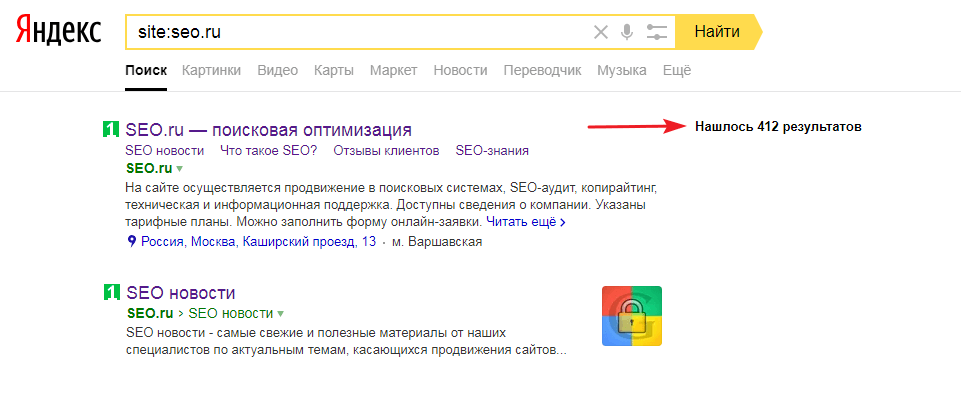

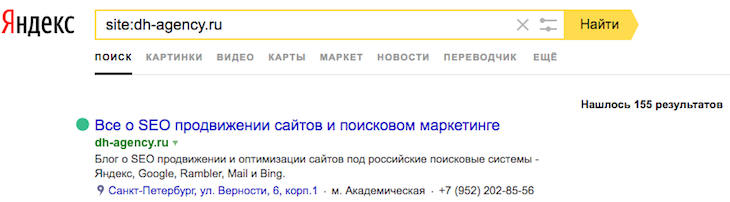

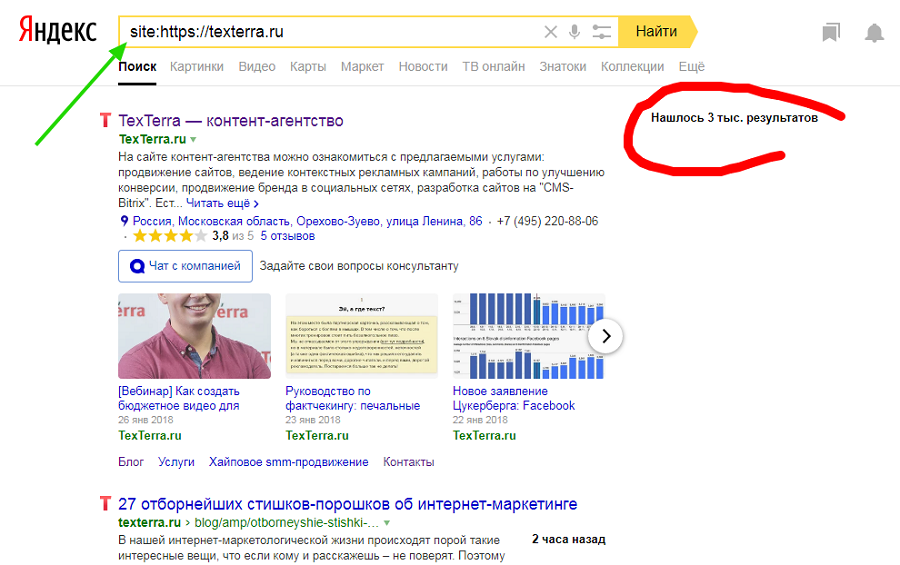

Использовать специальные операторы, которые вводятся в поисковую строку. Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

-

Воспользоваться браузерными плагинами или спецсервисами. Это небольшие дополнения к веб-обозревателю, которые автоматически проверяют наличие страниц в индексе. Популярное решение — RDS Bar.

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

- Авторитетность сайта в сети, полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенность страниц;

- Правильно заполненные файлы sitemap.xml и robots.txt;

- Корректно выставленные ограничения в роботсе.

Для ускорения индексации рекомендуется выполнить следующие действия:

- Подобрать надежный и быстрый хостинг.

- Поставить сайт на индексацию в ПС Яндекса и Гугла.

-

Корректно настроить robots.txt. В файле нужно запретить посещение технических, служебных страниц, просмотр другой информации, не представляющей пользы для посетителей.

- Создать файл карты sitemap.xml и сохранить его в корне сайта. По нему роботы проверяют структуру страниц, а также следят за обновлением контента.

- Проверить код главной и других страниц на наличие ошибок и дублей.

- Проверить текстовое наполнение на количество ключевых слов.

- Регулярно размещать на сайте новый полезный контент. Рекомендуется настроить внутреннюю перелинковку между статьями и страницами. Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче.

- Настроить навигацию, сделать доступ к нужной странице с главного меню не длиннее 3-х кликов. К юзабилити сайтов сегодня предъявляются повышенные требования, так как это напрямую влияет на поведенческие факторы посетителей. Если до нужной информации расстояние в 10-12 кликов, то 90% пользователей покинут такой сайт.

-

Разместить ссылки на ресурс в соцсетях, на тематических форумах, досках объявлений и других площадках генерации трафика.

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

Поставить запрет на сканирование ботами можно несколькими способами:

-

Использовать файл robots.txt. В документе можно запретить индексацию отдельной страницы, так и всего сайта целиком.

Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС.

Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС. - Прописать специальные теги в файле robots.txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: <meta name=»googlebot» content=»noindex, nofollow»/>.

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

Сколько сайт индексируется по времени. Как быстро сайт появляется в поиске

Статья актуальна для версии магазина: 4.0-5.0

На скорость индексирования сайта (внесение страниц сайта в базу поисковых систем) влияют следующие факторы:

- Политика поисковых систем — в настоящее время поисковые системы более строго относятся к новым сайтам, чем 5 или 10 лет назад; сначала сайт должен зарекомендовать себя для поисковиков временем своего существования. При прочих равных условиях, сайт начинает быстрее индексироваться по прошествии 6-12 месяцев с момента создания.

- Внесение сайта в такие сервисы, как Вебмастер.Яндекс и Google Webmaster Tools — если мы сообщим поисковикам о нашем сайте, они как минимум быстрее о нём узнают, а значит — быстрее начнут индексировать.

- Настройка карты сайта (sitemap.

xml) и файла robots.txt — наличие карты сайта позволит поисковому роботу быстрее посетить все страницы сайта, а правильная настройка robots.txt скажет поисковому роботу, какие страницы не нужно индексировать, тем самым сэкономив время для индексации нужных страниц.

xml) и файла robots.txt — наличие карты сайта позволит поисковому роботу быстрее посетить все страницы сайта, а правильная настройка robots.txt скажет поисковому роботу, какие страницы не нужно индексировать, тем самым сэкономив время для индексации нужных страниц. - Уникальный контент — чем лучше, уникальнее и полезнее материалы на сайте (особенно тексты), тем быстрее поисковики распознают в вашем сайте качественный ресурс и начнут быстрее его индексировать.

- Посещаемость — чем быстрее на сайт начнёт идти трафик (из соц. сетей или с рекламы), тем быстрее поисковики начнут его индексировать.

- Ссылки на ваш сайт — чем больше качественных ссылок на ваш сайт стоит с других сайтов — тем быстрее поисковые системы начнут индексировать ваш сайт. Данный пункт мы настоятельно рекомендуем отдать в работу SEO-специалисту.

В среднем, для того, чтобы молодому сайту размером в несколько тысяч страниц проиндексироваться полностью, требуется около 2-4 месяцев.

Другие статьи по теме

Статья оказалась полезной?Благодарим за отзыв.

Как мы можем улучшить статью?

Проблема в

…Не могу закончить настройку, слишком сложная инструкцияСледовал инструкции, но ожидаемого результата не добилсяНедостаточно описаны вспомогательные элементыПохоже что инструкция устарелаТема статьи не раскрытаДругое

Отмена Отправить отзыв

Не нашли нужную статью? Предложить свою тему

Не нашли нужную статью?

Благодарим за отзыв.

Тэги: Индексация, SEO, поисковые системы, Яндекс, Google

Индексация сайта — что это такое, определение в маркетинге на ROMI center

Что это такое

релевантности и распределения контента по разделам. Роботам важно понять, насколько представленная информация ценна для пользователя, который ввёл запрос в поисковую строку. Именно релевантность сайта запросу и позволяет выявить поисковая индексация сайта.

Как настроить свой ресурс для высоких позиций в поисковой выдаче и как проверить все показатели? Обо всём этом расскажем далее.

Как проходит индексация сайта

Как только появилась глобальная Cеть, поисковые системы обзавелись фильтрацией результатов запросов. В те времена и появилась индексация сайта по ключевым словам. Проверка индексации страниц сайта делалась просто — чем больше ключей находил на нем поисковик, тем выше был ресурс в выдаче. Для ускорения индексации сайта и его продвижения на топовые позиции достаточно было добавить туда побольше популярных фраз. Такой метод оценки привёл к тому, что на первых строках результатов поиска появлялись совершенно бесполезные страницы, сплошь и рядом заполненные необходимыми словоформами. И это был текст не для клиентов, а для роботов. Ведь живой человек просто закроет такой «продвинутый» сайт и пойдёт искать ресурс, где информация читабельна и понятна.

Такой метод оценки привёл к тому, что на первых строках результатов поиска появлялись совершенно бесполезные страницы, сплошь и рядом заполненные необходимыми словоформами. И это был текст не для клиентов, а для роботов. Ведь живой человек просто закроет такой «продвинутый» сайт и пойдёт искать ресурс, где информация читабельна и понятна.

С тех пор многое изменилось. Поисковые роботы научились оценивать сайты не только по ключевикам, но и по другим параметрам для получения наиболее релевантных данных и ранжирования в выдаче.

Сегодня процесс индексирования сайта состоит из трех этапов: сканирование, анализ и выдача результатов.

- Сканирование: поисковая система запускает программу, называемую «пауком», для поиска контента в Сети.

- Анализ: поисковая система анализирует найденный контент, чтобы определить, о чем он. Затем упорядочивает его.

- Выдача: когда пользователь вводит запрос, поисковая система делает проверку индексации сайта по ключевым словам.

Затем на основе этого составляется список результатов индексации, который и отображается на странице результатов поиска.

Затем на основе этого составляется список результатов индексации, который и отображается на странице результатов поиска.

Так алгоритмы поисковиков составляют индекс и ищут только нужные страницы.

Алгоритм отвечает за то, как проверить индексацию сайта, и анализирует ряд уникальных характеристик каждой индексируемой веб-страницы. Это помогает поисковикам отображать наиболее релевантные страницы в ответ на запрос пользователя.

Мало кто знает реальные алгоритмы поисковых систем. Основной механизм держится в секрете, иначе работа поисковиков может быть парализована. И в ответ на запрос пользователя будут выдаваться результаты, далекие от того, что человек действительно ищет. Поэтому нет волшебных рецептов, как узнать тонкости индексации сайта и как гарантированно вывести страницы на первые места в выдаче.

Главное, что нужно знать: позиция отображения ресурса зависит исключительно от его качества. Для улучшения индексации большинству русскоязычных сайтов достаточно учесть особенности алгоритмов двух основных поисковиков: Google и Яндекс. Рассмотрим самые распространённые вопросы о прохождении индексации.

Рассмотрим самые распространённые вопросы о прохождении индексации.

Как происходит автоматическая проверка

Индексирование — процесс, с помощью которого поисковый робот обнаруживает новые и обновленные страницы для добавления в индекс. Если робот не может просканировать страницу, то проверить индексацию сайта не получится.

Автоматическая индексация сайта в поисковых системах происходит при помощи механизмов, которые самостоятельно находят ресурс и анализируют его контент, релевантность информации, ссылки, трафик, время визитов пользователей и многое другое. Началу прохождения такой проверки способствует наличие ссылок на сайт на других ресурсах.

Проверка уровня индексации вашего сайта в поисковых системах

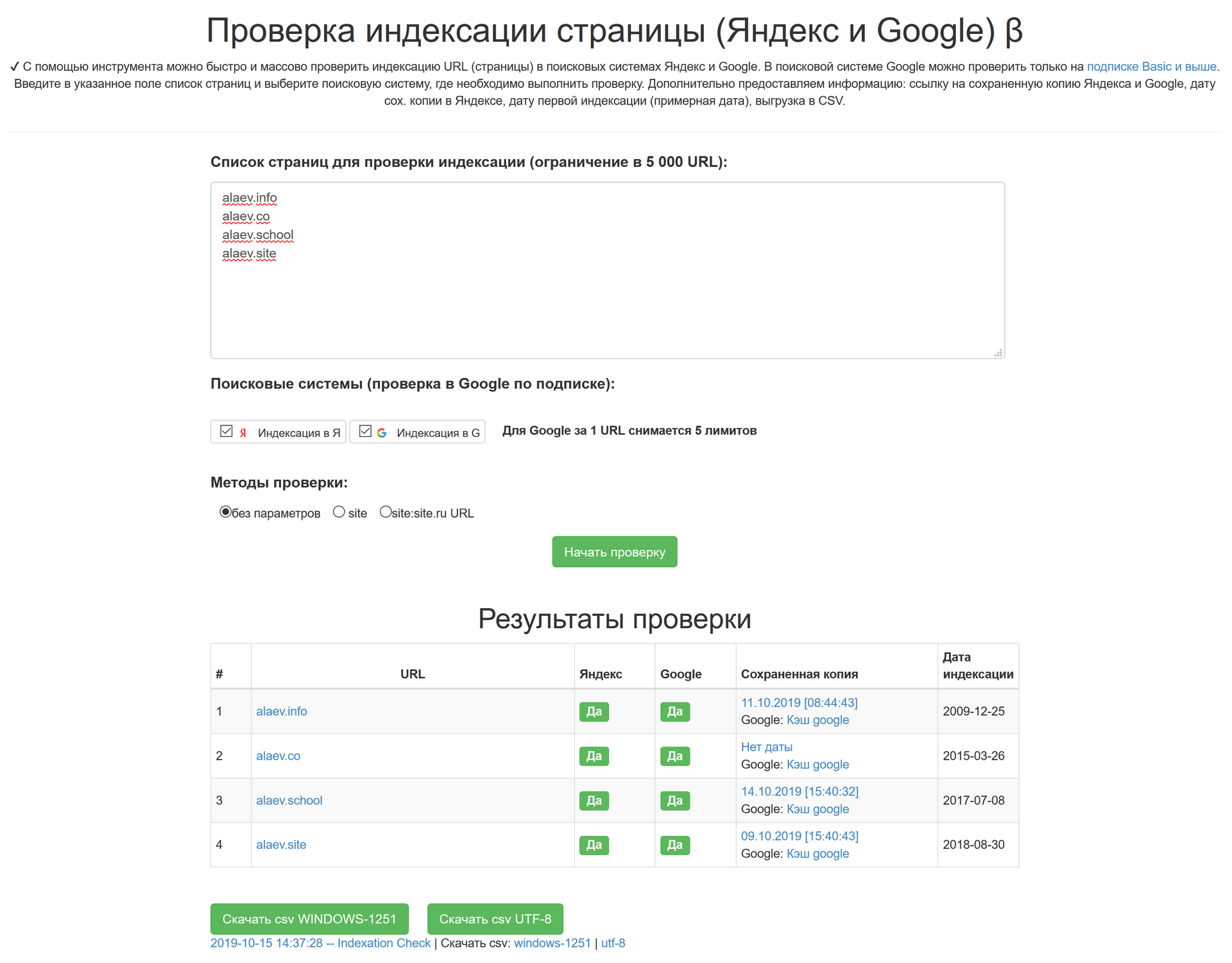

Проверить индексацию страницы можно:

1. При помощи поисковой строки, добавив к домену сайта символы «site:».

2. Специальными сервисами, например RDS Bar или XSEO.in.

Также проверить индексирование сайта можно встроенными инструментами Яндекс. Вебмастер и Google Search Console. Они помогают провести проверку индексации страницы в Яндексе и Гугле в полуавтоматическом режиме.

Вебмастер и Google Search Console. Они помогают провести проверку индексации страницы в Яндексе и Гугле в полуавтоматическом режиме.

- В Google Search Console — это инструмент тестирования URL Inspection Tool. С его помощью можно просмотреть HTML-код целевой страницы и убедиться, что поисковый робот Googlebot может получить доступ к содержанию. Это полезно для тестирования страниц, генерируемых JavaScript, если ваш сайт построен на платформе JS. Инструмент предоставит моментальный снимок того, как отображается страница, и сообщит обо всех ошибках, которые могут отрицательно повлиять на возможность сканирования.

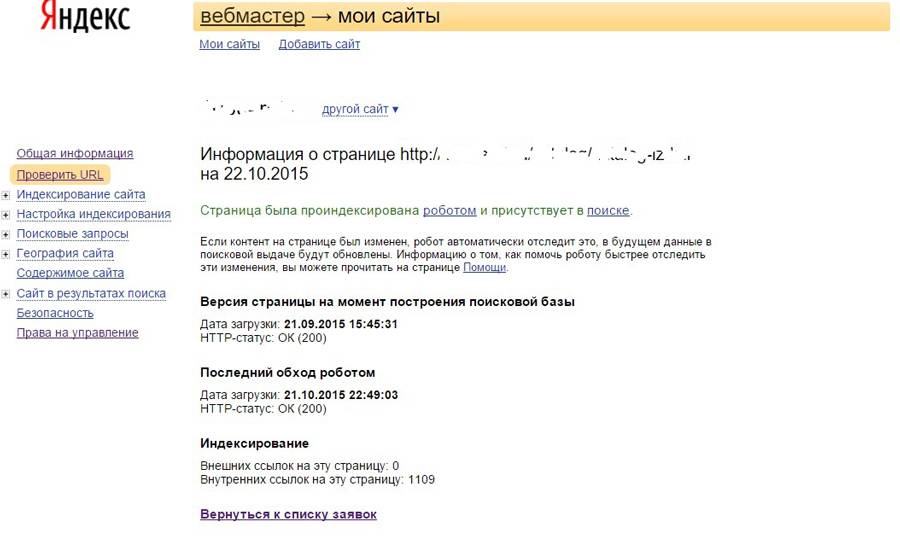

- В Яндекс.Вебмастере есть схожий сервис тестирования «Проверить статус URL». Находится он в меню «Индексирование». Задав нужный сайт, можно увидеть полный отчет по нему — от статуса в поиске до последнего посещения робота.

Сколько времени индексируется новый сайт

Сколько занимает проверка — зависит от поисковой системы. Google является скоростным лидером в данном процессе, управляясь с индексацией примерно за одну неделю. Время индексации в Яндексе может быть больше — до двух-трех недель.

Время индексации в Яндексе может быть больше — до двух-трех недель.

Скорость, с которой поисковик заметит ресурс зависит от множества параметров, поэтому указанные сроки весьма условны. Например, дополнительные страницы уже проиндексированного сайта рассматриваются быстрее.

Как проверить количество страниц в индексе

Чтобы узнать, сколько страниц сайта проиндексировано Яндексом, перейдите по ссылке. Для аналогичного мониторинга в Google необходимо ввести в поисковую строку значение site: домен сайта. Например, site:moisait.ru

Что значит переиндексация сайта

Переиндексация — это повторный анализ страниц, который проводят роботы поисковых систем. Как часто происходит данный процесс? Во многом это зависит от регулярности обновлений. Чем чаще на сайте появляется новая информация, тем с большим вниманием поисковик рассматривает ресурс. О прочих лайфхаках для ускорения индексации поговорим далее.

Как проверить сайт на запрет индексации

При индексации сайта могут возникнуть проблемы, которые требуют оперативного устранения. Это нужно для успешного прохождения проверки и отображения в поиске.

Это нужно для успешного прохождения проверки и отображения в поиске.

Яндекс.Вебмастер и Search Console содержат разделы, в которых можно посмотреть проблемы, найденные на ресурсе. Например, система может сделать запрет на индексацию страниц за нарушение правил безопасности или за отсутствие подтверждённого домена.

Последствия запрета индексации части сайта отразятся на показах этих страниц. Пользователь просто не увидит их, когда введёт в поисковик целевой запрос.

Как открыть сайт для индексации, скрыв отдельные страницы

Однако иногда часть страниц требуется закрыть от индексации преднамеренно, прописав их в файле robots.txt. Вот для каких страниц это может пригодиться:

- Дублированные страницы.

- Страницы, находящиеся в разработке.

- Технические разделы, которые необходимо скрыть.

Во-первых, запретить индексацию специально можно путём указания имени нужного файла или папки в файле robots.txt:

User-agent: *

Disallow: /folder/file. ph

ph

Disallow: /folder/

Системы не смогут проверить noindex и nofollow, поэтому второй вариант скрытия ненужного контента — это указание данных тегов.

Как запретить индексацию сайта полностью

Иногда требуется полностью удалить сайт из базы данных поисковых систем. Для это необходимо прописать в robots.txt значение:

User-agent: *

Disallow: /

Если же сайт не индексируется, когда нужно, стоит в первую очередь проверить этот же файл. Возможно, во время проведения каких-то работ на ресурсе его временно скрыли от посторонних взглядов. И забыли вернуть все как было.

Индексация Яндекс и Google: что важно учесть

Помимо регистрации в Яндекс.Вебмастер и Search Console необходимо проверить карту сайта — sitemap.xml, а также указать необходимые параметры индексации в файле robots.txt.

По регистрации в системах часто встречаются 2 основных вопроса: индексация сайта в Google, как это сделать вручную, и почему Яндекс не индексирует сайт.

Чтобы ускорить процесс проверки, необходимо внести ресурс в сервис Google Search Console. Остальное система сделает сама.

Остальное система сделает сама.

Яндекс сканирует ресурсы медленнее, чем Google. Для получения заветной отметки в базе данных нужно зарегистрироваться в Яндекс.Вебмастер.

Как ускорить индексацию

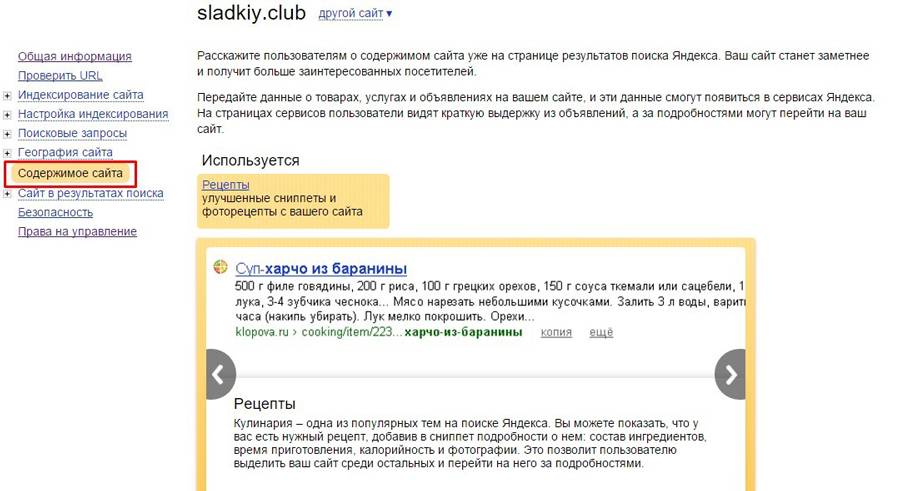

Индексирование сайта — это целый ряд процессов, повлиять на которые возможно, улучшив качество ресурса. Как проверить, достаточно ли хорош сайт с точки зрения поисковых роботов и ускорить индексацию сайта в Яндексе и Гугле? Основные 2 правила: проведите индексацию сайта так, чтобы там был качественный контент, и обеспечьте удобство ресурса для пользователей.

Также возьмите на вооружение ниже перечисленные пункты — применив их на практике, вы обеспечите видимость сайта в поисковых системах.

- Публикуйте новости регулярно, так как поисковые боты ценят частое обновление контента.

- Корректно заполните файл sitemap.xml. Перечислите в нем все страницы сайта, чтобы поисковые системы могли их найти.

- Проверьте файл robots.txt. Там не должно быть блокировок поисковых систем от сканирования страниц сайта, в частности тегов noindex и nofollow.

- Включите внутреннюю перелинковку и добавьте внешние ссылки. Ведь индексация ссылок — краеугольный камень SEO.

- Проверьте сайт на так называемые страницы-«сироты». Если на странице нет никаких внутренних ссылок, это затрудняет ее поиск пользователями и роботами.

- Проведите проверку индексации сайта в Яндекс и Гугл с помощью инструментов для веб-мастеров и устраните все выявленные проблемы.

- Проверьте контент сайта и включите в него ключевые слова, по которым необходимо отображаться.

Отдельным пунктом оптимизации для индексирования стоит выделить дубли. Это наиболее частый источник проблем. Дублированный контент — когда на сайте есть несколько страниц с одинаковым или похожим содержанием, не менее 70% совпадений. Когда поисковые системы обнаруживают такой контент, это создает путаницу в отношении того, какую версию страницы индексировать. В конечном итоге поисковая система выбирает вариант, который, по ее мнению, является лучшим. И отфильтровывает остальные. Таким образом 2 похожие страницы на сайте конкурируют между собой за одни и те же поисковые запросы.

Таким образом 2 похожие страницы на сайте конкурируют между собой за одни и те же поисковые запросы.

Существует несколько способов решения и предотвращения проблем с дублированным контентом. Вот самые распространенные:

- Тег «rel=canonical» в HTML-коде нужной страницы, чтобы показать, какая версия является предпочтительной.

- Редирект 301 на «вторичной» странице, чтобы перенаправить посетителей на предпочтительную версию.

- Только одна версия сайта — с www либо без www в адресе, но не обе сразу. Использование обеих создает дубликат всего веб-сайта.

- Уникальные URL-адреса, поскольку линки с разными регистрами написания считаются повторяющимся содержимым.

Чтобы найти дублированный контент на своем сайте, можно использовать специальные сервисы, например, Siteliner.

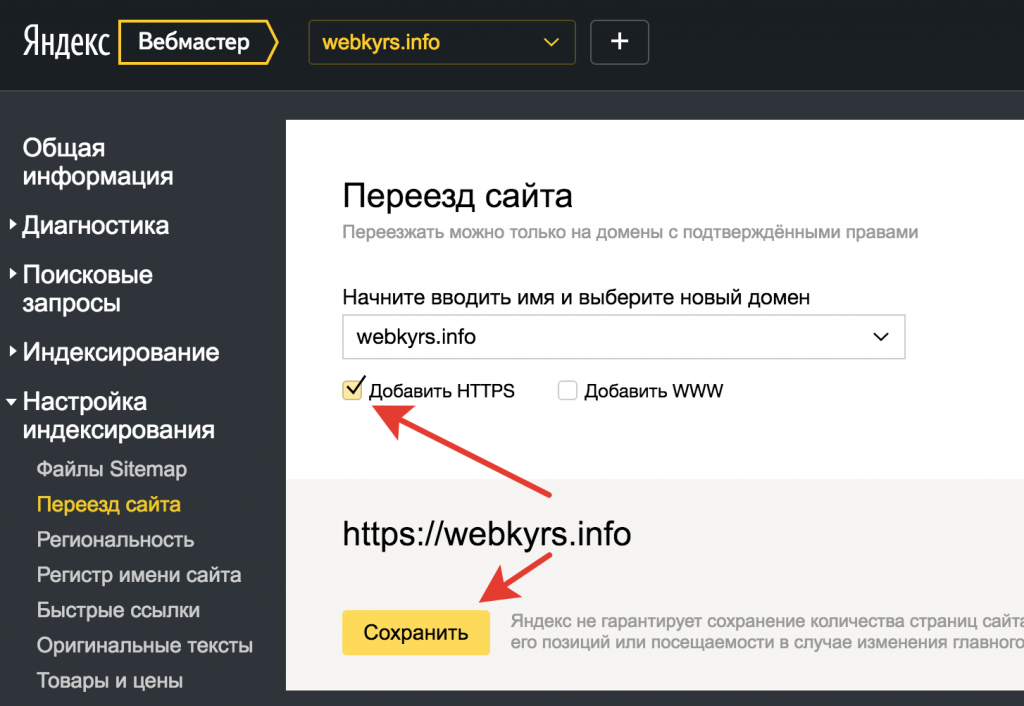

Последнее, на что нужно обратить внимание для ускорения индексации сайта, это протокол передачи данных, который использует сайт. Поисковые системы, особенно Google, стремятся к созданию более безопасного веб-интерфейса для пользователей. Поэтому рекомендуют веб-мастерам использовать шифрование HTTPS вместо привычного протокола передачи данных HTTP. На него можно перейти, установив действующий сертификат безопасности сайта SSL. Для Google это особенно хорошо работает, так как система повышает скорость индексации и рейтинг сайтов, использующих HTTPS. При этом страницы с HTTP помечаются как «небезопасные», чтобы предупреждать пользователей.

Поэтому рекомендуют веб-мастерам использовать шифрование HTTPS вместо привычного протокола передачи данных HTTP. На него можно перейти, установив действующий сертификат безопасности сайта SSL. Для Google это особенно хорошо работает, так как система повышает скорость индексации и рейтинг сайтов, использующих HTTPS. При этом страницы с HTTP помечаются как «небезопасные», чтобы предупреждать пользователей.

Как ускорить индексацию сайта в Яндексе и Google

Что такое индексация сайта поисковыми системами?

Индексация в поисковых системах – добавление сведений о сайте в базу данных, которая используется при выводе результатов поиска информации. Результаты поиска:

Индексацию выполняет робот поисковой машины.

Для чего необходимо ускорить индексацию сайта в Яндексе и Google

Увеличение скорости индексации защищает сайт от воровства статей. Проблема возникнет, когда текст опубликуют на ресурсе, который индексируется быстрее. Из-за этого пользователи чаще увидят информацию оттуда, а поисковая система решит, что все остальные копии — заимствование текста.

Из-за этого пользователи чаще увидят информацию оттуда, а поисковая система решит, что все остальные копии — заимствование текста.

Скорость индексации важна при торговле ссылками и для увеличения трафика. Чем быстрее пройдет индексация, тем раньше на страницу будут выходить системы поиска.

Обычно страницы попадают в индекс с запозданием в 3-15 дней. Понятно, что для новостных и событийных ресурсов это – огромная проблема. Часто Вас интересуют новости двухнедельной давности?

От скорости индексации косвенно зависит позиция сайта в списке результатов поиска и количество посетителей ресурса.

Скорость загрузки сайта и его аптайм также влияет на индексацию — мы предлагаем скоростной и надежный виртуальный хостинг и VPS SSD хостинг в России.

Особенности ускоренной индексации сайтов поисковыми системами

Существуют отличия в процессе индексации сайтов разными поисковыми системами. Обычно получается, что Google индексирует новую страницу раньше, чем Yandex.

Индексация Гуглом занимает 2 или 3 суток. Страница попадает в индекс и становится доступной для пользователей.

Чтобы увидеть, в какую сторону развивать сайт для его быстрой индексации гуглом – достаточно посмотреть результаты поиска за последние 24 часа по Вашей тематике.

Индексация Яндексом происходит иначе. Страницы попадают в индекс при обновлении поисковой выдачи. Есть система «быстробот», с помощью которой страница может оказаться в поисковой выдаче буквально в течение дня.

Если это произошло, то можно не ждать обновления выдачи Яндекса.

Способы и советы по ускорению индексации сайта

Есть ряд способов, с помощью которых ускоряют индексацию сайта.

Регистрация в панелях для Вебмастеров поисковых систем

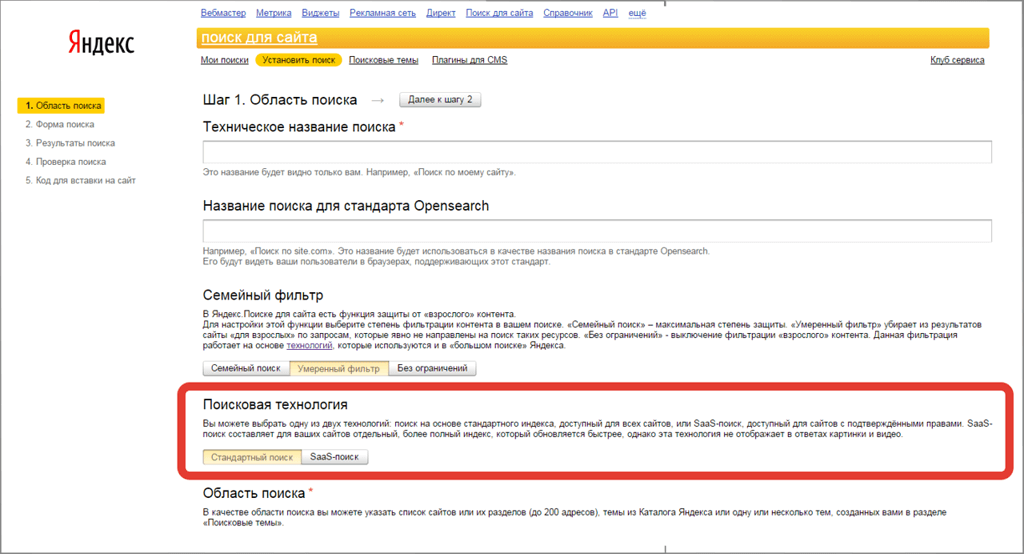

Специальные сервисы созданы для ведения истории сайтов – их индексации, анализа ключевых слов и переходов. Добавление сайта в «Яндекс Вебмастер» и «Вебмастер Google» позволяет выполнить много полезных для ускорения индексации действий.

Панели для вебмастеров расположены по адресам https://webmaster.yandex.ru для Яндекса и https://www.google.com/webmasters/tools для Google. Для работы с сервисами Google требуется регистрация Гугл-аккаунта (для Яндекса соответственно – аккаунта в системе Яндекс).

Полезно зарегистрироваться для работы с панелями разных систем поиска – Рамблер, Yahoo, Апорт и других.

Добавление новой страницы в Аддурилки поисковых систем

После опубликования страницы её надо внести в add url поисковых систем. Через некоторое время после этого робот зайдет на новую страницу. Это действие выполнится и автоматически, но через больший промежуток времени.

Аддурилка Яндекса:

Аддурилка Гугла:

Добавление в add url Яндекса возможно по адресу https://webmaster.yandex.ru/addurl.xml. Для внесения адреса в add url Google надо перейти по ссылке https://www.google.com/webmasters/tools/submit-url.

Внесение страницы в Add Url – единственный рекомендованный Яндексом путь ускорения индексации.

Популярные международные домены COM, NET, BIZ, INFO, ORG — проверка и регистрация.

Создание правильного файла robots.txt

В документ «robots.txt» заносят правила индексации сайта и ссылок. Такой файл возможно сделать самостоятельно, но для этого есть и специальные сервисы.

Готового рецепта тут нет, т.к. в зависимости от используемого движка сайта нужно закрывать «лишние» файлы и папки. Вот пример robots.txt для интернет магазина на OcStore (русская ветка OpenCart)

Готовый файл помещают в корневую папку сайта. После этого файл также проверяется сервисами для вебмастеров.

Если, например, не указать параметры сортировки – это может повлечь за собой попадание в индекс сотен и тысяч одинаковых страниц. В итоге поисковая система сочтет их дублями и «выкинет» из индекса все, кроме одной. Шанс, что эта одна и будет максимально отвечать на вопрос пользователя – минимален.

Поэтому найдите для своего движка сайта рекомендуемый robots.txt с пояснениями что и почему закрывается. Очень важно – не добавляйте туда что попало. Например, одна-единственная директива «Disallow /» без указания конкретной страницы запретит к индексации весь сайт. То есть, ни одна страница Вашего сайта не будет показываться в результатах поиска.

Очень важно – не добавляйте туда что попало. Например, одна-единственная директива «Disallow /» без указания конкретной страницы запретит к индексации весь сайт. То есть, ни одна страница Вашего сайта не будет показываться в результатах поиска.

Создание карты сайта в формате sitemap.xml

Файл «Sitemap.xml» создается специально для поисковых систем. В нем содержится список страниц для индексации. Каждую новую статью надо внести в карту sitemap.xml.

Для создания файла подходят онлайн-ресурсы, например, http://www.web-site-map.com/.

Карта формата xml должна быть проверена на правильность перед загрузкой в инструменты для вебмастеров.

Создание карты сайта в формате html

Карта требуется для всех ресурсов. Хорошо, если на ней обозначены все страницы сайта.

Когда на сайте появилась новая статья, её нужно сразу внести в карту html. Файл создается для индексации и удобства пользователей.

Качество и частота написания уникального контента для сайта

От частоты появления новых статей зависит, как часто робот будет посещать сайт. Регулярное добавление новой информации в разы увеличивает скорость индексации. Считается полезным создание жесткого графика появления новой информации – 1 раз в 3 дня или 2 раза в неделю. Робот будет заходить на сайт по этому расписанию и искать новые статьи.

Регулярное добавление новой информации в разы увеличивает скорость индексации. Считается полезным создание жесткого графика появления новой информации – 1 раз в 3 дня или 2 раза в неделю. Робот будет заходить на сайт по этому расписанию и искать новые статьи.

Поэтому новостные ресурсы публикуют десятки страниц в день – это залог того, что робот поисковых систем будет посещать такой сайт ежедневно. По этим же причинам очень быстро в результатах поиска появляются записи в соцсетях.

Контент низкого качества негативно влияет на индексацию. Не рекомендуется допускать:

- копирования чужих статей;

- публикации текста с большим количеством ошибок;

- добавления статей с высокой плотностью ключевых фраз.

Объем статьи тоже влияет на скорость индексации. Желательно публиковать информацию длиной не менее 1500 символов и уникальностью выше 80 – 90%. Полезно добавить к статье хотя бы одну картинку.

Использование социальных сетей

Публикация ссылок на страницах социальных сетей ускоряет индексацию. Рекомендуется завести аккаунты в нескольких сетях и добавлять там ссылки на новые страницы. После этого роботы поисковых систем обнаружат их гораздо быстрее.

Рекомендуется завести аккаунты в нескольких сетях и добавлять там ссылки на новые страницы. После этого роботы поисковых систем обнаружат их гораздо быстрее.

Минимум, который можно и нужно делать – кросспостинг в соцсети. Т.е. материалы сайта размещаются либо полностью, либо частично в социальных сетях.

Поисковые системы следят за появлением новой информации в сервисах социальных закладок – Toodoo, БобрДобр, МоеМесто, Delicious. Для увеличения скорости индексирования страницы можно оставлять там ссылки на неё. Популярность закладок минимальна, но способ еще работает.

Размещение внешних ссылок на новые статьи сайта

Кроме самостоятельного добавления ссылок из социальных сетей, можно заказывать их. Они быстро индексируются и помогают в этом другим сайтам. Недорого можно заказывать можно ссылки из ЖЖ.

На сегодняшний день зависимость скорости индексации от появления внешних ссылок минимальна. С учетом высокой стоимости таких ссылок на «крутых» сайтах – дешевле ежедневно публиковать свой тематический контент на своем сайте.

Добавление сайта в различные рейтинги

Наличие сайта в каталогах и рейтингах увеличивает его индексацию.

Среди рейтингов известны «Рамблер Топ 100», «Рейтинг LiveInternet», «Рейтинг Mail.ru».

Чтобы поднять авторитет сайта среди поисковых систем, нужно добавить его в каталоги. Бесплатно и сразу попасть в некоторые из них нельзя, но стоит подать заявки в каталоги Mail.ru, ЯК, DMOZ или Rambler.

Российские национальные домены со скидкой — RU, SU и РФ.

Перелинковка страниц сайта

Перелинковка сайта улучшает результаты выдачи и ускоряет индексацию. Суть метода – связь всех статей ссылками. Особенно это важно для молодых сайтов.

Пример перелинковки на нашем сайте:

Популярный способ – создание виджета в садбаре последних статей. Наличие ссылки на новую информацию на всех страницах сайта ускоряет скорость реакции робота на появление новой информации на сайте.

Другие способы ускорения индексации

- Создание RSS-трансляции на сайте.

Существует способ распространения ссылки на новую страницу по базе сайтов. Для этого подходит программа Pingxpetfree и другие rss-ленты. Рекомендуется создать аккаунт в Feedburner и транслировать записи туда.

Существует способ распространения ссылки на новую страницу по базе сайтов. Для этого подходит программа Pingxpetfree и другие rss-ленты. Рекомендуется создать аккаунт в Feedburner и транслировать записи туда. - Использование «правила трех кликов». Для улучшения индексации и поведенческих факторов сайта рекомендуется распределить страницы таким образом, чтобы до них было не более трех переходов от главной.

- Анонсирование новых статей. Регулярное анонсирование новых статей в блогах и социальных сетях привлекает на сайт робота. Скорость индексации растет из-за ссылок из Twitter, ВКонтакте, LiveJournal, LiveInternet. Успех применения метода зависит и от популярности страницы в социальной сети или блогплатформе.

- Общение на форумах Сообщения и комментарии на форумах и в блогах подходят для индексации нового сайта. Чтобы использовать этот метод, стоит обратить внимание на популярные и хорошо индексируемые ресурсы.

Для привлечения робота к каждой записи использовать такой способ не стоит.

Для привлечения робота к каждой записи использовать такой способ не стоит. - Добавление кнопок социальных сетей на сайт. Добавление кнопок социальных сетей упрощает процедуру копирования ссылки на страницу. Нажатие этих кнопок пользователями поможет увеличить и посещаемость ресурса.

Как видите, существует множество способов ускорить индексацию сайта в Яндексе и гугле, причем часть из них помимо индексации способны привести к Вам на сайт заинтересованную аудиторию.

iPipe – надёжный хостинг-провайдер с опытом работы более 15 лет.

Мы предлагаем:

Как ускорить индексацию сайта в Яндексе и Google

Актуальные способы ускорить индексирование страниц в обоих поисковиках.

Быстрое индексирование страниц — это хорошо. Чем быстрее страница займет место в выдаче поисковой системы, тем быстрее ее смогут увидеть пользователи. А также эта страница с большей вероятностью будет считаться первоисточником контента, который на ней находится.

К сожалению, нельзя точно сказать, когда боты поисковых систем просканируют страницу и она появится в выдаче — это зависит от размера и оптимизации сайта.

Частые проблемы с индексацией сайта в ПС

Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход. Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию.

Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика. Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Помогут материалы о санкциях Яндекса и фильтрах Google.

Страницы индексируются, но долго

Если приходится долго ждать индексации новых страниц, вариантов может быть много: контент редко обновляется и поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке или что-то еще.

Посмотреть динамику индексации страниц и наличие фильтров можно в Анализе сайта:

Индексация и санкции ПС в Анализе сайтаИтак, если страницы не индексируются, то проверьте ограничения, если игнор от одного из ПС, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить. Посмотрим, что можно сделать.

Как ускорить индексацию страниц

Представитель Google Джон Мюллер на вопрос об индексировании ответил так:

«Лучший способ улучшить процесс индексирования – создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим. Нужно также понимать, что поисковые системы не индексируют абсолютно все, что выложено в сети».

Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный 🙂 Это все, конечно, хорошо, но давайте посмотрим, что конкретно можно сделать, чтобы ускорить процесс.

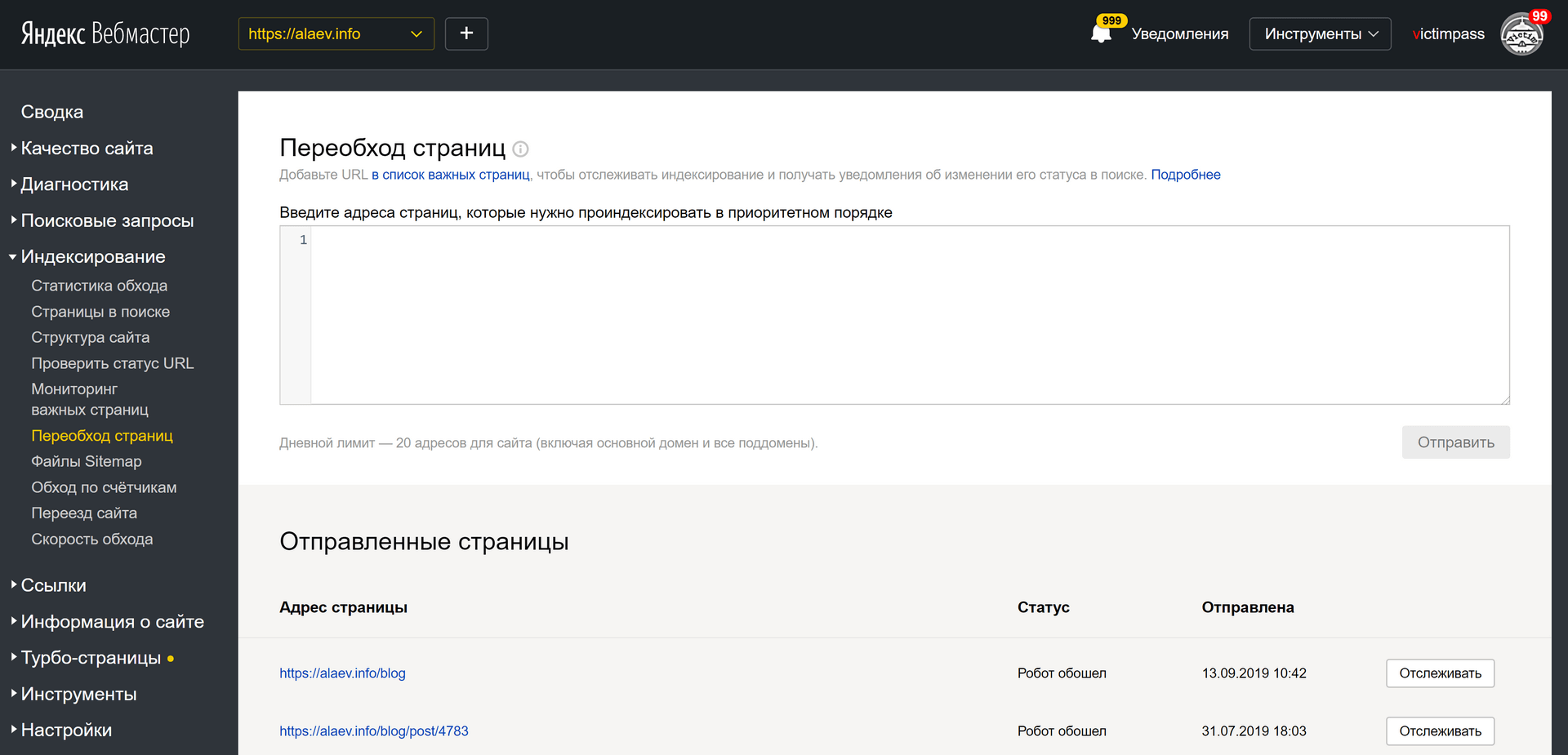

Отправить страницу на переобход

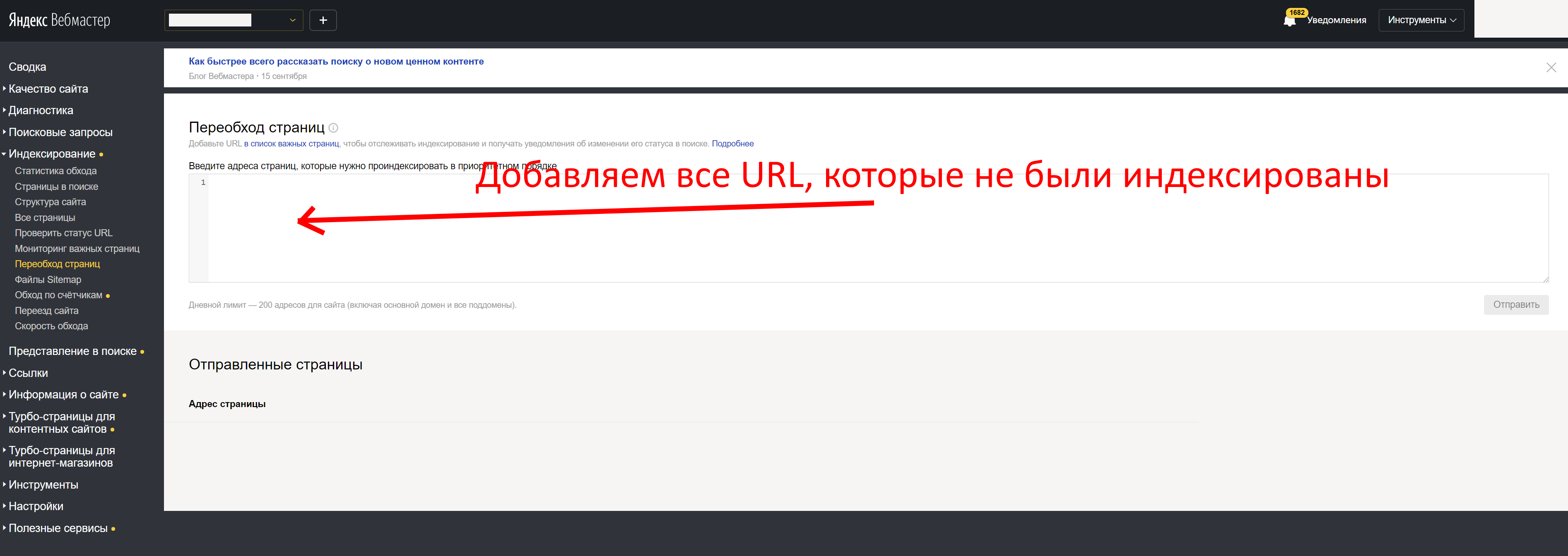

Можно дополнительно обратить внимание поисковиков на конкретные URL. В Google Search Console и Яндекс.Вебмастер найдите переобход страниц и отправьте нужные URL на индексацию.

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Как говорит Ксения Пескова, SEO-TeamLead в Siteclinic:

«Если вы закроете сканирование в файле robots.txt — это всё равно может не уберечь от индексации страницы, так как в файле мы запрещаем сканирование, и это всего лишь рекомендации, а не прямое указание».

В любом случае, лучше проверить файл robots, вдруг там стоят запреты, к которым прислушались боты поисковых систем.

Создать Sitemap — Карту сайта

Карта сайта помогает поисковым ботам понять структуру ресурса и обнаруживать обновления контента.

Почитать по теме:

Карта сайта (файл Sitemap) от А до Я

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться. Для проектов на конструкторах сайтов, например, на WIX и Tilda, карта по умолчанию динамическая, для других CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Можно обновить файл Sitemap вручную. Обновленные страницы Google рекомендует отметить в Карте тегом . Обновленный файл отправьте с помощью специального отчета. Не стоит загружать один и тот же файл повторно: если вы ничего не поменяли в Карте сайта, никаких изменений не будет.

Но опять же, ссылки в Карте сайта — это рекомендации, важнее создать грамотную структуру сайта и организовать внутреннюю перелинковку.

Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования. Такие страницы называют сиротами.

Страница-сирота в структуре сайта

Нужно встроить их в структуру сайта. К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

Еще один момент, который влияет на поведение бота — это Click Distance from Index (DFI), то есть количество кликов от главной до текущей страницы. Чем оно меньше, тем важнее считается страница, тем больший приоритет она получит с точки зрения бота. Приоритетные страницы он смотрит первее остальных.

DFI не определяется по числу директорий в URL, они могут не совпадать. Например, если на главной странице будет ссылка на хит продаж — конкретную модель холодильника Atlant, то DFI будет равен двум. Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Сотрудник Google советовал добавлять на страницу видео с Youtube, если странице нечего добавить и содержание еще актуально. Поведенческие улучшатся за счет просмотра видео, на странице появится новый формат контента — это тоже хороший сигнал для поисковика.

Публиковать ссылки в соцсетях и на других площадках

Если вы ведете страницы в социальных сетях, размещайте на них анонсы ваших новых материалов. С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

Найдите сторонние площадки по вашей тематике, где можно оставлять ссылки или публиковать посты, и размещайте таким образом ссылки на новые материалы. Ссылки должны быть естественными и подходить по теме. Используйте пресс-релизы, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки.

Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, сли в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Медленная загрузка страниц вредит им по всем параметрам: пользователи не ждут, ПС считают некачественными, могут даже понизить сайт в выдаче, если сайт в принципе медленный.

По ускорению у нас есть подробные материалы о том, как оптимизировать код верхней части страницы, использовать сжатие gzip, brotli и минификацию кода, оптимизировать изображения.

Многое из перечисленного можно проверить на сайте автоматически. Поможет сервис «Анализ сайта»: проверит сайт по 70+ тестам, оценит и главную, и внутренние страницы, найдет ошибки и даст советы по исправлению.

Фрагмент анализа сайтаМногие функции сервиса и графики доступны на платных тарифах Анализа, но вы можете попробовать неделю бесплатно и оценить все возможности.

До конца лета на любой тариф «Анализа сайта» действует скидка 30% по промокоду LAST_DAYS.

Промокод сработает сразу при переходе на страницу —> Купить со скидкой

FAQ: что еще влияет на скорость индексации сайта

Как страницы вне индекса могут повлиять на отношение поисковика к сайту?Качество контента на сайте поисковики оценивают только по проиндексированным страницам.

Тег noindex может влиять на индексацию страницы после его снятия?По словам Джона Мюллера из Google, у веб-мастера не будет проблем с реиндексацией URL, на которых когда-то был noindex.

Джон Мюллер утверждает, что поисковик скорее всего не проиндексирует конечный URL при использовании ссылок с 301 редиректом.

Как ускорить индексацию страниц, которые были 404?Если адрес страницы отдавал 404 и не был индексирован, на индексирование может потребоваться некоторое время. Как советуют Seroundtable, можно создать новый URL для этого контента и настроить 301 редирект со старого адреса, либо запросить повторное сканирование URL.

Как поисковики относятся к URL c хэшами?URL с хешами поисковик не проиндексирует. То есть ссылка https://site.ru/news/p/statya проиндексируется, а ссылка на конкретную часть статьи — https://site.ru/news/p/statya#step — нет.

Расскажите в комментариях, что мы упустили в материале, какие способы ускорить попадание в индекс используете вы.

что это такое, как происходит, как ускорить и проверить индексацию

Нравится статья?

Понравится и работать с нами.

Индексация сайта в поисковых системах – это то, без чего SEO продвижение невозможно. Если страниц вашего сайта нет в индексе, они не выводятся в поисковой выдаче, а значит, в конкуренции за верхние позиции вы пока не участвуете, и пользователи из поиска не могут перейти к вам.

Разбираемся, как Яндекс и Google индексируют сайты, можно ли ускорить и проконтролировать процесс и каким страницам индексация не нужна.

Что такое индексация и как она происходит

Поисковые системы по запросу выдают пользователям подходящие страницы за пару секунд. Естественно, в это время роботы не перебирают реальные сайты – такой поиск тянулся бы часами. Для ускорения поисковики обращаются к собственной, заранее собранной базе данных. Эта база – и есть индекс.

Поисковики индексируют сайт автоматически, с помощью поисковых роботов – их называют пауками или краулерами. Упрощенно это выглядит так:

- Пауки постоянно отслеживают новые сайты и страницы в интернете.

- Попав на сайт, робот сканирует его.

Если в корневой папке лежит правильно заполненный файл robots.txt (а мы настоятельно советуем его прописать и поместить туда), краулер быстрее поймет, какие страницы нужно индексировать, а какие – нет.

Если в корневой папке лежит правильно заполненный файл robots.txt (а мы настоятельно советуем его прописать и поместить туда), краулер быстрее поймет, какие страницы нужно индексировать, а какие – нет. - На каждой странице робот в автоматическом режиме оценивает важнейшие элементы, от которых зависит позиция при ранжировании (ключевые запросы, текст, структуру, метатеги и пр.).

- Проиндексированные страницы передаются в базу данных. В каждый визит робот обрабатывает не так много страниц, до 30 штук, чтобы не перегружать ваш сервер.

- После индексации сайта страницы начинают отображаться в выдаче, ведь теперь поисковая система знает о них.

- В дальнейшем робот продолжает посещать ваш сайт, чтобы просканировать и добавить в базу новые страницы. Также поисковики могут удалять страницы из индекса, обнаружив на них технические ошибки. Если вы ежедневно публикуете контент, робот может заходить к вам несколько раз в день, а если сайт долго остается без изменений, то и поисковики будут реже обращать на него внимание (до 3 раз в месяц).

Индексация сайта в Яндексе сразу после запуска может занять до 1 месяца, а в Гугл – до 1 недели.

Как быстрее попасть в индекс

Для успешного продвижения в Яндексе и Google важно, чтобы новые страницы как можно скорее попадали в индекс и начинали ранжироваться. Поэтому советуем использовать возможности для ускоренной индексации сайта.

Как привлечь внимание поисковиков и быстрее занять место в выдаче:

- Обязательно составить служебный файл robots.txt и карту сайта Sitemap в помощь поисковым ботам.

- Войти в панели управления Google Search Console и «Яндекс.Вебмастер» и оставить заявку на индексацию конкретных страниц.

- Обеспечить надежность и скорость работы сайта – робот при обнаружении проблем на сайте снижает частоту обхода.

- Позаботиться о качественных внешних ссылках, которые добавят вам «веса» и повысят шансы на быструю индексацию сайта по ключевым словам.

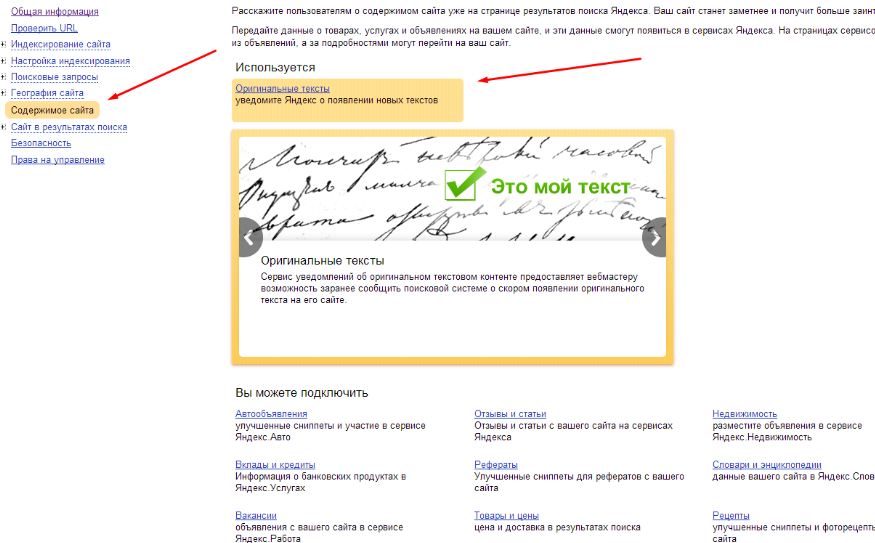

- Регулярно добавлять новые страницы и публиковать свежие материалы – тогда поисковики будут чаще обращать внимание на ваш ресурс.

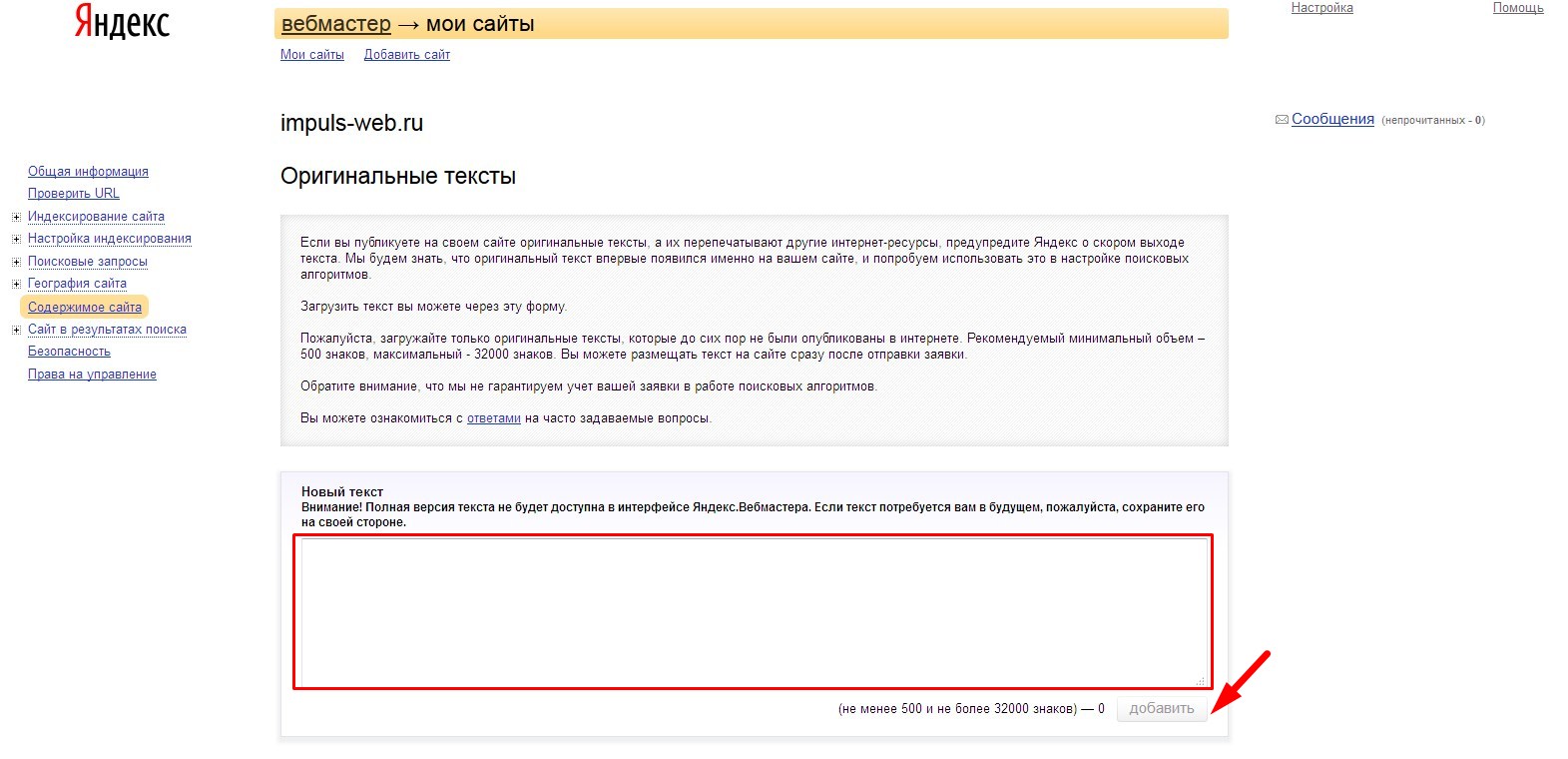

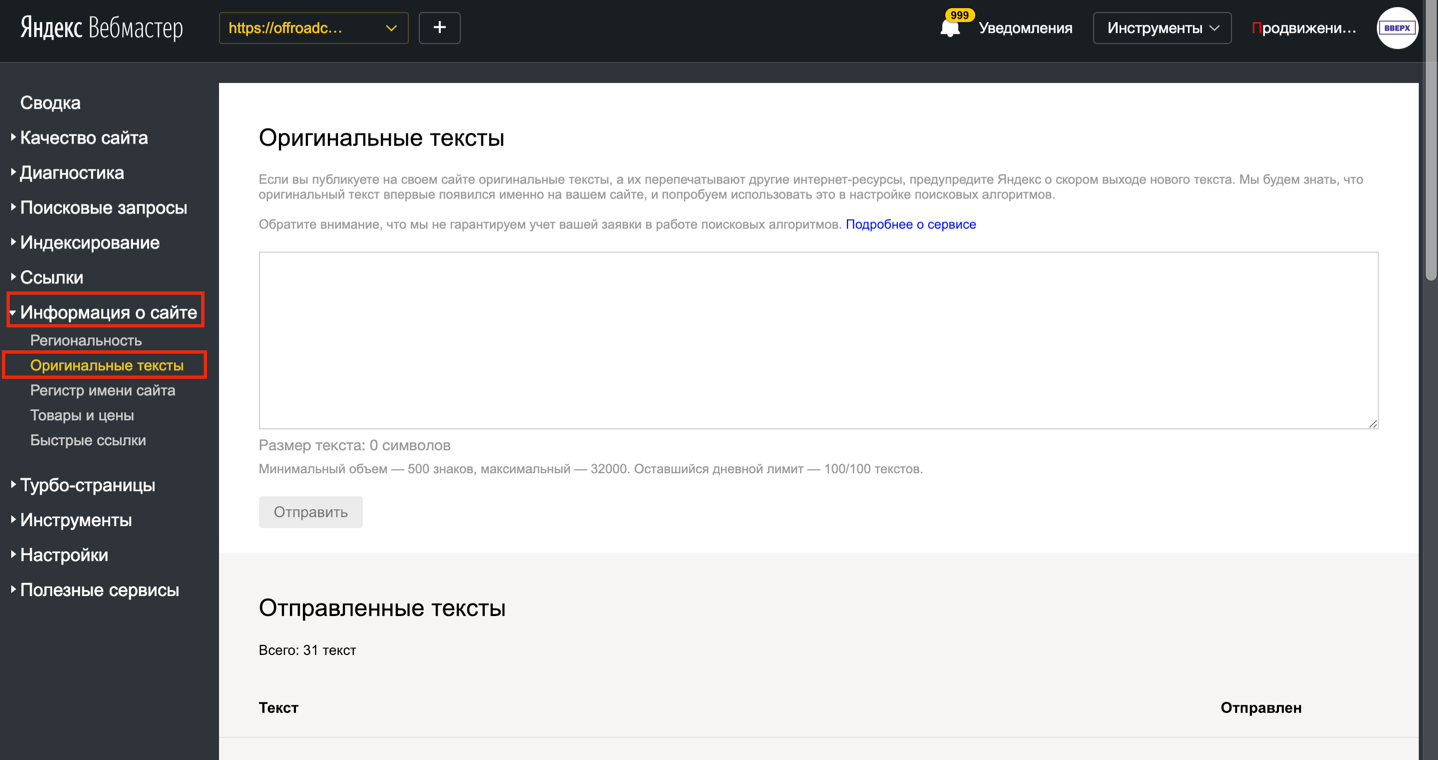

Обязательно добавлять новые материалы в «Оригинальные тексты» в Яндекс.Вебмастере.

Обязательно добавлять новые материалы в «Оригинальные тексты» в Яндекс.Вебмастере. - Оптимизировать сайт в плане удобства для пользователей – юзабилити. В первую очередь, важны понятный каталог и система навигации, сеть перекрестных внутренних ссылок (перелинковка) – всё, что ускоряет перемещение бота по вашему сайту и помогает ему проиндексировать больше страниц за один раз.

Кстати, быстро индексировать страницы нужно не только новым сайтам. Если вы обновили цены или описания в каталоге, прописали привлекательные метатеги Description или загрузили в блог горячую новость, вам тоже важно, чтобы индексацию не пришлось ждать месяцами.

Как проверить индексацию сайта

В первые недели после запуска нового сайта важно проверить, попали ли нужные страницы в индекс поисковых систем и сколько вообще страниц проиндексировано. Но и в дальнейшем советуем держать руку на пульсе.

Вот основные способы проверить индексацию сайта в поисковых системах:

- Вручную через брендовые запросы

- Через оператор site в поисковой строке

- В Яндекс.Вебмастере или Search Console в Гугл

- Автоматически с помощью плагинов, скриптов или специальных сервисов

Вводим в строке поиска название компании и просматриваем первую пару страниц выдачи. Способ самый простой, без технических сложностей, но не быстрый и не очень удобный.

Способ самый простой, без технических сложностей, но не быстрый и не очень удобный.

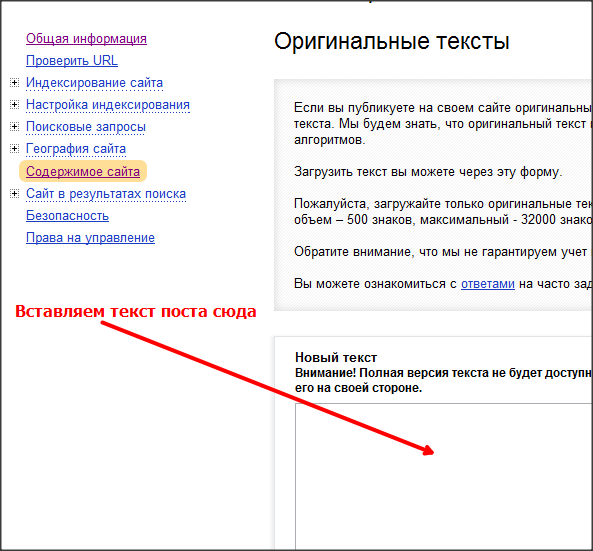

Чуть сложнее, но точнее: вбиваем в поиске Яндекса или Гугл оператор site, а после него – адрес сайта.

Например, наберем URL zamkitut.ru для проверки индексации сайта. В результатах поиска будут только проиндексированные страницы заданного сайта, и ничего не придется выбирать вручную.

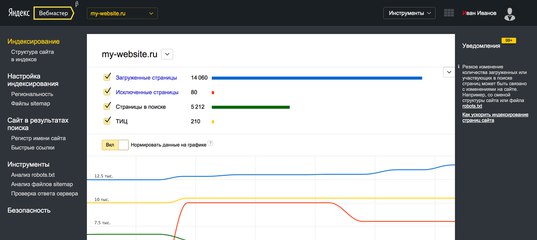

Способ для тех, у кого есть доступ к панели вебмастера. В Гугл нужно открыть вкладку «Индекс Google» и выбрать «Статус индексирования», а в Яндекс.Вебмастере развернуть меню «Индексирование сайта», а затем «Страницы в поиске». Здесь можно посмотреть не только текущее количество страниц в индексе, но и динамику.

Сервисы и программы – быстрый и надежный способ проверить индексацию сайта онлайн. Не вручную вбивать запросы: небольшие программы для проверки обычно можно сохранить в браузере, как закладки, и запускать при необходимости.

Советуем попробовать плагин RDS bar для разных браузеров, а также программы наподобие Netpeak Spider или Netpeak Checker.

Так выглядит рабочее окно Netpeak Spider: программа выдает много дополнительной информации, помимо количества страниц в индексе.

3 и 4 способ – самые информативные и удобные, мы советуем мониторить индексацию по ходу продвижения сайта именно так. В специальной программе или на панели вебмастера вы увидите, когда последний раз Яндекс индексировал сайт, какие именно страницы попали в индекс, какие проблемы выявили поисковики и т.д.

Почему сайт не индексируется и как это исправить

Иногда с индексацией возникают проблемы: сайт целиком или отдельные страницы перестают выводиться в поисковой выдаче. Почему Яндекс не индексирует сайт и как это исправить:

- Прошло недостаточно времени. Если сайт или группа страниц появились недавно, поисковой робот мог просто не успеть их проиндексировать – используйте наши приемы ускорения из списка выше.

- Неправильно заполнен файл robots.txt. Лучше доверить работу с этим служебным файлом программистам, потому что случайная ошибка в нем может запретить индексировать сайт без вашего ведома.

- Критичные для поисковиков ошибки на сайте – их важно находить и вовремя исправлять.

- Нет карты сайта (SiteMap). Обязательно пропишите ее и добавьте в корневую папку – карта поможет ускорить индексацию сайта.

- На сайте есть дубли страниц или контент, полностью скопированный с других ресурсов – такие страницы принципиально не индексируются.

- Сервер работает с перебоями. Если сайт периодически недоступен или загружается слишком медленно, могут быть проблемы с индексацией, так что есть смысл переехать на более надежный хостинг.

Как закрыть сайт от индексации и когда это нужно

Иногда бывает нужно запретить индексацию сайта или отдельных страниц.

Зачем это делается:

- Чтобы в выдачу не попадали служебные страницы сайта: личный кабинет пользователя, корзина, панель управления и прочее.

- Чтобы поисковой робот быстрее добрался до целевых страниц и проиндексировал их, а не тратил время на малозначительный контент, который не нужно продвигать.

- Чтобы в индекс не попали дубли страниц (поисковики это не любят).

Пример страницы, которую нужно закрыть от индексации – корзина в интернет-магазине дверной фурнитуры.

Основные способы «спрятать» ненужные страницы или разделы от поисковиков:

- В файле robots.txt закрыть сайт от индексации позволяет директива Disallow – она прописывается рядом с адресами страниц, которые не должны попасть в выдачу.

- В коде страницы можно использовать тег «noindex» – он закрывает от индексации не ссылки, а только часть текста, заключенную внутри тега.

- Атрибут rel=«nofollow» – применяется к конкретной ссылке и указывает поисковым роботам, что по ней не нужно переходить. Этот атрибут понимают все поисковики.

- Мета-тег robots – он дает поисковым системам указания насчет индексации. Если в содержимом этого мета-тега прописать «noindex, nofollow», страница не будет индексироваться.

Важно: «noindex» считывает и понимает только Яндекс. Для управления индексацией в Google применяйте другие способы из этого списка.

Индексирование сайта. Рассказываем, как добавляться в поисковые системы, и отвечаем на важные вопрос

Статья из блога АРТИЗАН-ТИМ.

Вы решили создать сайт. Выбрали перспективную тематику, придумали доменное имя и развернули ресурс на хостинге. Что делать дальше? Следующий шаг — добавление сайта в Google и Яндекс. Это очень важно, поскольку пока о сайте не узнают поисковые роботы, пользователи не смогут находить вас через поиск. Ресурс будет нормально работать, но не сможет получать самое ценное — органический трафик.

Забегая вперед отметим, что первые полгода-год рассчитывать на поток органики нет смысла. Молодой сайт по умолчанию попадает в песочницу и его видимость в поиске ограничена. Больше о том, что такое песочница и как из нее быстрее выйти — читайте здесь.

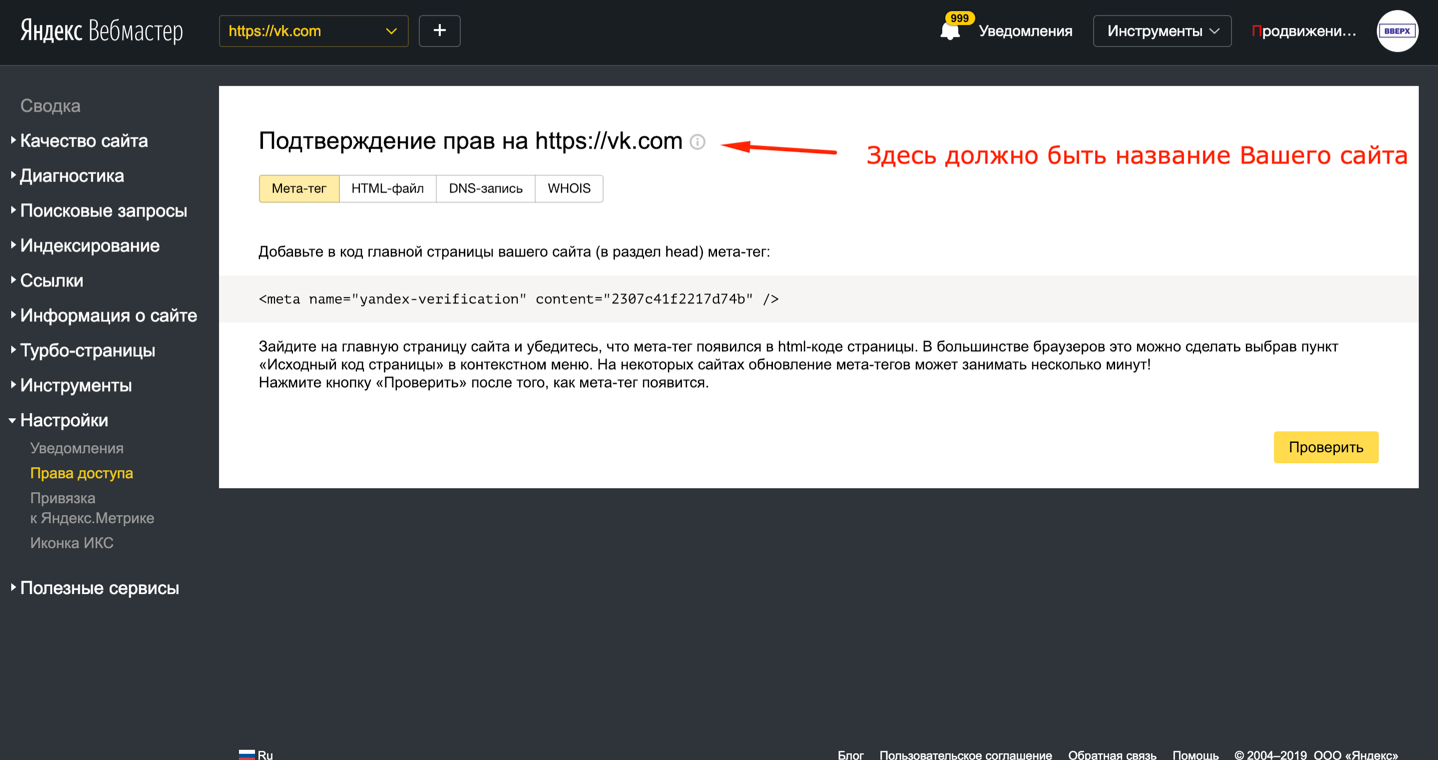

В добавлении в индекс нет ничего сверхсложного. Если коротко: нужно создать учетные записи в вебмастерках Google и Яндекса и подтвердить в них права на владение сайтом; далее создаем карту сайта в xml-формате и забрасываем ее в соответствующие разделы каждого из сервисов. Теперь наглядно и более детально, как это делать. По ходу дела будем давать ответы на самые животрепещущие вопросы, возникающие у новичков.

Вам также может быть интересен наш курс молодого seo-бойца, как создать и по-белому продвинуть сайт, имея скромный бюджет:

Выбираем тематику, оцениваем перспективность ниши, анализируем конкурентов, собираем семантику

Проводим стартовые работы по внутреннему и внешнему SEO

Индексируем сайт в Google

Основной способ добавить ресурс в поиск Google — сделать это посредством Google Search Console. Вы можете встретить и другие варианты, но связываться с ними мы бы категорически не советовали, ниже расскажем почему.

Google Search Console — это бесплатный сервис для вебмастеров, через который отслеживают все жизненно важные параметры сайта в поисковой системе Google. О назначении и основных фишках консоли можно почитать здесь. Ну, или просто поверьте на слово, что привязка сайта к этому сервису — мастхэв для любого вебмастера, конечно, если вы не намерены пренебрегать трафиком из Гугла.

Подтверждаем права на сайт в Google Search Console

Для начала вам понадобится — аккаунт в Google. Он создается за пару минут здесь. Далее переходим на страницу сервиса и привязываем к нему свой сайт. Но сначала нужно пройти верификацию, что вполне логично, т.к. система должна убедиться, что права на сайт принадлежат вам.

Так приветствует Search Console. Начинаем верификацию. Мы покажем самый популярный (да, он не один) способ подтверждения прав — с помощью DNS.

Сначала указываем сайт. Можно ввести либо просто доменное имя (слева), либо URL ресурса (справа). Подробные подсказки даны в каждом из полей.

Прописав имя сайта, и нажав продолжить, появится окно с перечнем вариантов, каким именно способом вы желаете подтвердить права на сайт. Выбираем «Добавление записи DNS в конфигурацию домена». Вам будет доступно окно, изображенное на скриншоте. Сгенерированная TXT-запись – это персональный ключ верификации, который нужно добавить в конфигурацию DNS домена в панели управления хостингом.

Давайте посмотрим, как это сделать на примере самой популярной панели управления веб-хостингом cPanel. В блоке «Домены» переходим в Zone Editor, выбираем нужный домен (если он не один) и нажимаем «Управлять».

Откроется новое окно.

В нем еще раз выбираем интересующий нас домен (в поле «имя»), а в графу «запись» вводим скопированный TXT-ключ. Нажимаем «Добавить запись».

Права на сайт подтверждены, но нужно подождать несколько часов пока обновится DNS.

Есть и другие способы подтверждения прав в Google Search Console. Возможно, они и несколько сложней для новичков, но хороши тем, что позволяют пользоваться консолью сразу после верификации. Это может быть удобно, когда по каким-то причинам нет времени ждать обновления DNS. Подробно об остальных способах верификации — читайте в справке Google.

Отправляем запрос на индексирование

После того как мы добавили сайт в вебмастерку и прошли верификацию, отправляем запрос на индексирование. Для этого:

1. Переходим во вкладку «Проверка URL».

2. В поисковой строке консоли вбиваем адрес ресурса (или новой страницы).

3. Запрашиваем индексирование.

Если указанный URL доступен для сканирования поисковыми роботами (их также называют краулерами), страница попадает в очередь на индексирование, о чем вас уведомят следующим сообщением.

Но это еще не все.

Создаем и добавляем sitemap.xml

Чтобы помочь краулерам Google корректно проиндексировать сайт, в вебмастерку необходимо загрузить карту сайта. Начинающие вебмастера почему-то думают, что это очень сложно. Расслабьтесь, это не так. Все просто, но давайте по порядку. Sitemap.xml — это список XML-документов, в которые вшиты служебные данные. Вся эта информация — своего рода ориентиры, необходимые поисковым системам для удобной и эффективной индексации всех страниц сайта.

Выглядит sitemap.xml вот так:

Сгенерировать sitemap.xml можно при помощи специальных программ и даже онлайн-сервисов. С сайтами на WordPress, все еще проще: можно использовать плагины Yoast или Google XML Sitemaps, которые сделают большую часть работы сами.

Сгенерировав файл sitemap.xml, далее его нужно загрузить на сервер. Обратите внимание, это актуально, если вы создавали карту сайта с помощью сервисов или программ. В cPanel это делают через «Диспетчер файлов», доступный в блоке «Файлы» на стартовой странице.

Если использовались плагины для WordPress, файл sitemap.xml подтянется на сервер автоматически.

Остался финальный аккорд — забрасываем карту сайта в соответствующий раздел Google Search Console: Индекс → Файлы Sitemap

Об альтернативных способах индексирования

На форумах вебмастеров можно встретить дискуссии, на тему альтернативных способов отправки страниц в индекс. Например, многие оптимизаторы уверены, что если прогрузить в браузере Google Chrome главную или новые страницы сайта, они автоматически залетят в гугловский индекс. Или, что если добавить на непроиндексированные страницы код счетчика Google Analytics, поиск автоматически получит информацию о появлении новых документов, которые необходимо просканировать.

Эти способы, не требующие практически никаких усилий, могут показаться привлекательными для начинающих вебмастеров. Но связываться с ними мы бы категорически НЕ рекомендовали. Нет убедительных оснований считать, что Google Chrome и GA каким-либо образом влияют на индексирование страниц. Это подтверждено, в том числе, экспериментально1. В самом Google также никогда официально не высказывались на этот счет.

Поэтому пользуйтесь только общепризнанным алгоритмом добавления в индекс Google. Еще раз, теперь уже вкратце, подытожим, что нужно делать:

- Создаем аккаунт в Google и добавляем свой сайт в Search Console.

- Подтверждаем права на сайт. Самый простой способ — с помощью DNS.

- Отправляем запрос на индексирование.

- Создаем файл sitemap.xml и добавляем его сначала на сервер, а затем в соответствующий раздел консоли. Если sitemap генерировался через плагины WordPress, загрузка на сервер не нужна.

Добавляем сайт в поиск Яндекса

Чтобы страницы нового сайта начали отображаться в поиске Яндекса их также нужно добавить в индекс. Механика процесса идентична поисковой системе Google. Добавление ресурса в поиск осуществляют через консоль Яндекс.Вебмастер. При этом есть и другие способы (о них мы расскажем ниже), но наиболее рабочим считается именно этот. Возможности вебмастерки Яндекса в целом аналогичны Search Console. Более подробно об этом сервисе можно почитать здесь.

Добавление в Яндекс.Вебмастер и подтверждение прав на сайт

Для привязки сайта к вебмастерке понадобится учетная запись в Яндексе. Если она есть, что вероятнее всего, т.к. многие пользуются почтой и другими яндексовскими сервисами, переходим сюда и указываем адрес сайта.

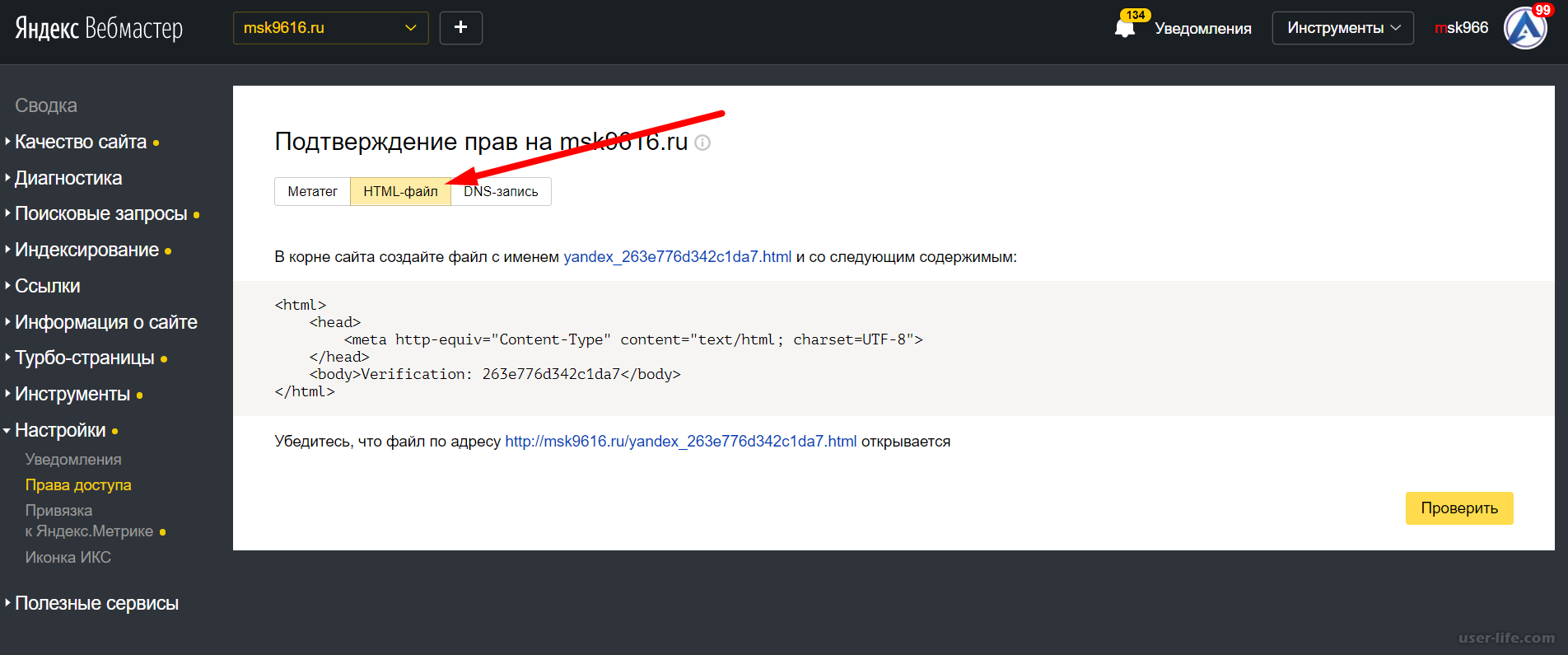

Как и в случае с гугловской консолью, дальше нужно пройти верификацию и подтвердить права. Сделать это можно по-разному:

- создав HTML-файл с уникальным идентификатором, и поместив его в корневой каталог сайта;

- разместив в HTML-коде главной страницы специальный метатег;

- добавив DNS-запись с идентификатором;

- подтвердив электронный адрес из WHOIS-записи (этот способ не рекомендуется даже самим Яндексом).

Для подтверждения прав удобнее всего использовать первый способ — через HTML-файл. Указав сайт и перейдя во вкладку, отмеченную на скриншоте, система сгенерирует файл с уникальным именем и содержимым. Его нужно скачать и разместить в корневом каталоге сайта. Далее проверяем, что файл открывается по указанной ссылке. Нажимаем кнопку «Проверить». Если все сделано правильно, панель инструментов слева станет кликабельной.

Добавляем сайт в индекс

После верификации и получения доступа к функционалу вебмастерки, выполняем следующие действия.

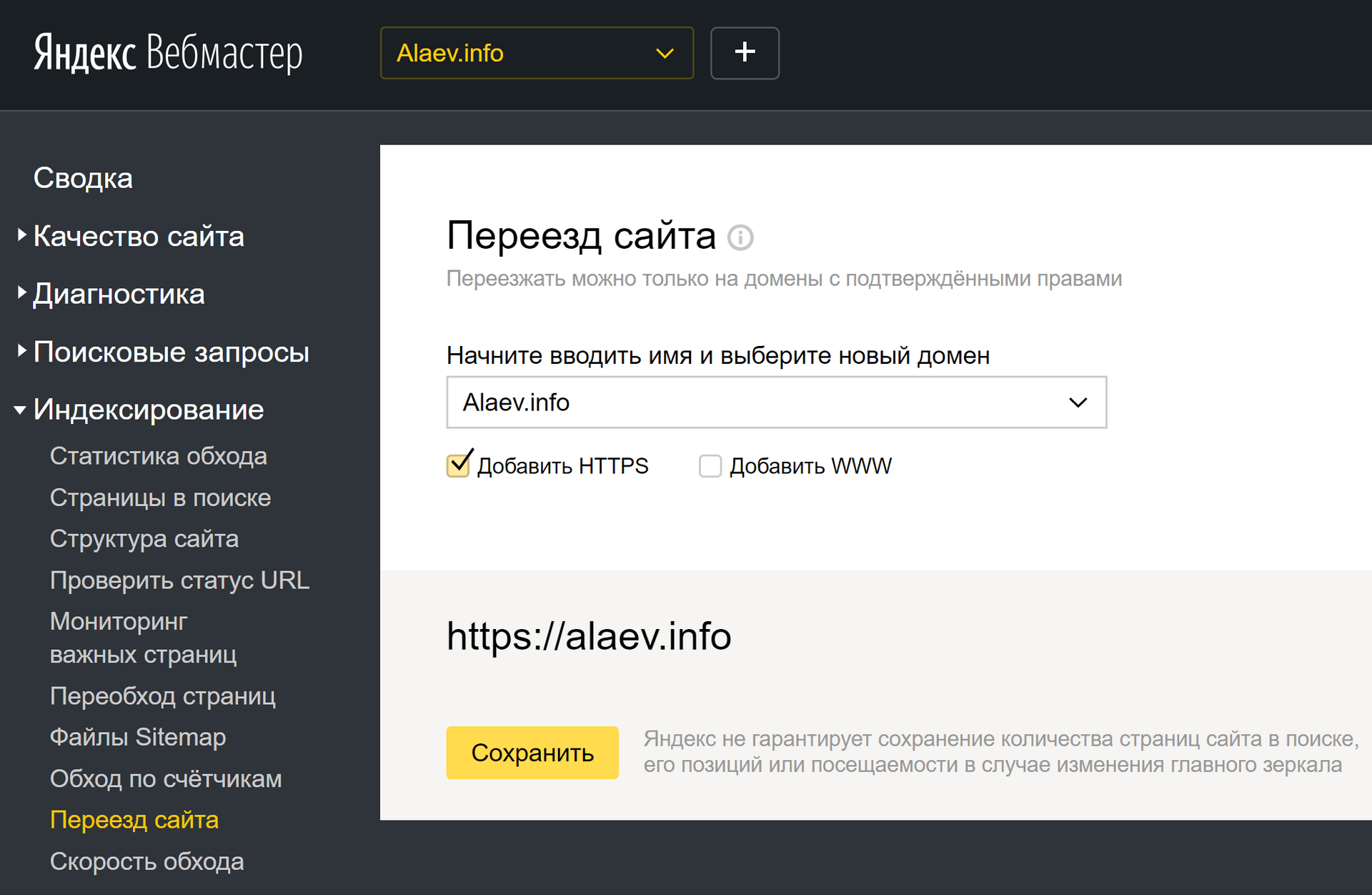

Переходим во вкладку «Индексирование» → «Переобход страниц»

Добавляем главную страницу и основные разделы сайта — нажимаем «Отправить». Обратите внимание, в Яндексе установлен лимит на количество индексируемых страниц.

Все новые страницы, которые в дальнейшем будут добавляться на сайт, отправляют на переиндексацию по аналогичной схеме.

Дополнительно в Яндекс.Вебмастер необходимо добавить файл sitemap.xml. Здесь работает та же механика, что и в Google. Сначала необходимо создать саму карту. Если это сделано не через плагин — размещаем sitemap на сервере. Далее в разделе «Индексирование» → Файлы Sitemap вписываем в поле URL, по которому доступен файл. Нажимаем «Добавить».

После добавления файл будет какое-то время обрабатываться. Это происходит не быстро, и может занять до двух недель. По завершении обработки напротив файлов должен отображаться статус «OK». Если присутствует статус «Редирект», «Ошибка» или «Не проиндексирован», необходимо определить причину некорректной индексации, исправить ее, после чего сообщить роботам об обновлении.

Индексируем страницы через Яндекс.Метрику

Существует еще один способ сообщить краулерам Яндекса о новых страницах сайта — через Метрику. Этот вариант менее удобен, чем первый, но знать о нем вебмастеру не помешает. Для этого на сайте должен быть добавлен и настроен счетчик Яндекс.Метрики. В любом случае рано или поздно его придется добавить, конечно, если вы намерены серьезно заниматься продвижением своего проекта.

Итак, чтобы роботы Яндекса подтягивали сведения о новых страницах из данных Метрики, нужно разрешить обход страниц, на которых установлен счетчик. Для этого выполняем следующие действия.

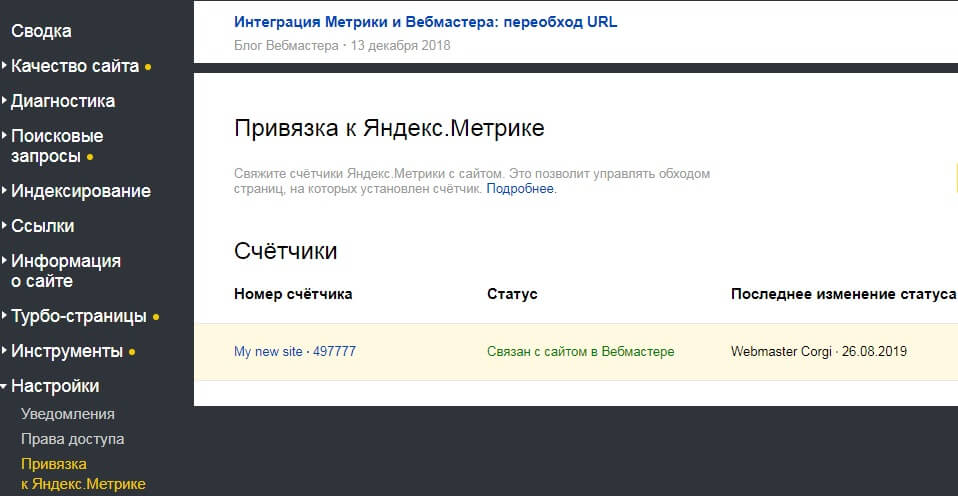

Активировав эту опцию, во вкладке Привязка к Яндекс.Метрике отобразится статус «Связан с сайтом в Вебмастере».

Сколько ждать попадания в индекс?

В индекс Google новый сайт залетает в среднем спустя неделю. В Яндексе — это может занимать до двух недель. Эти сроки актуальны, если на сайте не создано никаких препятствий для обхода поисковыми роботами. Важно понимать, попадание в индекс не означает, что страницы со старта получат высокие позиции в поиске. В первое время, скорее всего, они будут на задворках выдачи — на второй-третьей странице. И только постепенно начнут укреплять свои позиции. Также они могут вовсе не отображаться по основным поисковым запросам (находясь при этом в индексе). Второй сценарий больше актуален для молодых сайтов, пребывающих в песочнице.

Как быстро проверить индексацию?

Узнать, попал ли сайт в индекс, вы можете по-разному. Основной способ — через панель вебмастера.

В Google SC сведения представлены в отчете Индекс → Покрытие. Количество страниц, попавших в индекс, доступно в зеленой графе.

Здесь же красным цветом будет отображаться количество страниц с ошибками. Перейдя по вкладке, можно ознакомиться с расширенным отчетом: что конкретно за ошибка и когда она была обнаружена.

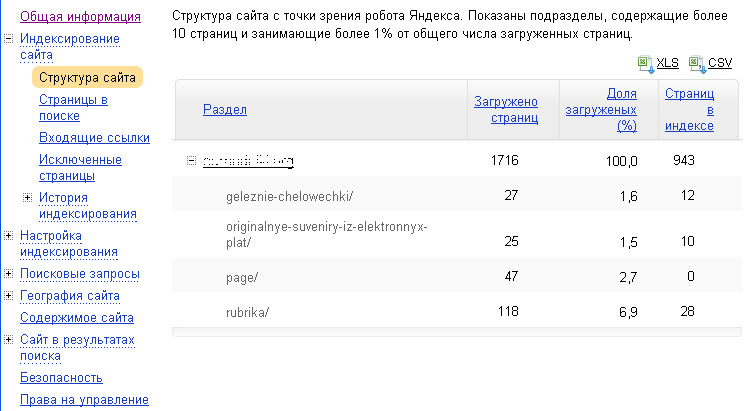

В яндексовской вебмастерке интересующая нас информация находится в разделе Индексирование → Проверить статус URL.

Перейдя в отчет «Страницы в поиске» можно ознакомиться со всеми проиндексированными страницами, посмотреть их распределение по разделам, узнать, что исключено из индекса.

Второй способ быстро проверить индексацию в Google и Яндексе — через операторы расширенного поиска. Вбиваем в поисковую строку команду site:+название домена, и получаем сведения о количестве страниц в индексе.

Аналогичным образом можно проверить не только весь сайт, но и конкретную страницу. Для этого вместо доменного имени достаточно ввести URL нужной страницы.

Аналогичным образом оператор работает в выдаче Яндекса.

Вообще, операторы расширенного поиска — очень полезная и недооцененная штука. Больше о том, какую пользу они могут принести сеошникам и вебмастерам — читайте здесь.

Почему не индексируется ресурс?

Прошло недостаточно времени. Владельцам новых сайтов, нужно запастись терпением. Нередко попадание в индекс растягивается больше, чем на две недели.

Не добавлена карта сайта. Если вы решили проигнорировать sitemap.xml, возвращайтесь наверх и читайте, как это исправить.

Запрет на индексацию в файле robots.txt. Некоторые страницы сайта советуют закрывать от индексации. Это делают через прописывание специальных директив в служебном файле robots.txt. Здесь нужно быть предельно аккуратным. Лишний символ — и можно закрыть то, что должно быть доступным для поисковых роботов. В этом случае будут проблемы.

Ошибка с метатегом “robots”. Этот элемент кода сообщает поисковым краулерам о запрете на индексацию страницы. Он помещен между тегами <head> </head>, и выглядит следующим образом:

Метатег может появиться там, где не нужно. Часто это случается при изменении настроек движка или хостинга.

Запрет на индексацию в файле .htaccess. В этом файле прописаны правила работы сервера, и через него также можно закрыть сайт от индексирования.

Тег rel=”canonical”. Этот тег используют на страницах с дублированным содержимым, указывая с его помощью поисковым роботам адрес основного документа. Если страницы не попадают в индекс, причиной может быть наличие этого тега.

X‑Robots-Tag. В файле конфигурации сервера может быть прописана директива X Robots-Tag, запрещающая индексирование документов.

Долгий или неверный ответ сервера. Критически низкий отклик сервера создает сложности поисковым роботам при обходе сайта, из-за чего часть страниц может не залететь в индекс.

Некачественный контент на страницах. Плагиат, дубли, ссылочный переспам, автоматически сгенерированные тексты — все это также создает потенциальные риски.

Как видим, причин, по которым возможны проблемы с индексированием, довольно много. Но не переживайте, все это не нужно тестить вручную. Вебмастерки регулярно оповещают о возникших ошибках. Ваша задача — следить за уведомлениями в Яндекс.Вебмастере и Google Search Console и своевременно исправлять ошибки.

Можно ли индексировать пустой сайт? Или сначала лучше наполнить его контентом?

Мы отправили на индексацию не один десяток сайтов, и убедились, что особой разницы нет. Если сайт новый.

Вы можете сделать 5-10 стартовых страниц, наполнить их контентом и забросить сайт на индексацию. А можете добавить сайт пустым, и не спеша наполнять его контентом. Это не должно отразиться на скорости и качестве индексирования. Конечно, если не растягивать наполнение этих 5-10 страниц на месяцы. А вот с чем можно повременить на первых порах — оттачивание дизайна, создание перелинковки, размещение виджетов и пр. Это не так принципиально, если вы не планируете сразу же лить рекламный трафик на сайт.

Индексирование сайта по тегу Яндекс.Метрики

Внимание. Этот метод не подходит для индексации:Робот Яндекса узнает о страницах сайта из разных источников. Один из них — тег отслеживания Яндекс.Метрики. Вы можете указать Яндексу индексировать страницы с тегом.

Для ускорения сканирования свяжите тег Яндекс.Метрики с сайтом, который вы проверили в Яндекс.Вебмастере, и включите индексацию сайта с данными тегов.

- Кто может запросить и подтвердить привязку

| Откуда отправляется запрос | Кто отправляет запрос | Кто подтверждает запрос |

|---|---|---|

| Яндекс.Веб-мастер. | Пользователь с правами управления сайтом. | Пользователь Яндекс.Метрики с правами редактирования тегов или представительским доступом. |

| Яндекс.Метрика. Узнайте больше о том, как отправить запрос в Яндекс.Метрике. | Пользователь с правами редактирования тегов или с репрезентативным доступом. | Пользователь Яндекс.Вебмастера с правами управления сайтом. |

Когда робот завершит сканирование сайта, страницы могут быть включены в результаты поиска, если им не запрещено индексировать.Чтобы помочь роботу найти все страницы, также используйте файл Sitemap.

Вы можете связать несколько доменов с одним тегом или несколько тегов на сайте. Например, вы можете связать один и тот же тег с основным доменом и субдоменом. Для этого добавьте оба сайта в Яндекс.Вебмастер и подтвердите свои права на управление сайтом.

Выберите сайт для ссылки на тег.

Перейти в раздел.

Нажмите кнопку «Добавить тег».

Укажите идентификатор тега для ссылки на сайт.Обратите внимание, что сайт должен быть указан в Яндекс.Метрике в настройках тега.

После того, как вы отправите запрос на подтверждение привязки, владелец тега Яндекс.Метрики получит уведомление по электронной почте.

Перейти к.

Рядом с тегом Яндекс.Метрики, который вы связали с сайтом, включите индексацию.

Робот сможет сканировать страницы, на которых установлен тег. Этот параметр применяется ко всем версиям сайта: по протоколу HTTP или HTTPS, с префиксом www или без него.

Во время индексации робот ищет на сайте страницы, которые могут быть включены в результаты поиска. В некоторых случаях индексация может остановиться, чтобы вы могли проверить страницы. Робот может найти много страниц, но Яндекс.Вебмастер показывает вам только примеры. Эти примеры помогут вам понять, какие группы страниц следует включать, а какие нет.

Вы получите уведомление о том, что список готов к проверке. В зависимости от ваших настроек, уведомление будет иметь следующий вид:Чтобы проверить примеры, перейдите и щелкните Примеры страниц рядом с тегом, который вы связали с сайтом.

Если вы считаете, что список включает:

- Внимательно посмотрите на список — он может включать следующие типы страниц:

Тип страницы Что мне делать? Страницы действий. Например, добавление товара в корзину или сравнение товаров. Запретить индексацию страниц Корзина с товаром. Личная информация.Например, адрес доставки и номер телефона покупателя. Ограничить доступ к данным путем аутентификации пользователей на сайте . Например, URL с дополнительными параметрами (https://example.com/page?id=1). Укажите, какая страница предпочтительнее для включения в результаты поиска Подождите, пока служба обновит список. Вы получите электронное письмо об этом на адрес, указанный в настройках уведомлений.

Еще раз проверьте образцы страниц.

Включить индексацию.

- Проверьте, готовы ли ваши страницы к показу в результатах поиска. (Содержимое завершено? Правильно ли заданы титровальный элемент и метатег «Описание»?)

Включите индексирование.