- Как устранить проблему “Проиндексировано, несмотря на блокировку в файле robots.txt” в GSC

- 8 частых ошибок в robots.txt, о которых все забывают

- Создать robots.txt онлайн

- Robots.txt — это… Что такое Robots.txt?

- Robots.txt — инструкция для SEO ➤ Что значит robots.txt

- Screaming Frog Seo Spider — подробное руководство по программе

- Настройка Screaming Frog по шагам

- File

- Configuration

- Spider — собственно, настройки парсинга сайта

- Вкладка Basic — выбираем что парсить

- Вкладка Limits — определяем лимиты парсинга

- Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

- Вкладка Advanced — дополнительные опции парсинга

- Вкладка Preferences — так называемые “предпочтения”

- Robots.txt — определяем каким правилам следовать при парсинге

- Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

- URL Rewriting — функция перезаписи URL «на лету»

- Вкладка Remove Parameters

- Вкладка Regex Replace

- Вкладка Options

- Вкладка Test

- CDNs — парсим поддомены, не отходя от кассы

- Include/Exclude — сканирование/удаление определенных папок

- Speed — регулируем скорость парсинга сайта

- User-Agent — выбираем под кого маскируемся

- Custom — дополнительные настройки поиска по исходному коду

- Custom Search

- Custom Extraction

- User Interface — обнуление настроек для колонок таблицы

- API Access — интеграция с разными сервисами

- Authentification — настройки аутентификации (если есть запрос от сайта)

- System — внутренние настройки самой программы

- Mode

- Bulk export

- Reports

- Sitemaps

- Visualisations

- Crawl Analysis

- License

- Help

- Итог

- Настройка Screaming Frog по шагам

- Все о файле «robots.txt» по-русски — как составить robots.txt

- Файл robots.txt

- Создание robots.txt

- Описание robots.txt

- Где размещать файл robots.txt

- Что писать в файл robots.txt

- Запретить весь сайт для индексации всеми роботами

- Разрешить всем роботам индексировать весь сайт

- Закрыть от индексации только несколько каталогов

- Запретить индексацию сайта только для одного робота

- Разрешить индексацию сайта одному роботу и запретить всем остальным

- Запретить к индексации все файлы кроме одного

- Инфографика

- Проверка

- О сайте

- Отправить обновленный файл Robots.txt в Google

- Инструменты Bing для веб-мастеров упрощают редактирование и проверку ваших роботов.txt

- urllib.robotparser — Парсер для robots.txt — документация Python 3.9.7

- Nuro строит испытательный полигон, завод по производству роботов для доставки в Лас-Вегасе

- Автономные роботы проверяют плохое поведение в центре Сингапура, Сингапурские новости и популярные новости

- Фонд зеленых технологий Билла Гейтса делает ставку на сельскохозяйственных роботов Кремниевой долины

- Как исправить "проиндексировано, но заблокировано файлом robots.txt" в GSC

Как устранить проблему “Проиндексировано, несмотря на блокировку в файле robots.txt” в GSC

Предупреждение “Проиндексировано, несмотря на блокировку в файле robots.txt” отображается в Google Search Console (GSC), если Google проиндексировал URL-адрес, хотя его сканирование было заблокировано.

В большинстве случаев, если вы заблокировали сканирование в своем файле robots.txt, это является очевидной проблемой. Но есть несколько дополнительных условий, которые могут вызвать эту проблему, поэтому давайте рассмотрим следующий процесс устранения неполадок, который поможет выявлять и исправлять существующие проблемы как можно более эффективно.

Как видите, первым делом нужно спросить себя, хотите ли вы, чтобы Google индексировал URL-адрес.

Если вы не хотите, чтобы URL-адрес индексировался…

Просто добавьте атрибут noindex в метатег robots и убедитесь, что сканирование разрешено, если адрес каноничный.

Если вы заблокируете сканирование страницы, Google все равно сможет проиндексировать ее, потому что сканирование и индексирование — это разные процессы. Если Google не может сканировать страницу, они не увидят атрибут noindex в метатеге и все равно смогут проиндексировать страницу, если на ней есть ссылки.

Если Google не может сканировать страницу, они не увидят атрибут noindex в метатеге и все равно смогут проиндексировать страницу, если на ней есть ссылки.

Если URL-адрес каноникализируется на другую страницу, не добавляйте атрибут noindex в метатег robots. Просто убедитесь, что настроены правильные сигналы каноникализации, включая атрибут canonical на канонической странице, и разрешите сканирование, чтобы сигналы проходили и консолидировались правильно.

Если вы хотите, чтобы URL-адрес индексировался…

Вам нужно выяснить, почему Google не может просканировать URL-адрес и снять блокировку.

Наиболее вероятная причина — блокировка сканирования в robots.txt. Но есть несколько других сценариев, которые могут вызывать предупреждение о том, что вы заблокированы. Давайте рассмотрим их в том порядке, в котором вам, вероятно, стоит их искать.

- Проверьте наличие блокировки сканирования в robots.txt

- Проверьте наличие периодической блокировки

- Проверьте наличие блокировки по user-agent

- Проверьте наличие блокировки по IP-адресу

Проверьте наличие блокировки сканирования в robots.

txt

txtСамый простой способ выявить эту проблему — использовать средство проверкиrobots.txt в GSC, которое покажет правило блокировки.

Если вы знаете, что ищете, или у вас нет доступа к GSC, вы можете перейти по адресу домен.com/robots.txt, чтобы найти файл. Дополнительную информацию вы можете найти в нашей статье о robots.txt, но вы, вероятно, ищете директиву disallow, например:

Disallow: /

Директива может блокировать какой-то конкретный или все user-agent. Если ваш сайт новый или был запущен недавно, вы можете поискать:

User-agent: *

Disallow: /

Не можете найти проблему?

Возможно, кто-то опередил вас и уже устранил блокировку robots.txt, чем и решил проблему. Это наилучший сценарий. Однако, если проблема выглядит исправленной, но появляется снова спустя какое-то время, возможно, вы испытываете проблемы из-за периодической блокировки.

Как это исправить

Вам нужно удалить директиву disallow, вызывающую блокировку. Способ исправления проблемы зависит от используемой вами технологии.

Способ исправления проблемы зависит от используемой вами технологии.

WordPress

Если проблема затрагивает весь ваш веб-сайт, наиболее вероятная причина в том, что вы включили параметр в WordPress, отвечающий за запрет индексации. Эта ошибка часто встречается на новых веб-сайтах и после проведения миграции. Выполните следующие действия, чтобы проверить это.

- Нажмите “Настройки” (Settings)

- Нажмите “Чтение” (Reading)

- Снимите флажок “Видимость в поисковых системах” (Search Engine Visibility).

WordPress с Yoast

Если вы используете плагинYoast SEO, вы можете напрямую отредактировать файл robots.txt, чтобы удалить директиву блокировки.

- Нажмите на Yoast SEO

- Нажмите “Инструменты” (Tools)

- Нажмите “Редактор файлов” (File editor)

WordPress с Rank Math

Как и Yoast, Rank Math позволяет напрямую редактировать файл robots.txt.

- Нажмите на Rank Math

- Нажмите “Общие настройки” (General Settings)

- Нажмите “Редактировать robots.

txt” (Edit robots.txt)

txt” (Edit robots.txt)

FTP или хостинг

Если у вас есть FTP-доступ к сайту, вы можете напрямую отредактировать файл robots.txt, чтобы удалить директиву disallow, вызывающий проблему. Ваш хостинг-провайдер также может предоставлять вам доступ к файловому менеджеру, с помощью которого вы можете напрямую обращаться к файлу robots.txt.

Проверьте наличие периодической блокировки

Периодические проблемы труднее устранить, поскольку условия, вызывающие блокировку, могут не присутствовать в момент проверки.

Я рекомендую проверить историю вашего файла robots.txt. Например, в средстве проверки robots.txt в GSC хранятся предыдущие версии файлов. Вы можете нажать на раскрывающийся список, выбрать версию и посмотреть ее содержимое.

У The Wayback Machine на archive.org также хранится история файлов robots.txt для веб-сайтов, которые они сканируют. Вы можете щелкнуть любую дату, по которой у них есть данные, и посмотреть, как выглядел файл в этот конкретный день.

Вы также можете воспользоваться бета-версией отчета “Изменения” (Changes), который позволяет легко просматривать изменения содержимого между двумя разными версиями файлов.

Как это исправить

Процесс исправления периодической блокировки будет зависеть от того, что вызывает проблему. Например, одной из возможных причин может быть общий кэш между тестовой средой и действующей средой. Файл robots.txt может содержать директиву блокировки, когда кэш используется тестовой средой. А когда кэш используется действующей средой, сайт может разрешать сканирование. В таком случае вы захотите разделить кэш или, возможно, исключить из кэша файлы з разрешением .TXT в тестовой среде.

Проверьте наличие блокировки по user-agent

Блокировка по user-agent — это блокировка, при которой сайт блокирует определенный user-agent, такого как Googlebot или AhrefsBot. Другими словами, сайт определяет конкретного бота и блокирует соответствующий user-agent.

Если вы можете просматривать страницу в своем обычном браузере, но блокируетесь после смены user-agent, это означает, что используемый вами user-agent заблокирован.

Вы можете задать конкретный user-agent с помощью инструментов разработчика Chrome. Еще один вариант — использовать расширение браузера для смены user-agent, подобное этому.

Кроме того, вы можете проверить блокировку по user-agent с помощью команды cURL. Вот как это сделать в Windows.

- Нажмите клавиши Windows+R, чтобы открыть окно “Выполнить”.

- Введите “cmd” и нажмите “ОК”.

- Введите команду cURL, подобную этой:

curl -A “имя-user-agent -Lv [URL]

curl -A “Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/)” -Lv https://ahrefs.com

Как это исправить

К сожалению, это еще один случай, когда процесс исправления будет зависеть от того, где вы найдете блокировку. Бота может блокировать множество разных систем, в том числе .htaccess, конфигурация сервера, брандмауэр, CDN или даже что-то, к чему вас нет доступа. Например то, что контролирует ваш хостинг-провайдер. Лучше всего будет обратиться к вашему хостинг-провайдеру или CDN и спросить их, откуда происходит блокировка и как вы можете устранить ее.

Например, вот два разных способа блокировки по user-agent в .htaccess, которые вам, возможно, придется искать.

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} Googlebot [NC]

RewriteRule .* - [F,L]

или…

BrowserMatchNoCase "Googlebot" bots

Order Allow,Deny

Allow from ALL

Deny from env=bots

Проверьте наличие блокировки по IP-адресу

Если вы подтвердили, что не заблокированы файлом robots.txt, и исключили блокировку по user-agent, то, скорее всего, это блокировка по IP-адресу.

Как это исправить

Блокировку по IP-адресу сложно отследить. Как и в случае с блокировкой по user-agent, лучше всего будет обратиться к вашему хостинг-провайдеру или CDN и спросить их, откуда происходит блокировка и как вы можете устранить ее.

Вот один пример того, что вы можете искать в .htaccess:

deny from 123.123.123.123

Заключение

В большинстве случаев предупреждение “Проиндексировано, несмотря на блокировку в файле robots. txt” является результатом блокировки в файле robots.txt. Надеюсь, это руководство помогло вам найти и исправить проблему.

txt” является результатом блокировки в файле robots.txt. Надеюсь, это руководство помогло вам найти и исправить проблему.

Остались вопросы? Дайте знать в Twitter.

Перевела Олеся Коробка, владелец Fajela.com

8 частых ошибок в robots.txt, о которых все забывают

Содержание:

Как обнаружить и исправить ошибки в файле robots.txt

Каждый уважающий себя веб-мастер должен иметь хотя бы общее представление о том, как управлять процессом индексации страниц и файлов сайта в поисковых системах.

Не будем тянуть резину и сразу отметим, что для нахождения общего языка с поисковыми роботами достаточно правильно настроить robots.txt. Ключевое слово – «правильно». Ведь если допустить в robots.txt ошибки, последствия могут быть довольно неприятными.

Самые частые ошибки файла robots.txt

- Перепутанные значения директив (по незнанию или по недосмотру).

- Перечисление нескольких URL в одной директиве Disallow.

- Название файла robots.txt с ошибками.

- В названии файла robots.txt присутствуют заглавные буквы.

- Пустое поле в User-agent.

- Отсутствующая директива Disallow.

- Неправильный формат URL в директиве Disallow.Ошибка в файле robots.txt на левой половине скриншота приведет к тому, что от индексации будут закрыты все страницы и файлы, в начале URL которых содержится «admin».Все будет указано правильно, если использовать символы «$» и «/» для указания «разрыва».

- Перечисление всех файлов директории. В принципе это не совсем ошибка. Просто рациональнее в этом случае закрыть от индексации всю директорию целиком.

Принципы, которым нужно следовать, чтобы предотвратить ошибки в файле robots.txt

- Прописанные в robots.txt директивы являются рекомендациями, которых придерживаются лишь роботы крупных поисковых систем. Сторонние боты чаще всего на них внимания не обращают. Поэтому их лучше блокировать по IP.

- Заблокированные в robots.txt страницы все еще продолжают быть доступными интернет-пользователям. Поэтому если цель – скрыть веб-страницу не только от роботов, но и от пользователей, на нее нужно установить пароль.

- robots.txt нечувствителен к регистру. Поэтому директивы можно писать как строчными, так и прописными. Но имена файлов и директорий должны прописываться только так, как они выглядят в адресной строке браузера.

- Указанный в директиве User-agent реагирует на все указанные под ним директивы вплоть до следующей строки с User-agent. Поэтому не стоит надеяться, что директивы под вторым User-agent будут выполнены роботом, указанным в первом User-agent. Для каждого робота указания нужно дублировать.

Проверка robots.txt на ошибки

Чтобы проверить robots.txt на ошибки, проще всего воспользоваться предназначенными для этого инструментами от поисковых систем.

В случае с Google нужно зайти в Search Console/Сканирование и выбрать «Инструмент проверки файла robots.txt».

Под окном с содержимым искомого файла можно увидеть количество ошибок и предупреждений.

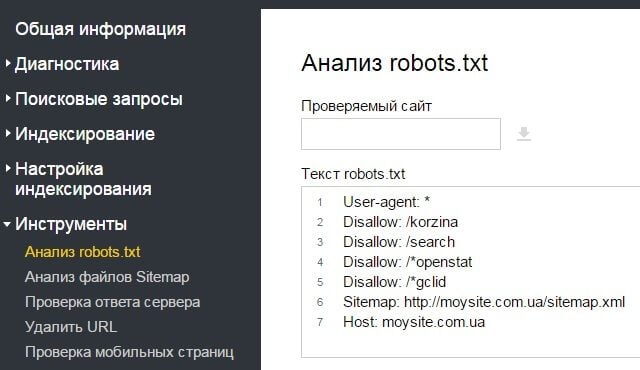

В Яндекс.Вебмастере имеется аналогичный функционал (Инструменты/Анализ robots.txt).

Также имеется возможность узнать, сколько в проверяемом robots. txt ошибок.

txt ошибок.

Правда, если обе проверки покажут, что ошибок нет, это еще не повод радоваться. Это лишь значит, что прописанные в файле инструкции соответствуют стандартам.

Но в нем вполне могут быть многие из вышеописанных ошибок, которые приведут к проблемам с индексацией сайта. Поэтому при проверке robots.txt на ошибки не стоит полагаться лишь на подобные автоматизированные инструменты – нужно и самому все внимательно проверять.

Создать robots.txt онлайн

Чтобы активировать

PRO версию программы достаточно только нажать и поделиться страницей через социальные сети выше. Robots.txt является обыкновенным текстовым файлом, располагающимся в корне вашего сайта, просмотреть и отредактировать его можно используя любой текстовый редактор. В данном файлике записаны инструкции, которыми должны руководствоваться поисковые машины (роботы). Собственно, отсюда и пошло название этого документа. Инструкции эти указывают поисковику, что подлежит индексированию, а что трогать не нужно. Наверное, каждый вебмастер хотел бы, чтобы созданный им сайт как можно быстрее был проиндексирован поисковой системой, причем чтобы этот процесс прошел правильно и без ошибок. Поэтому, нужно понимать, что без грамотно составленного

Собственно, отсюда и пошло название этого документа. Инструкции эти указывают поисковику, что подлежит индексированию, а что трогать не нужно. Наверное, каждый вебмастер хотел бы, чтобы созданный им сайт как можно быстрее был проиндексирован поисковой системой, причем чтобы этот процесс прошел правильно и без ошибок. Поэтому, нужно понимать, что без грамотно составленного  Здесь вам нужно будет указать местонахождение карты вашего сайта, а если у вас ее нету, то можно просто не заполнять данное поле. Далее вы можете выбрать поисковые системы, которым дадите право проводить индексирование страниц вашего ресурса. Рекомендуется выбирать все, это даст наиболее положительный эффект в плане посещаемости сайта. В перечне присутствуют все основные поисковые машины. Далее вам предлагается указать те страницы, которые вы бы не хотели видеть в индексе поисковиков. На этом все, ваш файлик готов, можете выкладывать его к себе на сайт.

Здесь вам нужно будет указать местонахождение карты вашего сайта, а если у вас ее нету, то можно просто не заполнять данное поле. Далее вы можете выбрать поисковые системы, которым дадите право проводить индексирование страниц вашего ресурса. Рекомендуется выбирать все, это даст наиболее положительный эффект в плане посещаемости сайта. В перечне присутствуют все основные поисковые машины. Далее вам предлагается указать те страницы, которые вы бы не хотели видеть в индексе поисковиков. На этом все, ваш файлик готов, можете выкладывать его к себе на сайт.Есть ли какие-то отличия Robots.txt для Яндекса в сравнении с файлами для других роботов?

На самом деле каждая поисковая машина использует разные методы индексирования, и вообще работают они по-разному. Каждый поисковик имеет свои методики ранжирования, присвоения сайтам определенного места в своем списке. Однако, практически все они одинаково индексируют и понимают файл Robots.txt. Практика свидетельствует, что один файл Robots.

Есть ли возможность проверить существующий файл Robots.txt?

Если вы сами писали данный файл, или использовали другой генератор, и сомневаетесь в его работоспособности, то можете проверить его с помощью специального сервиса на нашем сайте. Если в ходе такой проверки обнаружатся те или иные проблемы, то вы с легкостью сможете сгенерировать новый файлик воспользовавшись нашим инструментом. Специалисты всегда рекомендуют проверять самодельные файлы Robots.txt с помощью уже проверенных генераторов, чтобы избежать возможных проблем в будущем.Robots.txt — это… Что такое Robots.txt?

robots.txt

Использование файла добровольно. Стандарт был принят консорциумом 30 января 1994 года в списке рассылки [email protected] и с тех пор используется большинством известных поисковых машин.

Файл robots.txt используется для частичного управления индексированием сайта поисковыми роботами. Этот файл состоит из набора инструкций для поисковых машин, при помощи которых можно задать файлы, страницы или каталоги сайта, которые не должны индексироваться.

Файл robots.txt может использоваться для указания расположения файла и может показать, что именно нужно, в первую очередь, проиндексировать поисковому роботу.

Описание структуры

Файл состоит из записей. Записи разделяются одной или более пустых строк (признак конца строки: символы CR, CR+LF, LF). Каждая запись содержит непустые строки следующего вида:

<поле>:<необязательный пробел><значение><необязательный пробел>

где поле — это либо User-agent, либо Disallow.

Сравнение производится методом простого поиска подстроки. Например, запись Disallow: /about запретит доступ как к разделу http://example.com/about/, так и к файлу http://example.com/about.php, а запись Disallow: /about/ — только к разделу http://example.com/about/.

Проверка синтаксиса

Для проверки синтаксиса и структуры файла robots.txt существует ряд специализированных онлайн-служб.

Существует специализированная поисковая система BotSeer, которая позволяет осуществлять поиск по файлам robots.txt.

Примеры

Запрет доступа всех роботов ко всему сайту:

User-agent: * Disallow: /

Запрет доступа определенного робота к каталогу /private/:

User-agent: googlebot Disallow: /private/

Нестандартные директивы

Crawl-delay: устанавливает время, которое робот должен выдерживать между загрузкой страниц. Если робот будет загружать страницы слишком часто, это может создать излишнюю нагрузку на сервер. Впрочем, современные поисковые машины по умолчанию задают достаточную задержку в 1-2 секунды.

Впрочем, современные поисковые машины по умолчанию задают достаточную задержку в 1-2 секунды.

User-agent: * Crawl-delay: 10

Allow: имеет действие, обратное директиве Disallow — разрешает доступ к определенной части ресурса. Поддерживается всеми основными поисковиками. В следующем примере разрешается доступ к файлу photo.html, а доступ поисковиков ко всей остальной информации в каталоге /album1/ запрещается.

Allow: /album1/photo.html Disallow: /album1/

Расширенный стандарт

В 1996 году был предложен расширенный стандарт robots.txt, включающий такие директивы как Request-rate и Visit-time. Например:

User-agent: * Disallow: /downloads/ Request-rate: 1/5 # загружать не более одной страницы за пять секунд Visit-time: 0600-0845 # загружать страницы только в промежуток с 6 утра до 8:45 по Гринвичу.

Особенности поддержки стандарта поисковыми роботами

Рамблер поддерживает только базовый вариант стандарта — только директивы User-agent и Disallow

См. также

Ссылки

Robots.txt — инструкция для SEO ➤ Что значит robots.txt

Файл robots.txt часто не замечают. Или действуют по принципу «не знал, не знал, да и забыл».

Хотя именно robots.txt – важная часть любого набора инструментов SEO, независимо от того, новичок вы в этой отрасли или уже матерый ветеран-оптимизатор.

Что такое файл robots.txt?

Файл robots.txt показывает важную информацию для поисковых роботов, которые сканируют интернет. Перед тем как проверить все страницы вашего сайта, поисковые роботы проверяют данный файл.

Robots.txt еще указывает поисковой системе на то, какие страницы сканировать, а какие нет. А еще это отличный инструмент для управления краулингового бюджета вашего сайта.

Вы, наверное, спрашиваете себя: «Минуточку, а что вообще такое краулинговый бюджет?» Краулинговый бюджет – это то, что использует Google для эффективного сканирования и индексации сайта. Как бы ни был велик Google, у него все еще маловато ресурсов для сканирования и индексирования контента такого количества сайтов, которое есть сейчас.

Если у вашего сайта есть всего лишь несколько сотен URL, то Google без проблем сможет сканировать и индексировать страницы вашего сайта.

Но если ваш сайт большой (как, например, интернет-магазин), и у вас тысячи страниц с огромным количеством автоматически сгенерированных URL, тогда Google может не сканировать все эти страницы, и вы потеряете кучу потенциального трафика.

Это именно тот момент, когда нужно подсказать, что, когда и сколько нужно сканировать.

В Google сообщили, что «наличие множества url-адресов с низким качеством наполнения плохо влияет на сканирование и индексацию сайта». Вот где наличие файла robots.txt может помочь с факторами, влияющими на краулинговый бюджет вашего сайта.

Вы можете использовать этот файл для управления краулинговым бюджетом, будучи уверенным, что поисковые системы используют время на вашем сайте настолько эффективно (особенно если у вас большой сайт), насколько это возможно, и что они сканируют только важные страницы и не теряют время на такие страницы, как страница входа, регистрации или страница благодарности.

Для чего нужен robots.txt?

Прежде чем поисковый робот, такой, как Googlebot, Bingbot и др., сканирует веб-страницу, он сначала проверяет, существует ли на самом деле файл robots.txt. А уж если такой файл есть, то поисковый робот, как правило, будет следовать указаниям из этого файла.

Файл robots.txt может быть мощным инструментом в любом арсенале SEO, поскольку это отличный способ контролировать то, как именно поисковые роботы/боты получают доступ к определенным областям вашего сайта.

Важно! Вы должны быть уверены, что понимаете, как работает файл robots.txt, иначе вы случайно запретите роботу Googlebot или любому другому боту сканировать весь ваш сайт, и тогда ваш веб-ресурс не будет отражаться в результатах поиска.

Но когда все сделано правильно, вы можете контролировать такие вещи, как:

- Блокировка доступа ко всем разделам вашего сайта (среда разработки, промежуточная среда и т. д.).

- Предотвращение сканирования, индексации или отображения страниц результатов внутреннего поиска на ваших сайтах.

- Указание местоположения вашей карты или карт сайта.

- Оптимизация бюджета сканирования путем блокировки доступа к страницам низкого качества (вход в систему, благодарности, корзины покупок и т. д.).

- Предотвращение индексирования определенных файлов на вашем сайте (изображений, PDF-файлов и т. д.).

Примеры robots.txt

Ниже приведу парочку примеров того, как вы можете использовать файл robots.txt на вашем сайте.

Разрешение всем поисковым системам/роботам на доступ ко всему контенту вашего сайта:

Блокировка доступа всех поисковых систем/роботов ко всему контенту вашего сайта:

User-agent: *

Disallow: /

Вы можете увидеть, что очень легко допустить ошибку при создании robots.txt для веб-ресурса, когда различием между блокировкой целого сайта от разрешения полного доступа является лишь слеш в директиве disallow (Disallow: /).

Блокировка доступа определенной поисковой системе/роботу к определенной папке:

User-agent: Googlebot

Disallow: /

Блокировка доступа поисковым системам/роботам к определенной странице на вашем сайте:

User-agent:

Disallow: /thankyou.html

Запрет на доступ к определенным папкам сайта для всех поисковых систем/роботов:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /junk/

Вот пример того, как выглядит файл robots.txt на сайте theverge.com:

Вот так корректнее:

1 – theverge.com не хочет, чтобы Googlebot News сканировал любой из этих каталогов на сайте.

2 – theverge.com блокирует доступ всем роботам к сканированию этих каталогов на сайте.

3 – theverge.com перечислил размещение всех карт сайта в их файле robots.txt.

Этот же пример файла можно найти здесь: www.theverge.com/robots.txt.

В примере видно, как The Verge использует файл robots.txt, чтобы ограничить сканирование определенных каталогов на сайте новостным роботом Google «Googlebot-News».

Важно помнить, что если вы хотите быть уверены, что боты не сканируют определенные страницы или каталоги на сайте, то их нужно перечислить в описании «Disallow» в вашем файле robots.txt, как в примере выше.

Также вы можете больше узнать, как Google работает с robots.txt в их руководстве по спецификации robots.txt. Google имеет максимальный лимит на размер файла robots.txt – 500KB, так что важно помнить о размере robots.txt на вашем сайте.

Как создать robots.txt

Создание файла – достаточно простой процесс, но в нем очень легко допустить ошибку. Не позволяйте этому препятствовать вам создавать или модифицировать robots для вашего сайта. Эта справка от Google расскажет о процессе создания файла от и до, и поможет с легкостью создать вам свой собственный robots.txt.

Если вы освоили правила создания и редактирования robots, у Google есть также рекомендации, которые объяснят, как протестировать ваш файл robots.txt и проверить, правильно ли он настроен.

Проверьте, есть ли у вас файл robots.txt

Если вы новичок в robots.txt, или не уверены, есть ли у вашего сайта такой файл, вы можете сделать быструю проверку. Все, что вам нужно, это перейти к домену вашего сайта и добавить /robots.txt в конец вашего URL. Например: www.yoursite.com/robots.txt

Если ничего не происходит, значит, у вас его нет. То есть сейчас самое время заняться его созданием.

Возьмите на заметку:

- Убедитесь, что все важные страницы можно просканировать, а контент, не представляющий реальной ценности, заблокирован.

- Не блокируйте JavaScript и файлы CSS.

- Всегда проверяйте файл, чтобы удостовериться, что в нем ничего не изменилось.

- Используйте правильный регистр каталогов, подкаталогов и файловых имен.

- Поместите файл robots.txt в корневой каталог сайта, чтобы его можно было найти.

- Robots.txt чувствителен к регистру, он должен быть записан только как «robots.txt» и никак иначе.

- Не используйте файл robots.txt, чтобы скрыть персональную информацию, потому что она все еще будет видима.

- Добавьте в файл адрес размещения карты сайта.

- Убедитесь, что вы не блокируете контент или страницы, которые вы хотите сканировать.

На что обратить внимание:

Если у вас есть субдомен или несколько субдоменов на сайте, тогда вам нужно иметь файл robots.txt на каждом из них, так же, как и в основном домене. Выглядит это примерно так: store.yoursite.com/robots.txt и yoursite.com/robots.txt.

Важно помнить, что лучше не использовать robots.txt для предотвращения сканирования такой информации, как персональная информация пользователей.

Причиной является то, что другие страницы могут ссылаться на эту информацию, и тогда появится обратная прямая ссылка, которая обойдет правила файла robots.txt, и тогда контент все равно может быть проиндексирован.

Если вам нужно заблокировать ваши страницы от индексации в результатах поиска, используйте разные методы, такие, как защита паролем или добавления мета-тега «noindex» на эти страницы. Google не пройдет на страницу или сайт, защищенный паролем, поэтому не сможет сканировать или индексировать эти страницы.

Если не можете сделать сами, делегируйте

Если вы все еще немного нервничаете, что никогда раньше не работали с файлом robots.txt, расслабьтесь – он достаточно прост в использовании. Когда вы освоите правила работы с файлом, вы сможете улучшить SEO вашего сайта, а также помочь посетителям и роботам поисковых систем.

А если у вас не получается, то всегда есть СПРАВА. Поможем улучшить видимость важных страниц вашего сайта! Обращайтесь!

Используя robots.txt правильно, вы поможете роботам поисковых систем расходовать их краулинговый бюджет с умом и сканировать только важные страницы. Тогда роботы не будут тратить время и ресурсы на страницы, которые не нужно сканировать. Это поможет роботам организовать и показывать ваш контент в поисковой выдаче, что, в свою очередь, означает, что у вас будет лучшая видимость.

Не забывайте, что установка файла не всегда требует много времени. По большей части сделать это нужно только один раз, а потом уже редактировать файл в зависимости от ваших нужд.

Надеюсь, что практики, советы и предложения, описанные в этой статье, помогут вам быть более уверенными в создании/изменении robots.txt для вашего сайта, а также упростят процесс работы с файлом.

Screaming Frog Seo Spider — подробное руководство по программе

Attention! Много букв! Много скринов! Много смысла!Доброго времени суток, друзья. Сегодня я хочу рассказать вам о настройке Screaming Frog (он же SF, он же краулер, он же паук, он же парсер — сразу определимся со всеми синонимами, ок?).

SF — очень полезная программа для анализа внутрянки сайтов. С помощью этой утилиты можно быстро выцепить технические косяки сайта, чтобы составить грамотное ТЗ на доработку. Но чтобы увидеть проблему, надо правильно настроить краулера, верно? Об этом мы сегодня с вами и поговорим.

- Примечание автора: сразу скажу — программа имеет много вкладок и настроек, которые по сути не нужны рядовому пользователю, потому я подробно опишу только наиболее важные моменты, а второстепенные пройдем вскользь… хотя кого я обманываю, когда это у меня были статьи меньше 30 к символов? *Зануда mode on*

- Примечание автора 2: при написании статьи я пользовался дополнительными материалами в виде официального мануала от разработчиков. Если что, почитать его можно тут https://www.screamingfrog.co.uk/seo-spider/user-guide/. Не пугайтесь английского, Google-переводчик в помощь — вполне себе сносная адаптация получается.

- Примечание автора 3: я люблю оставлять примечания…

Настройка Screaming Frog по шагам

Рассмотрим основное меню программы, для того чтобы понимать что где лежит и что за что отвечает (тавтология… Вова может в копирайт!).Верхнее меню — управление парсингом, выгрузкой и многое другое

File

Из названия понятно, что это работа с файлами программы (загрузка проектов, конфиги, планирование задач — что-то вроде того).- Open — открыть файл с уже проведенным парсингом.

- Open Recent — открыть последний парсинг (если вы его сохраняли отдельным файлом).

- Save — собственно, сохранить парсинг.

- Configuration — загрузка/сохранение специальных настроек парсинга вроде выведения дополнительных параметров проверки и т.д. (про то, как задавать эти настройки, я далее расскажу подробнее).

- Crawl Recent — повторно парсить один из последних сайтов, который уже проверялся в этой программе.

- Scheduling — отложенное планирование задач для программы… ни разу не пользовался этой опцией…стыдно.

- Exit — призвать к ответу Друзя… нет, ну серьезно,тут все очевидно.

Configuration

Один из самых интересных и важных пунктов меню, тут мы задаем настройки парсинга.Ох, сейчас будет сложно — у многих пунктов есть подпункты, у этих подпунктов всплывающие окна с вкладками и кучей настроек…в общем крепитесь, ребята, будет много инфы.

Spider — собственно, настройки парсинга сайта

Вкладка Basic — выбираем что парсить

- Check Images — в отчет включаем анализ картинок.

- Check CSS — в отчет включаем анализ css-файлов (скрипты).

- Check JavaScript — в отчет включаем анализ JS-файлов (скрипты).

- Check SWF — в отчет включаем анализ Flash-анимации.

- Check External Link — в отчет включаем анализ ссылок с сайта на другие ресурсы.

- Check Links Outside of Start Folder — проверка ссылок вне стартовой папки. Т.е. отчет будет только по стартовой папке, но с учетом ссылок всего сайта.

- Follow internal “nofollow” — сканировать внутренние ссылки, закрытые в тег “nofollow”.

- Follow external “nofollow” — сканировать ссылки на другие сайты, закрытые в тег “nofollow”.

- Crawl All Subdomains — парсить все поддомены сайта, если ссылки на них встречаются на сканируемом домене.

- Crawl Outside of Start Folder — позволяет сканировать весь сайт, однако проверка начинается с указанной папки.

- Crawl Canonicals — выведение в отчете атрибута rel=”canonical” при сканировании страниц.

- Crawl Next/Prev — выведение в отчете атрибутов rel=”next”/”prev” при сканировании страниц пагинации.

- Extract hreflang/Crawl hreflang — при сканировании учитываются языковой атрибут hreflang и отображаются коды языка и региона страницы + формирование отчета по таким страницам.

- Extract AMP Links/Crawl AMP Links — извлечение в отчет ссылок с атрибутом AMP (определение версии контента на странице).

- Crawl Linked XML Sitemap — сканирование карты сайта. Тут краулер либо берет sitemap из robots.txt (Auto Discover XML Sitemap via robots.txt), либо берет карту по указанному пользователем пути (Crawl These Sitemaps).

Вкладка Limits — определяем лимиты парсинга

- Limit Crawl Total — задаем лимиты страниц для сканирования. Сколько всего страниц выгружаем для одного проекта.

- Limit Crawl Depth — задаем глубину парсинга. До какого уровня может дойти краулер при сканировании проекта.

- Limit Max Folder Depth — можно контролировать глубину парсинга вплоть до уровня вложенности папки.

- Limit Number of Query Strings — тут, если честно, сам не до конца разобрался, потому объясню так, как понял — мы ограничиваем лимит страниц с параметрами. Другими словами, если на одной статической странице есть несколько фильтров, то их комбинация может породить огромное количество динамических страниц. Вот чтобы такие “полезные” страницы не парсились (увеличивает время анализа в разы, а толковой информации по сути ноль), мы и выводим лимиты по Query Strings. Пример динамики — site.ru/?query1&query2&query3&queryN+1.

- Max Redirects to Follow — задаем максимальное количество редиректов, по которым паук может переходить с одного адреса.

- Max URL Length to Crawl — максимальная длина URL для обхода (указываем в символах, я так понимаю).

- Max Links per URL to Crawl — максимальное количество ссылок на URL для обхода (указываем в штуках).

- Max Page Size (KB) to Crawl — максимальный размер страницы для обхода (указываем в килобайтах).

Вкладка Rendering — настраиваем параметры рендеринга (только для JS)

На выбор три опции — “Text Only” (паук анализирует только текст страницы, без учета Аякса и JS), “Old AJAX Crawling Scheme” (проверяет по устаревшей схеме сканирования Аякса) и “JavaScript” (учитывает скрипты при рендеринге). Детальные настройки есть только у последнего, их и рассмотрим.

- Enable Rendered Page Screen Shots — SF делает скриншоты анализируемых страниц и сохраняет их в папке на ПК.

- AJAX Timeout (secs) — лимиты таймаута. Как долго SEO Spider должен разрешать выполнение JavaScript, прежде чем проверять загруженную страницу.

- Window Size — выбор размера окна (много их — смотрим скриншот).

- Sample — пример окна (зависит от выбранного Window Size).

- Чекбокс Rotate — повернуть окно в Sample.

Вкладка Advanced — дополнительные опции парсинга

- Allow Cookies — учитывать Cookies, как это делает поисковый бот.

- Pause on High Memory Used — тормозит сканирование сайта, если процесс забирает слишком много оперативной памяти.

- Always Follows Redirect — разрешаем краулеру идти по редиректам вплоть до финальной страницы с кодом 200, 4хх, 5хх (по факту все ответы сервера, кроме 3хх).

- Always Follows Canonicals — разрешаем краулеру учитывать все атрибуты “canonical” вплоть до финальной страницы. Полезно, если на страницах сайта бардак с настройкой этого атрибута (например, после нескольких переездов).

- Respect Noindex — страницы с “noindex” не отображаются в отчете SF.

- Respect Canonical — учет атрибута “canonical” при формировании итогового отчета. Полезно, если у сайта много динамических страниц с настроенным rel=”canonical” — позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Respect Next/Prev — учет атрибутов rel=”next”/”prev” при формировании итогового отчета. Полезно, если у сайта есть страницы пагинации с настроенными “next”/”prev”- позволяет убрать из отчета дубли по метаданным (т.к. на страницах настроен нужный атрибут).

- Extract Images from img srscet Attribute — изображения извлекаются из атрибута srscet тега <img>. SRSCET — атрибут, который позволяет вам указывать разные типы изображений для разных размеров экрана/ориентации/типов отображения.

- Respect HSTS Policy — если чекбокс активен, SF будет выполнять все будущие запросы через HTTPS, даже если перейдет по ссылке на URL-адрес HTTP (в этом случае код ответа будет 307). Если же чекбокс неактивен, краулер покажет «истинный» код состояния за перенаправлением (например, постоянный редирект 301).

- Respect Self Referencing Meta Refresh — учитывать принудительную переадресацию на себя же (!) по метатегу Refresh.

- Response Timeout — время ожидания ответа страницы, перед тем как парсер перейдет к анализу следующего урла. Можно сделать больше (для медленных сайтов), можно меньше.

- 5хх Response Retries — количество попыток “достучаться” до страниц с 5хх ответом сервера.

- Store HTML — можно сохранить статический HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть его до того, как JavaScript “вступит в игру”.

- Store Rendered HTML — позволяет сохранить отображенный HTML-код каждого URL-адреса, просканированного SEO Spider, на диск и просмотреть DOM после обработки JavaScript.

- Extract JSON-LD — извлекаем микроразметку сайта JSON-LD. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract Microdata — извлекаем микроразметку сайта Microdata. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

- Extract RDFa — извлекаем микроразметку сайта RDFa. При выборе — дополнительные чекбоксы с типами валидации микроразметки (Schema.org, Google Validation, Case-Sensitive).

Вкладка Preferences — так называемые “предпочтения”

Здесь задаем желаемые параметры для некоторых сканируемых элементов (title, description, url, h2, h3, alt картинок, размер картинок). Соответственно, если сканируемые элементы сайта не будут соответствовать нашим предпочтениям, программа нам об этом сообщит в научно-популярной форме. Совершенно необязательные настройки — каждый прописывает для себя свой идеал… или вообще их не трогает, от греха подальше (как делаю я).- Page Title Width — оптимальная ширина заголовка страницы. Указываем желаемые размеры от и до в пикселях и в символах.

- Meta Description Width — оптимальная ширина описания страницы. Аналогично, как и с тайтлом, указываем желаемые размеры.

- Other — сюда входит максимальная желаемая длина урл-адреса в символах (Max URL Length Chars), максимальная длина h2 в символах (Max h2 Length Chars), максимальная длина h3 в символах (Max h3 Length Chars), максимальная длина ALT картинок в символах (Max Image Length Chars) и максимальный вес картинок в КБ (Max Image Size Kilobytes).

Robots.txt — определяем каким правилам следовать при парсинге

Вкладка Settings — настраиваем парсинг относительно правил robots.txt

- Respect robots.txt — следуем всем правилам, прописанным в robots.txt. Т.е. учитываем в анализе те папки и файлы, которые открыты для робота.

- Ignore robots.txt — не учитываем robots.txt сайта при парсинге. В отчет попадают все папки и файлы, относящиеся к домену.

- Ignore robots.txt but report status — не учитываем robots.txt сайта при парсинге, однако в дополнительном меню выводится статус страницы (индексируемая или не индексируемая).

- Show internal/external URLs blocked by robots.txt — отмечаем в чекбоксах хотим ли мы видеть в итоговом отчете внутренние и внешние ссылки, закрытые от индексации в robots.txt. Данная опция работает только при условии выбора “Respect robots.txt”.

Вкладка Custom — ручное редактирование robots.txt в пределах текущего парсинга

Удобно, если вам нужно при парсинге сайта учитывать (или исключить) только определенные папки, либо же добавить правила для поддоменов. Кроме того, можно быстро сформировать и проверить свой рабочий robots, чтобы потом залить его на сайт.

Шаг 1. Прописать анализируемый домен в основной строке

Шаг 2. Кликнуть на Add, чтобы добавить robots.txt домена

Тут на самом деле все очень просто, поэтому я по верхам пробегусь по основным опциям (а в конце будет видео, где я бездумно прокликиваю все кнопки).

- Блок Subdomains — сюда, собственно, можно добавлять домены/поддомены, robots.txt которых мы хотим учитывать при парсинге сайта.

- Окно справа — для редактирования выгруженного robots.txt. Итоговый вариант будет считаться каноничным для парсера.

- Окошко снизу — проверка индексации url в зависимости от настроенного robots.txt. Справа выводится статус страницы (Allowed или Disallowed).

URL Rewriting — функция перезаписи URL «на лету»

Тут мы можем настроить перезапись урл-адресов домена прямо в ходе парсинга. Полезно, когда нужно заменить определенные регулярные выражения, которые засоряют итоговый отчет по парсингу.

Вкладка Remove Parameters

Вручную вводим параметры, которые нужно удалять из url при анализе сайта, либо исключить вообще все возможные параметры (чекбокс “Remove all”). Полезно, если у страниц сайта есть идентификаторы сеансов, отслеживание контекста (utm_source, utm_medium, utm_campaign) или другие фишки.

Вкладка Regex Replace

Изменяет все сканируемые урлы с использованием регулярных выражений. Применений данной настройки масса, я приведу только несколько самых распространенных примеров:

- Изменение всех ссылок с http на https (Регулярное выражение: http Заменить: https).

- Изменение всех ссылок на site.by на site.ru (Регулярное выражение: .by Заменить: .ru).

- Удаление всех параметров (Регулярное выражение: \?. * Заменить: ).

- Добавление параметров в URL (Регулярное выражение: $ Заменить: ?ПАРАМЕТР).

Вкладка Options

Вы рассчитывали увидеть здесь еще 100500 дополнительных опций для суперточной настройки URL Rewriting, я прав? Как бы странно это ни звучало, но здесь мы всего лишь определяем перезаписывать все прописные url-адреса в строчные или нет… вот как-то так, не спрашивайте, я сам не знаю почему для этой опции сделали целую отдельную вкладку.

Вкладка Test

Тут мы можем предварительно протестировать видоизменение url перед началом парсинга и, соответственно, подправить регулярные выражения, чтобы на выходе не получилось какой-нибудь ерунды.

CDNs — парсим поддомены, не отходя от кассы

Использование настройки CDNs позволяет включать в парсинг дополнительные домены/поддомены/папки, которые будут обходиться пауком и при этом считаться внутренними ссылками. Полезно, если нужно проанализировать массив сайтов, принадлежащих одному владельцу (например, крупный интернет-магазин с сетью сайтов под регионы). Также можно прописывать регулярные выражения на конкретные пути сканирования — т.е. парсить только определенные папки.

Во вкладке Test можно посмотреть как будут определяться урлы в зависимости от используемых параметров (Internal или External).

Include/Exclude — сканирование/удаление определенных папок

Можно регулярными выражениями задать пути, которые будут сканироваться внутри домена. Также можно запретить парсинг определенных папок. Единственный нюанс в настройках — при использовании Include будут парситься только УКАЗАННЫЕ папки, если же мы добавляем урлы в Exclude, сканироваться будут все папки, КРОМЕ УКАЗАННЫХ.

Выбираем папки для парсинга

Удаляем папки из парсинга

Примеры регулярных выражений для Exclude:

- http://site.by/obidnye-shutki-pro-seo.html (исключение конкретной страницы).

- http://site.by/obidnye-shutki-pro-seo/.* (исключение целой папки).

- http://site.by/.*/obidnye-shutki-pro-seo/.* (исключение всех страниц, после указанной).

- .*\?price.* (исключение страниц с определенным параметром).

- .*jpg$ (исключение файлов с определенным расширением).

- .*seo.* (исключение страниц с вхождением в url указанного слова).

- .*https.* (исключение страниц с https).

- http://site.by/.* (исключение всех страниц домена/поддомена).

Speed — регулируем скорость парсинга сайта

Можно выставить как количество потоков (по умолчанию 5), так и число одновременно сканируемых адресов. Влияет на скорость парсинга и вероятность бана бота, так что тут лучше не усердствовать.

User-Agent — выбираем под кого маскируемся

В списке user-agent можно выбрать от лица какого бота будет происходить парсинг сайта. Удобно, если в настройках сайта есть директивы, блокирующие того или иного бота (например, запрещен google-bot). Также полезно иногда прокраулить сайт гугл-ботом для смартфона, чтобы проверить косяки адаптива или мобильной версии.

Скажу сразу — это опция очень индивидуальна, лично я ее не пользую, потому что чаще всего незачем. В любом случае, настройка реагирования на http-заголовки позволяет определить, как паук будет их обрабатывать (если указаны нюансы в настройках). По крайней мере я так это понял.

Т.е. можно индивидуально настроить, например, какого формата контент обрабатывать, учитывать ли cookie и т.д. Нюансов там довольно много.

Custom — дополнительные настройки поиска по исходному коду

Custom Search

По сути обычный фильтр, с помощью которого можно вытягивать дополнительные данные, например, страницы, в которых вместо тега <strong> используется <bold> или еще лучше — страницы, которые НЕ содержат определенного контента (например, без кода счетчика метрики). Фактически в настройках можно задать все что угодно.

Custom Extraction

Это пользовательское извлечение любых данных из html (например, текстовое содержимое).

User Interface — обнуление настроек для колонок таблицы

Просто сбрасывает сортировку столбцов, ничего особенного, проходим дальше, граждане, не толпимся.

API Access — интеграция с разными сервисами

Для того чтобы получать больше данных по сайту, можно настроить интеграцию с разными сервисами статистики типа Google Analytics или Majestic, при условии того, что у вас есть аккаунт в этом сервисе.При этом для каждого сервиса отдельные настройки выгрузки по типам данных.

На примере GA

Authentification — настройки аутентификации (если есть запрос от сайта)

Есть два вида аутентификации — Standart Based и Form Based. По умолчанию используется Standart Base — если при парсинге от сайта приходит запрос на аутентификацию, в программе появляется соответствующее окно.

Form Based — использование для аутентификации встроенного в SF браузера (полезно, когда для подтверждения аутентификации нужно, например, пройти капчу). В данном случае необходимо вручную вводить урл сайта и в открывшемся окне браузера вводить логин/пароль, кликать recaptcha и т.д.

System — внутренние настройки самой программы

Настройки работы самой программы — сколько оперативной памяти выделять на процесс, куда сохранять экспорт и т.д.

Давайте как обычно — подробнее о каждом пункте.

- Memory — выделяем лимиты оперативной памяти для парсинга. По дефолту стоит 2GB, но можно выделить больше (если ПК позволяет).

- Storage — выбор базы для хранения данных. Либо сохранение в ОЗУ (для этого у SF есть свой движок), либо в указанной папке на ПК пользователя.

- Proxy — подключение прокси-сервера для парсинга.

- Embedded Browser — использование встроенного в программу браузера (вкл/выкл).

Mode

- Spider (Режим паука) — классический парсинг сайта по внутренним ссылкам. Просто вводим нужный домен в адресную строку программы и запускаем работу.

- List — парсим только предварительно собранный список урл-адресов! Адреса можно выгрузить из файла (From a file), вбить вручную (Enter Manually), подтянуть их из карты сайта (Download Sitemap) и т.д. Если честно, этих трех способов получения списка урлов должно быть более чем достаточно.

- SERP Mode — в этом режиме нет сканирования, зато здесь можно загружать мета-данные сайта, редактировать их и предварительно понимать как они будут отображаться в браузере. Делать все это можно пакетно, что вполне себе удобно.

Bulk export

В этом пункте меню висят все опции SF, отвечающие за массовый экспорт данных из основного и дополнительного меню отчета…сейчас покажу на скриншоте.

В общем и целом с помощью bulk export можно вытянуть много разной полезной информации для последующей постановки ТЗ на доработки. Например, выгрузить в excel страницы, на которых найдены ссылки с 3хх ответом сервера + сами 3хх-ссылки, что позволяет сформировать задание для программиста или контент-менеджера (зависит от того, где зашиты 3хх-ссылки) на замену этих 3хх-ссылок на прямые с кодом 200. Теперь подробнее про то, что можно экспортировать при помощи Bulk Export.

- All Inlinks — получаем все входящие ссылки на каждый URI, с которым столкнулся краулер при сканировании сайта.

- All Outlinks — получаем все исходящие ссылки с каждого URI, с которым столкнулся краулер при сканировании сайта.

- All Anchor Text — выгрузка анкоров всех ссылок.

- All Images — выгрузка всех картинок (урл-адресами, естественно).

- Screenshots — экспорт снимков экрана.

- All Page Source — получаем статический HTML-код или обработанный HTML-код просканированных страниц (рендеринг HTML доступен только в режиме рендеринга JavaScript) .

- External Links — все внешние ссылки со всех просканированных страниц.

- Response Codes — все страницы в зависимости от выбранного кода ответа сервера (закрытые от индекса, с кодом 200, с кодом 3хх и т.д.).

- Directives — все страницы с директивами в зависимости от выбранной (Index Inlinks, Noindex Inlinks, Nofollow Inlinks и т.д.).

- Canonicals — страницы, содержащие канонические атрибуты, страницы без указания этих атрибутов, каноникализированные (*перекрестился*) страницы и т.д.

- AMP — страницы с AMP, ссылки с AMP (но код ответа не 200) и т.д.

- Structured Data — выгрузка страниц с микроразметкой.

- Images — выгрузка картинок без альт-текста, тяжелых картинок (в соответствии с указанным в настройках размером).

- Sitemaps — выгрузка всех страниц в карте сайта, неиндексируемых страниц в карте сайта и проч.

- Custom — выгрузка пользовательских фильтров.

Reports

Здесь содержится множество различных отчетов, которые также можно выгрузить.

- Crawl Overview — в этом отчете содержится сводная информация о сканировании, включая такие данные, как количество найденных URL-адресов, заблокированных robots.txt, число сканированных, тип контента, коды ответов и т. д.

- Redirect & Canonical Chains — отчет о перенаправлении и канонических цепочках. Здесь отображаются цепочки перенаправлений и канонических символов, показывается количество переходов по пути и идентифицируется источник, а также цикличность (если есть).

- Non-Indexable Canonicals — здесь можно получить выгрузку, в которой освещаются ошибки и проблемы с canonical. В частности, этот отчет покажет любые канонические файлы, которые не отдают корректного ответа сервера — заблокированы файлом robots.txt, с перенаправлением 3хх, ошибкой 4хх или 5хх (вообще все что угодно, кроме ответа «ОК» 200).

- Pagination — ошибки и проблемы с атрибутами rel=”next” и rel=”prev”, которые используются для обозначения содержимого, разбитого на пагинацию.

- Hreflang — проблемы с атрибутами hreflang (некорректный ответ сервера, страницы, на которые нет гиперссылок, разные коды языка на одной странице и т.д.).

- Insecure Content — показаны любые защищенные (HTTPS) URL-адреса, на которых есть небезопасные элементы, такие как внутренние ссылки HTTP, изображения, JS, CSS, SWF или внешние изображения в CDN, профили социальных сетей и т. д.

- SERP Summary — этот отчет позволяет быстро экспортировать URL-адреса, заголовки страниц и мета-описания с соответствующими длинами символов и шириной в пикселях.

- Orphan Pages — список потерянных страниц, собранных из Google Analytics API, Google Search Console (Search Analytics API) и XML Sitemap, которые не были сопоставлены с URL-адресами, обнаруженными во время парсинга.

- Structured Data — отчет содержит данные об ошибках валидации микроразметки страниц.

Sitemaps

С помощью этого пункта можно сгенерировать XML-карту сайта (страницы и картинки).

Все просто — выбираем что будем генерировать. В появившемся окне при необходимости выбираем нужные параметры и создаем карту сайта, которую потом заливаем в корневой каталог сайта.

Рассмотрим подробнее параметры, которые нам предлагают выбрать при генерации карты сайта.

Вкладка Pages — выбираем какие типы страниц включить в карту сайта.

- Noindex Pages — страницы, закрытые от индексации.

- Canonicalised — каноникализированные (опять это страшное слово!) страницы . Другими словами, динамика, у которой есть rel=”canonical”.

- Paginated URLs — страница пагинации.

- PDFs — PDF-документы.

- No response — страницы с кодом ответа сервера 0 (не отвечает).

- Blocked by robots.txt — страницы закрытые от индекса в robots.txt.

- 2xx — страницы с кодом 2хх (они будут в карте в любом случае).

- 3хх — страницы с кодом ответа 3хх (редиректы).

- 4хх — страницы с кодом ответа 4хх (битые ссылки на несуществующие страницы).

- 5хх — страницы с кодом ответа 5хх (проблема сервера при загрузке).

Вкладка Last Modified — выставляем дату последнего обновления карты.

- nclude <lastmod> tag — использовать в sitemap тег <lastmod> (дата последнего обновления карты).

- Use server report — использовать ответ сервера при создании карты, либо проставить дату вручную.

Вкладка Priority — выставляем приоритет ссылки в зависимости от глубины залегания страницы.

- Include <priority> tag — добавляет в карту сайта тег <priority>, показывающий приоритет страницы.

- Crawl Depth 0-5+ — в зависимости от глубины залегания страницы, можно проставить ее приоритет сканирования для поискового робота.

Вкладка Change Frequency — выставляем вероятную частоту обновления страниц.

- Include <changefreq> tag — использовать тег <changefreq> в карте сайта. Показывает частоту обновления страницы.

- Calculate from Last Modified header — рассчитать тег по последнему измененному заголовку.

- Use crawl depth settings — проставить тег в зависимости от глубины страницы.

Вкладка Images — добавляем картинки в карту сайта.

- Include Images — выводить в общей карте сайта картинки.

- Include Noindex Images — добавить картинки, закрытые от индекса.

- Include only relevant Images with up to … inlinks — добавить только картинки с заданным числом входящих ссылок.

- Regex list of CDNs hosting images to be included — честно, так и не понял что это такое… возможно настройка выгрузки в карту сайта картинок из хостинга (т.е. можно вбить списком несколько хостов и оттуда подтянуть картинки), но это всего лишь мои предположения.

Вкладка Hreflang — использовать в sitemap атрибут <hreflang> (или не использовать).

Visualisations

Это выбор интерактивной визуализации структуры сайта в программе. Можно получить отображение дерева сканирования и дерева каталогов. Основная фишка в том, что открываются эти карты и диаграммы во встроенном браузере программы, что позволяет эффективнее с ними работать (настраивать выведение, масштабировать, перескакивать к нужным урлам через поиск и т.д.).

Crawl Tree Graph — визуализация сканирования. По факту после завершения краулинга показывает текущую структуру сайта на основании анализа.

Directory Tree Graph — показывает ВСЕ каталоги после сканирования. Т.е. отличие от Crawl Tree Graph в том, что в этом отчете показываются, например, папки, закрытые от индекса.Назначение Crawl Tree Graph и Directory Tree Graph в основном заключается в упрощении анализа структуры текущего сайта, можно глазами пробежаться по всем папкам, зацепиться за косяки (т.к. они выделены цветом). При наведении на папку, показывается ее данные (url, title, h2, h3 и т.д.).

Force Directed Crawl-Diagram — по сути то же самое, что и Crawl Tree Graph, только оформленное по-другому + показывает сканирование сайта относительно главной страницы (ну или стартовой). Кому-то покажется нагляднее, хотя по мне, выглядит гораздо сложнее для восприятия.

Force Directed Tree-Diagram — аналогично, другой тип визуализации дерева каталогов сайта.

Inlink Anchor Text Word Cloud — визуализация анкоров (ссылочного текста) внутренней ссылки. Анализирует каждую страницу по-отдельности. Помогает понять какими анкорами обозначена страница, как их много, насколько разнообразны и т.д.

Р- Разнообразие

Body Text Word Cloud — визуализация плотности отдельных слов на странице. По сути выглядит так же, как и Inlink Anchor Text Word Cloud, так что отдельный скрин делать смысла особого нет — обычное облако слов, по размеру можно определить какое слово встречается чаще, по общему числу посмотреть разнообразие слов на странице и т.д.

Каждая визуализация имеет массу настроек вывода данных, маркировки — про них я писать не буду, если станет интересно, сами поиграетесь, ок? Там ничего сложного.

Crawl Analysis

Большинство параметров сайта вычисляется пауком в ходе сбора статистики, однако некоторые данные (Link Score, некоторые фильтры и прочее) нуждаются в дополнительном анализе, чтобы попасть в финальный отчет. Данные, которые нуждаются в Crawl Analysis, помечены соответствующим образом в правом меню навигации.

Crawl Analysis запускается после основного парсинга. Перед запуском дополнительного анализа, можно настроить его (какие данные выводить в отчет).

- Link Score — присвоение оценок всем внутренним ссылкам сайта.

- Pagination — показывает петлевые пагинации, а также страницы, которые обнаружены только через атрибуты rel=”next”/”prev”.

- Hreflang — урлы hreflang без гиперссылки, битые ссылки.

- AMP — страницы без тегов “html amp”, теги не с 200 кодом ответа.

- Sitemaps — неиндексируемые страницы в карте сайта, урлы в нескольких картах сайта, потерянные страницы (например, есть в Google Analytics, есть в sitemap, не обнаружено при парсинге), страницы, которых нет в карте сайта, страницы в карте сайта.

- Analytics — потерянные страницы (есть в аналитике, нет в парсинге).

- Search Console — потерянные страницы (есть в вебмастере, нет в парсинге).

License

Исходя из названия, логично предположить, что этот пункт меню отвечает за разного рода манипуляции с активацией продукта…иии так оно и есть!

Buy a License — купить лицензию. При клике переход на соответствующую страницу официалов https://www.screamingfrog.co.uk/seo-spider/licence/. Стоимость ключа для одного ПК — 149 фунтов стерлинга. Есть пакеты для нескольких ПК, там, как обычно, идут скидки за опт.

Enter License — ввести логин и ключ лицензии, чтобы активировать полный функционал парсера.

Заметили, да? Лицензия покупается на год, не бессрочная

Help

Помощь юзеру — гайды, FAQ, связь с техподдержкой, в общем все, что связано с работой программы, ее багами и их решением.

- User Guide — мануал по работе с программой. Собственно, его я использовал, как один из источников, для написания этой статьи. При желании, можете ознакомиться, если я что-то непонятно рассказал или не донес. Еще раз оставлю ссылку https://www.screamingfrog.co.uk/seo-spider/user-guide/.

- FAQ — часто задаваемые вопросы по работе с SF и ответы на них https://www.screamingfrog.co.uk/seo-spider/faq/.

- Support — обратная связь с техподдержкой https://www.screamingfrog.co.uk/seo-spider/support/. Если программа ведет себя некрасиво (например, не принимает ключ лицензии), можно пожаловаться куда надо и все починят.

- Feedback — обратная связь. Та же самая страница, что и в Support. Т.е. можно не только жаловаться, но и вносить предложения по работе программы, предлагать партнерку, сказать банальное “спасибо” за такой крутой сервис (думаю ребятам будет приятно).

- Check for Updates и Auto Check for Updates — проверка на наличие обновлений программы. Screaming Frog нерегулярно, но довольно часто дорабатывается, поэтому есть смысл периодически проверять апдейты. Но лучше поставить галочку на Auto Check for Updates и программа сама будет автоматически предлагать обновиться при выходе нового апа.

- Debug — отчет о текущем состоянии программы. Нужно, если вы словили какой-то баг и хотите о нем сообщить разработчику. Там еще дополнительно есть настройки дебага, но я думаю, нет смысла заострять на этом внимание.

- About — собственно, краткая информация о самой программе (копирайт, сервисы, которые использовались при разработке).

Итог

Screaming Frog — очень гибкая в плане настройке утилита, с помощью которой можно вытянуть массу данных для анализа, нужно только (только… ха-ха) правильно настроить парсинг. Я надеюсь, мой мануал поможет вам в этом, хотя и не все я рассмотрел как надо, есть пробелы, но основные функции должны быть понятны.

Теперь от себя — текста много, скринов много, потому, если вы начинающий SEO-специалист, рекомендую осваивать SF поэтапно, не хватайтесь за все сразу, ибо есть шанс упустить важные нюансы.

Ну вот и все, ребята, я отчаливаю за новым материалом для нашего крутого блога. Подписывайтесь, чтобы не пропустить интересные публикации от меня и моих коллег. Всем удачи, всем пока!

Владимир Еленский

Практикующий SEO-специалист MAXI.BY media. Опыт работы более 5-ти лет. Хороший человек и просто красавчик.Все о файле «robots.txt» по-русски — как составить robots.txt

Файл robots.txt

Все поисковые роботы при заходе на сайт в первую очередь ищут файл robots.txt. Если вы – вебмастер, вы должны знать назначение и синтаксис robots.txt.

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции для поисковых роботов. Эти инструкции могут запрещать к индексации некоторые разделы или страницы на сайте, указывать на правильное «зеркалирование» домена, рекомендовать поисковому роботу соблюдать определенный временной интервал между скачиванием документов с сервера и т.д.

Создание robots.txt

Файл с указанным расширением – простой текстовый документ. Он создается с помощью обычного блокнота, программ Notepad или Sublime, а также любого другого редактора текстов. Важно, что в его названии должен быть нижний регистр букв – robots.txt.

Также существует ограничение по количеству символов и, соответственно, размеру. Например, в Google максимальный вес установлен как 500 кб, а у Yandex – 32 кб. В случае их превышения корректность работы может быть нарушена.

Создается документ в кодировке UTF-8, и его действие распространяется на протоколы HTTP, HTTPS, FTP.

При написании содержимого файла запрещается использование кириллицы. Если есть необходимость применения кириллических доменов, необходимо прибегать к помощи Punycode. Кодировка адресов отдельных страниц должна происходить в соответствии с кодировкой структуры сайта, которая была применена.

После того как файл создан, его следует запустить в корневой каталог. При этом используется FTP-клиент, проверяется возможность доступа по ссылке https://site.com./robots.txt и полнота отображения данных.

Важно помнить, что для каждого поддомена сайта оформляется свой файл с ограничениями.

Описание robots.txt

Чтобы правильно написать robots.txt, предлагаем вам изучить разделы этого сайта. Здесь собрана самая полезная информация о синтаксисе robots.txt, о формате robots.txt, примеры использования, а также описание основных поисковых роботов Рунета.

- Как работать с robots.txt — узнайте, что вы можете сделать, чтобы управлять роботами, которые посещают ваш веб-сайт.

- Роботы Рунета — разделы по роботам поисковых систем, популярных на просторах Рунета.

- Частые ошибки в robots.txt — список наиболее частых ошибок, допускаемых при написании файла robots.txt.

- ЧаВо по веб-роботам — часто задаваемые вопросы о роботах от пользователей, авторов и разработчиков.

- Ссылки по теме — аналог оригинального раздела «WWW Robots Related Sites», но дополненый и расширенный, в основном по русскоязычной тематике.

Где размещать файл robots.txt

Робот просто запрашивает на вашем сайте URL «/robots.txt», сайт в данном случае – это определенный хост на определенном порту.

На сайте может быть только один файл «/robots.txt». Например, не следует помещать файл robots.txt в пользовательские поддиректории – все равно роботы не будут их там искать. Если вы хотите иметь возможность создавать файлы robots.txt в поддиректориях, то вам нужен способ программно собирать их в один файл robots.txt, расположенный в корне сайта. Вместо этого можно использовать Мета-тег Robots.

Не забывайте, что URL-ы чувствительны к регистру, и название файла «/robots.txt» должно быть написано полностью в нижнем регистре.

Как видите, файл robots.txt нужно класть исключительно в корень сайта.

Что писать в файл robots.txt

В файл robots.txt обычно пишут нечто вроде:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

В этом примере запрещена индексация трех директорий.

Затметьте, что каждая директория указана на отдельной строке – нельзя написать «Disallow: /cgi-bin/ /tmp/». Нельзя также разбивать одну инструкцию Disallow или User-agent на несколько строк, т.к. перенос строки используется для отделения инструкций друг от друга.

Регулярные выражения и символы подстановки так же нельзя использовать. «Звездочка» (*) в инструкции User-agent означает «любой робот». Инструкции вида «Disallow: *.gif» или «User-agent: Ya*» не поддерживаются.

Конкретные инструкции в robots.txt зависят от вашего сайта и того, что вы захотите закрыть от индексации. Вот несколько примеров:

Запретить весь сайт для индексации всеми роботами

User-agent: *

Disallow: /

Разрешить всем роботам индексировать весь сайт

User-agent: *

Disallow:

Или можете просто создать пустой файл «/robots.txt».

Закрыть от индексации только несколько каталогов

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /private/

Запретить индексацию сайта только для одного робота

User-agent: BadBot

Disallow: /

Разрешить индексацию сайта одному роботу и запретить всем остальным

User-agent: Yandex

Disallow:

User-agent: *

Disallow: /

Запретить к индексации все файлы кроме одного

Это довольно непросто, т.к. не существует инструкции “Allow”. Вместо этого можно переместить все файлы кроме того, который вы хотите разрешить к индексации в поддиректорию и запретить ее индексацию:

User-agent: *

Disallow: /docs/

Либо вы можете запретить все запрещенные к индексации файлы:

User-agent: *

Disallow: /private.html

Disallow: /foo.html

Disallow: /bar.html

Инфографика

Проверка

Оценить правильность созданного документа robots.txt можно с помощью специальных проверочных ресурсов:

- Анализ robots.txt. – при работе с Yandex.

- robots.txt Tester – для Google.

Важно помнить, что неправильно созданный или прописанный документ может являться угрозой для посещаемости и ранжирования сайта.

О сайте

Этот сайт — некоммерческий проект. Значительная часть материалов — это переводы www.robotstxt.org, другая часть — оригинальные статьи. Мы не хотим ограничиваться только robots.txt, поэтому в некоторых статьях описаны альтернативные методы «ограничения» роботов.

Отправить обновленный файл Robots.txt в Google

Чтобы обновить правила в существующем файле robots.txt, загрузите копию файла robots.txt. со своего сайта и внесите необходимые правки.

Загрузите файл robots.txt

Вы можете загрузить свой файл robots.txt разными способами, например:

Отредактируйте файл robots.txt

Откройте файл robots.txt, который вы загрузили со своего сайта, в текстовом редакторе и сделайте необходимые правки в правила.Убедитесь, что вы используете правильный синтаксис и что вы сохраняете файл в кодировке UTF-8.

Загрузите файл robots.txt

Загрузите новый файл robots.txt в корень своего домена в виде текстового файла с именем robots.txt. Способ загрузки файла на свой сайт сильно зависит от платформы и сервера. Ознакомьтесь с нашими советы по поиску помощи с загрузка файла robots.txt на ваш сайт.

Если у вас нет разрешения на загрузку файлов в корень вашего домена, свяжитесь с менеджером домена, чтобы внести изменения.

Например, если главная страница вашего сайта находится в subdomain.example.com/site/example/ , вы, вероятно, не сможете обновить robots.txt

файл по адресу subdomain.example.com/robots.txt . В этом случае обратитесь в

владелец example.com/ , чтобы внести необходимые изменения в файл robots.txt.

Обновить кеш файла robots.txt Google

Во время автоматического сканирования сканеры Google замечают изменения, внесенные вами в свой роботы.txt и обновляйте кешированную версию каждые 24 часа. Если вам нужно обновить кэшировать быстрее, используйте функцию Submit из robots.txt Тестер .

- Нажмите Просмотреть загруженную версию , чтобы увидеть, что это ваша действующая версия robots.txt. что вы хотите, чтобы Google сканировал.

- Нажмите Отправить , чтобы уведомить Google об изменениях, внесенных в ваш robots.txt и попросите Google просканировать его.

- Убедитесь, что ваша последняя версия была успешно просканирована Google, обновив страницу в ваш браузер, чтобы обновить редактор инструмента и увидеть ваш действующий код robots.txt. После тебя обновите страницу, вы также можете щелкнуть раскрывающийся список над текстовым редактором, чтобы просмотреть отметка времени, когда Google впервые увидел последнюю версию вашего robots.txt файл.

Инструменты Bing для веб-мастеров упрощают редактирование и проверку ваших роботов.txt

С самого начала эпохи поисковых систем веб-мастера искали надежный и эффективный инструмент для развития и контроля их отношений любви и ненависти с веб-роботами / сканерами / пауками. Хотя протокол исключения роботов дает возможность сообщать веб-роботам и сканерам, какие разделы веб-сайта не следует обрабатывать или сканировать, растущее количество поисковых систем и параметров вынуждает веб-мастеров искать свой файл robots.txt среди миллионов папок на их хост-серверы, редактируя их без руководства и, наконец, ломая голову, поскольку проблема с этим нежелательным поисковым роботом все еще сохраняется.

Мы в Bing понимаем, что наши пользователи разочарованы, и поэтому разработали наш новый улучшенный тестер robots.txt. Тестер robots.txt помогает веб-мастерам не только анализировать их файл robots.txt и выделять проблемы, которые могут помешать оптимальному сканированию их Bing и другими роботами; но также дает им пошаговые инструкции от получения последнего файла до загрузки того же файла по соответствующему адресу.

Веб-мастера могут отправить URL-адрес в robots.txt Tester, который работает так же, как Bingbot и BingAdsBot, проверяет файл robots.txt и проверяет, был ли URL разрешен или заблокирован соответственно.

Не только это, но и функция тестирования проверяет URL-адрес, который мы отправили, на соответствие содержимому редактора, и, следовательно, после внесения изменений в редакторе вы можете легко и мгновенно повторно протестировать URL-адрес для проверки на наличие ошибок. Система проверяет наличие разрешающих / запрещающих операторов для соответствующих пользовательских агентов и отображает robots.txt в редакторе с 4 вариантами, например http: //, https: //, http: // www, https: // www. Веб-мастер может отредактировать текстовый файл и / или загрузить его для обновления в автономном режиме. Если в файл robots в другом месте были внесены изменения и были обновлены, веб-мастер может использовать опцию Fetch latest, чтобы получить последний файл robots для ресурса.

Параметр загрузки обеспечивает пошаговый процесс обновления файла, который включает в себя загрузку отредактированного файла, загрузку его в корень домена, который можно проверить на наличие действующей версии, и, наконец, запрос Bing на его обновление.

Мы рады представить эту функцию нашим пользователям, особенно теперь, когда мы перешли на новую и улучшенную платформу и возможности. Мы прислушиваемся к вашим отзывам и призываем вас связаться с нами в Твиттере и поделиться своим мнением об этом инструменте и его влиянии на расширение возможностей веб-мастеров для повышения их продуктивности. Если у вас возникнут какие-либо проблемы, обратитесь в нашу службу поддержки.

С уважением

Кумар Снехансу

Команда Bing для веб-мастеров

urllib.robotparser — Парсер для robots.txt — документация Python 3.9.7

Исходный код: Lib / urllib / robotparser.py

Этот модуль предоставляет единственный класс RobotFileParser , который отвечает

вопросы о том, может ли конкретный пользовательский агент получить URL-адрес на

Веб-сайт, на котором опубликован файл robots.txt . Подробнее о

структуру файлов robots.txt и см. http://www.robotstxt.org/orig.html.

- класс

urllib.robotparser.RobotFileParser( url = » ) Этот класс предоставляет методы для чтения, анализа и ответа на вопросы о

Файл robots.txtпо адресу url .-

set_url( url ) Устанавливает URL-адрес, относящийся к файлу

robots.txt.

-

читать() Считывает

URL-адрес robots.txtи передает его синтаксическому анализатору.

-

синтаксический анализ( строк ) Анализирует аргумент строк.

-

can_fetch( useragent , url ) Возвращает

True, если агенту пользователя разрешено получать URL-адрес по правилам содержащимся в разобранномrobots.txtфайл.

-

mtime() Возвращает время роботов

.txtбыл получен последний раз. Это полезно для давно работающих веб-пауков, которым нужно проверять наличие новыхrobots.txtфайла периодически.

-

модифицированный() Устанавливает время последней загрузки файла robots.txt

в текущую время.

-

crawl_delay( useragent ) Возвращает значение параметра

Crawl-delayот роботов.txtдля рассматриваемого юзерагента . Если такого параметра нет или он не применяется к указанному агенту или записиrobots.txtесли этот параметр имеет недопустимый синтаксис, вернитеНет.

-

скорость_запроса( агент пользователя ) Возвращает содержимое параметра

Частота запросовизrobots.txtкак именованный кортежRequestRate (запросы, секунды).Если такого параметра нет или он неприменим к агенту пользователя указан илиrobots.txtзапись для этого параметра недействительна синтаксис, возвратНет.

-

site_maps() Возвращает содержимое параметра

Sitemapизrobots.txtв виде списка(). Если нет такого параметр илиrobots.txtзапись для этого параметра имеет неверный синтаксис, вернутьНет.

-

Следующий пример демонстрирует базовое использование RobotFileParser класс:

>>> import urllib.robotparser

>>> rp = urllib.robotparser.RobotFileParser ()

>>> rp.set_url ("http://www.musi-cal.com/robots.txt")

>>> rp.read ()

>>> rrate = rp.request_rate ("*")

>>> rrate.requests

3

>>> rrate.seconds

20

>>> rp.crawl_delay ("*")

6

>>> rp.can_fetch ("*", "http: // www.musi-cal.com/cgi-bin/search?city=San+Francisco ")

Ложь

>>> rp.can_fetch ("*", "http://www.musi-cal.com/")

Правда

Nuro строит испытательный полигон, завод по производству роботов для доставки в Лас-Вегасе

Nuro, стартап, который производит автономные транспортные средства для доставки, объявил в четверг, что строит завод и закрытый испытательный полигон в Лас-Вегасе, штат Невада.

Финансируемый Softbank, Chipotle, Toyota's Woven Capital и другими, Nuro заявляет, что его два новых коммерческих объекта составят 125 000 квадратных футов площади по крайней мере на 80 акрах собственности, включая 74 акра гоночной трассы Лас-Вегаса.

Стартап инвестирует 40 миллионов долларов в объекты и нацелен на создание 250 рабочих мест в Южной Неваде на начальном этапе.